在近期的一场美空军兵棋推演演习中,专家们提出了对人工智能(AI)时代兵棋推演未来发展的看法。最频繁回应是"战争是人类活动"。他们强调人类直觉在现代战争中的核心地位,对AI随技术进步在兵棋推演中扩大作用的观点表示抵触。其核心论点为:计算机无法复现人类在真实动态战场中的适应能力,因此不应取代人类在推演中的决策输入。然而,AI恰好擅长解决复杂优化问题——而这正是兵棋推演的本质特征。

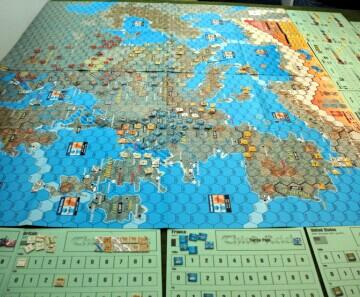

为阐明AI的潜在价值,需简要说明兵棋推演流程。(以推演为例)。推演团队由约300名军事与文职人员组成,分为蓝队(代表美国及其盟国)、红队(假想敌)与裁决组三部分。推演持续14天,每日蓝红双方提交行动方案至裁决组,由裁决组根据攻击可行性、防御机动合理性判定行动结果。

典型裁决问题包括:舰艇A是否处于攻击舰艇B的有效射程?舰艇B的防御系统如何抵御A的攻击?理想情况下,基于作战单元武器系统与防御参数的科学模型可自动生成结果,但模型往往存在局限,需依赖人工判断与直觉进行补充裁决。

例如,红蓝双方电子战能力对导弹打击的影响常超出模型预设参数。裁决组需根据未建模变量对有效打击概率进行百分比调整。整场推演中类似人工干预达数千次。由此引发质询:若每次人工输入的误差率仅10%-20%,经过误差累积后的推演战场模拟精度与实用价值将如何?

人类判断的固有缺陷

人类作为决策者的不一致性广为人知。以1981年一项研究为例:208名联邦法官对相同16个案件进行量刑判决,案件以简化形式呈现(仅提供必要犯罪事实与被告信息)。相同罪行的量刑差异平均达3.5年,而平均刑期为7年,偏差幅度显著。

行为科学家丹尼尔·卡尼曼将此类判断误差定义为"噪声"。他指出,量刑噪声可能源于多种因素,例如法官的饥饿、疲劳甚至天气状况。兵棋推演裁决者的决策同样难以避免噪声干扰。在为期两周的推演中,裁决组对数十次看似相同的交战做出不一致判定的假设具有合理性。若叠加裁决组主要由美军人员构成可能偏向有利美方结果的倾向性,则推演预测效度将遭受严重质疑。

尽管人类应始终参与推演进程,但兵棋推演的核心目标在于为国家决策层提供可信且有价值的国防政策参考模型。美陆战队大学霍纳军事理论讲席教授吉姆·莱西指出:"美国防部所有战略决策皆应通过兵棋推演进行推敲与塑造"。当前模拟系统或不足以有效支撑最高层决策。考虑到数千次不精确人工输入对推演产生的蝴蝶效应,单次推演仅能呈现数百万种可能结果之一。模型的表面合理性并不等同于实际应用价值。

人工智能的优势与局限

试想通过研究两位国际象棋大师的战术并模拟单局对弈来预测比赛结果。若棋局早期出现一步错误的兵卒移动,其对终局的影响几何?若曾涉猎棋类博弈,便知单一失误可能引发连锁反应。即便团队模拟该棋局20次,仍难以准确预判胜负。更优解法或许是:以棋手历史对局数据训练AI,令其模拟数百万种可能对局,最终基于聚合数据推断最可能结果。

此方法正应被美军应用于兵棋推演。究其本质,兵棋推演实为优化问题——全球军事力量如何行动以实现美国目标的最优解?现代战场空间变量之繁复,已超出人类独立求解的认知极限。回溯棋类隐喻,自1997年IBM深蓝AI击败国际象棋大师卡斯帕罗夫以来,AI在该领域的超越性已持续二十余年。彼时普遍认为,人类更擅长在未知情境中预判最佳行动——这一观点与当前兵棋推演界的保守思潮相呼应。但该假设在2017年再次被证伪:谷歌的AlphaGo在复杂度远超国际象棋的围棋比赛中击败世界顶级选手。

尽管人工智能能力日臻强大,其仍存在固有局限。AI对战争态势的模拟精度受限于训练数据质量——若训练数据存在缺陷,模型输出亦将失真,而历史兵棋推演数据均存在不同程度偏差。然而,AI能有效消除人类裁决者的决策噪声,生成更一致、可靠的推演模型。借助AI,决策者可回溯分析推演结果,测试关键变量调整对结局的影响,例如:某区域海军力量增强如何影响己方关键供应链封锁能力?特定空袭行动中恶劣天气对敌方防空效能的抑制程度?若脱离AI技术,解答此类问题需重新执行完整推演,其成本与可行性均不现实。

开发具备实用价值的AI兵棋推演系统或需多年投入与巨额资源,但技术可行性明确。此类系统通过兵力优化与冗余资产识别,有望节省数十亿美元开支。一旦建成,软件将大幅降低未来推演对人力和资源的需求,显著压缩研究成本。

若兵棋推演数据(即便部分)将影响兵力结构设计,则确保推演预测兼具可信度与实用价值符合军方根本利益,而最大化利用AI是实现该目标的必由之路。人类直觉在战场上不可或缺,但兵棋推演应坚持数据驱动、迭代优化原则,摆脱人类决策噪声干扰以生成最具价值的模型。AI在此领域具有天然优势,为军队革新未来冲突准备方式提供革命性工具。

参考来源:usni