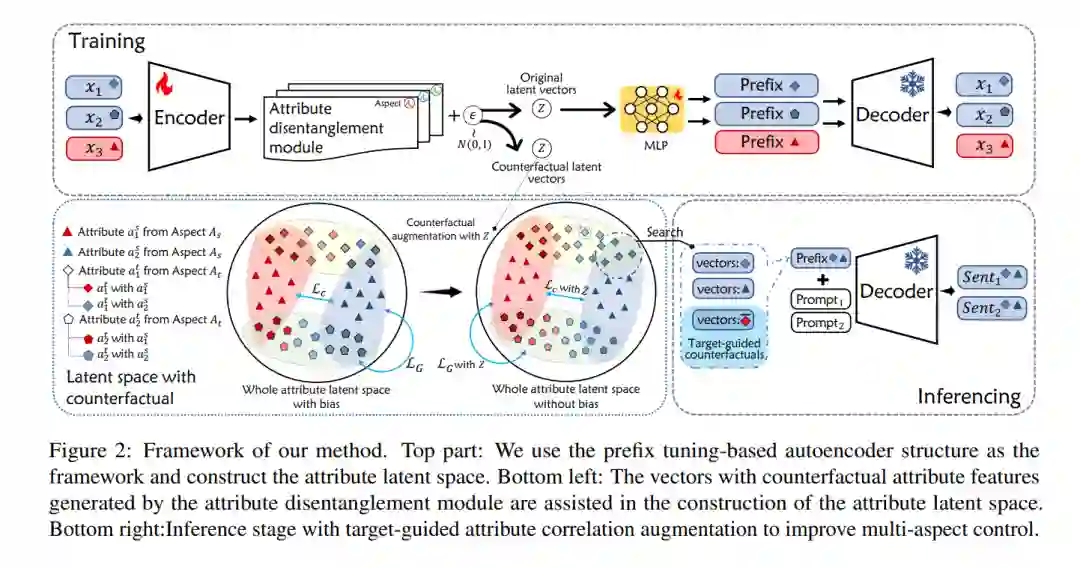

多方面可控文本生成旨在控制生成文本在多个方面的属性(例如,情感中的“积极”和话题中的“体育”)。为了便于获取训练样本,现有的工作忽略了由不同属性交织形成的属性相关性。特别是,由不平衡属性相关性形成的刻板印象显著影响多方面控制。在本文中,我们提出了一种新的多方面可控文本生成方法MAGIC,通过解耦反事实增强来实现。我们通过在属性潜在空间中使用反事实特征向量进行解耦,缓解训练过程中不平衡属性相关性的问题。在推理过程中,我们通过目标导向的反事实增强来增强属性相关性,从而进一步改进多方面控制。实验表明,MAGIC在不平衡和平衡属性相关性场景中都优于最新的基准方法。我们的源代码和数据可在https://github.com/nju-websoft/MAGIC获取。

成为VIP会员查看完整内容

相关内容

Arxiv

87+阅读 · 2023年4月4日

Arxiv

153+阅读 · 2023年3月29日