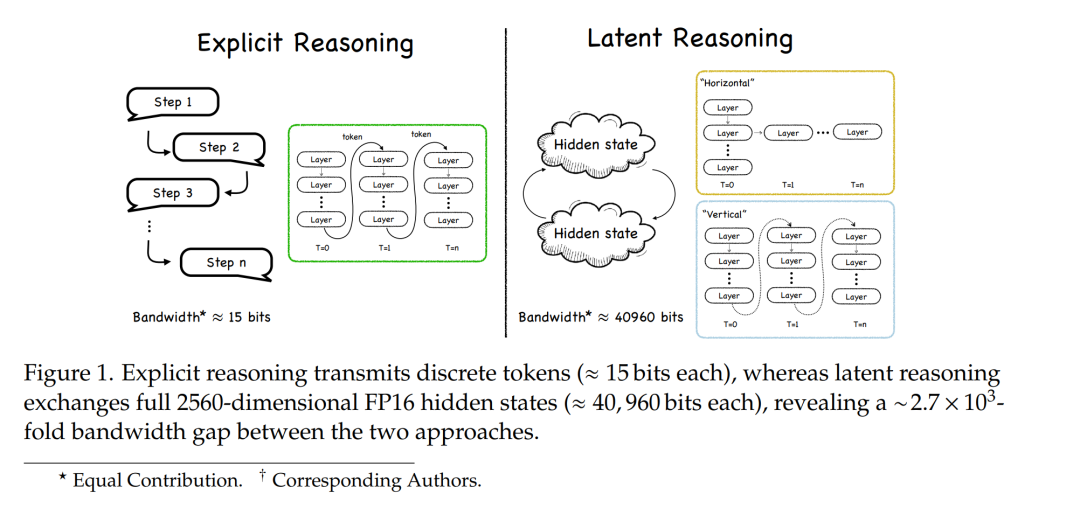

大型语言模型(LLMs)在推理任务中展现出了令人印象深刻的能力,尤其是在通过显式的思维链(Chain-of-Thought, CoT)推理引导时,其推理步骤能够以自然语言形式明确表达。尽管 CoT 在提升可解释性和准确性方面表现出色,但其对自然语言推理的依赖限制了模型的表达带宽。**潜在推理(Latent Reasoning)**试图突破这一瓶颈,其核心在于完全在模型的连续隐藏状态中执行多步推理,摆脱了对逐词监督的依赖。

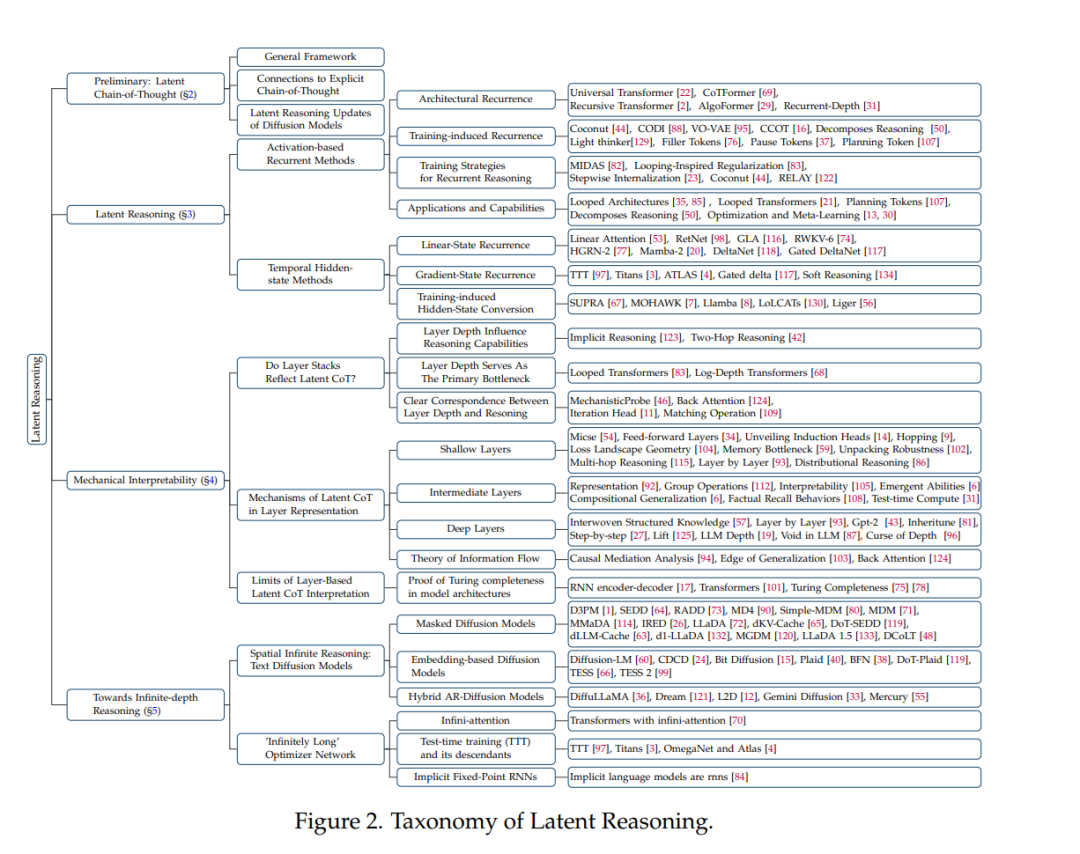

为了推动潜在推理的研究进展,本文综述了这一新兴领域的全貌。我们首先探讨了神经网络层作为推理计算基础所起到的核心作用,重点分析了层级表示如何支持复杂的变换过程。接着,我们系统梳理了多种潜在推理方法,包括基于激活的递归机制、隐藏状态的传播方式,以及用于压缩或内化显式推理轨迹的微调策略。 最后,我们讨论了一些前沿范式,例如基于掩码扩散模型(masked diffusion models)的无限深度潜在推理方法,它们能够实现全局一致且可逆的推理过程。通过整合这些研究视角,我们旨在厘清潜在推理的概念图谱,并为大型语言模型认知能力前沿的研究方向指明未来发展路径。

我们还建立了一个相关的 GitHub 项目库 LatentCoT-Horizon,收录了该领域的最新论文与代码资源,供读者参考与深入研究。

大型语言模型(LLMs)在推理任务中展现出了卓越的能力,在某些情况下甚至超过了人类水平【47, 62, 79, 128】。研究发现,当LLMs采用“思维链”(Chain-of-Thought, CoT)方式进行推理——即在得出最终答案之前,先以自然语言形式阐述每一步中间推理过程——其推理效果更为出色【110】。 最初,CoT 被视为提示工程的逻辑延伸,随着有监督的指令微调让模型暴露于大量带标注的推理轨迹中,这一方法逐渐受到关注。当强化学习开始依据答案正确性进行奖励【49】,进而鼓励模型生成有效的思维链之后,CoT 成为主流。如今,“在回答之前用语言思考”的原则已经成为诸多领先推理模型(如 Qwen3 系列【113】、DeepSeek-R1【41】和 Gemini 2.5 系列【32】)的核心机制,显著提升了模型性能。 然而,正如人类在思考时并不总是依赖语言,LLMs 的大部分计算过程实际上发生在其**潜在空间(latent space)**中。强制将 CoT 过程转化为自然语言不仅限制了模型的表达范围,还可能带来冗余的计算负担。**潜在思维链(Latent Chain-of-Thought, Latent CoT)**有望打破这一限制【23, 44】。与依赖离散词元的显式 CoT 不同,Latent CoT 在模型的连续内部表示中(往往通过循环机制)执行推理过程。这种方式具备更高的表达能力,并能探索非语言化的推理路径,从而有望开启模型推理的新前沿。 本综述聚焦于 Latent CoT 这一新兴领域,并探讨其突破基于语言推理限制的潜力。显式 CoT 需要将“思维”串联为一串词元,而 Latent CoT 则将整个推理过程转移至模型的连续表示空间之中,旨在拓展模型的表达能力并提升推理性能上限:摆脱有限词表的约束后,模型可以探索不具备直接语言对应的推理轨迹。我们对利用连续表示实现高级推理的技术方法进行了归类和分析。 本综述的结构旨在系统介绍 Latent CoT 的核心思想及其多种实现方式。我们首先建立了一个通用的形式化框架,用于概括当前大多数 Latent CoT 方法。接着,我们将其细分为两个主要类别: 1. 纵向递归(Vertical Recurrence):通过对激活值引入反馈循环来扩展计算深度,可理解为“基于激活的推理”(activation-based reasoning)【22, 69】; 1. 横向递归(Horizontal Recurrence):通过隐藏状态传播,在长推理序列中传递上下文信息【84, 97】。

随后,我们还探讨了旨在压缩或内化显式推理轨迹的微调策略,进一步丰富了对 Latent CoT 实现方法的理解。 这些内容为后续对“潜在推理机制可解释性”的理解奠定基础。我们重点讨论了神经网络各层在推理中的基础性作用【89, 131】,并引入层专化理论(Layer Specialization):该理论认为,不同层会形成层级化的功能结构——从浅层的特征提取、中层的复杂逻辑操作,到深层的整合决策,共同构成一个隐式的计算流程,功能上可类比于显式 CoT。显式 CoT 的中间词元具有一定的事后可解释性,我们也希望揭示 Latent CoT 所依赖的底层推理机制。 最后,我们讨论了 LLM 认知研究前沿的先进范式,聚焦于“无限深度推理”(infinite-depth reasoning)的探索。这一概念指的是模型能够投入无限计算步骤来持续优化推理过程,突破固定深度架构的限制。我们以文本扩散模型(text diffusion models)为例【71, 119】,探讨“空间无限推理(spatial infinite reasoning)”的实现方式:与传统的自回归生成不同,这类模型可对整个输出序列进行并行处理,借助双向上下文信息实现全局规划与迭代自我修正。这种方式支持全局一致且可逆的推理过程,为构建更强大、更灵活的 AI 系统提供了有前景的路径。