深度学习加速器旨在高效地执行深度学习,通常针对推理阶段,并且通常通过利用传统电子设备之外的物理基板。迄今为止的方法一直无法应用反向传播算法来原位训练非常规的新型硬件。反向传播的优势使其成为事实上的大规模神经网络训练方法,因此这一缺陷构成了主要障碍。康奈尔大学的研究人员介绍了一种混合原位-计算机算法,称为物理感知训练,它应用反向传播来训练可控的物理系统。该研究以「Deep physical neural networks trained with backpropagation」为题,于 2022 年 1 月 26 日发布在《Nature》。

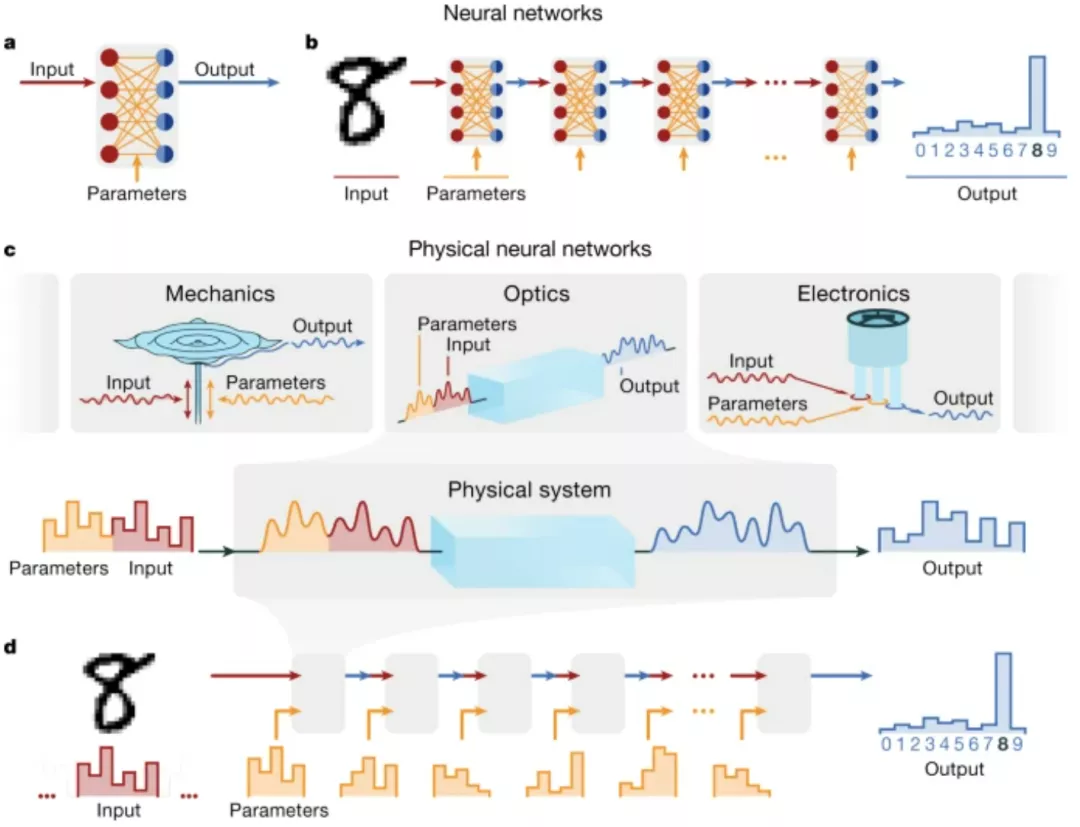

深度学习模型已经成为科学和工程领域的普遍工具。然而,他们的能量需求现在越来越限制他们的可扩展性(Patterson et al., 2020)。深度学习加速器旨在高效地进行深度学习,通常以推理阶段为目标,并经常通过利用传统电子学以外的物理基质。迄今为止的方法都无法应用反向传播算法来就地训练非常规的新型硬件。逆传播的优势使其成为大规模神经网络事实上的训练方法,所以这一缺陷构成了一个主要障碍。在这里,作者介绍了一种混合的原位硅学算法,称为物理感知训练,它应用反向传播来训练可控的物理系统。正如深度学习实现了由数学函数层组成的深度神经网络的计算一样,该方法允许我们训练由可控物理系统层组成的深度物理神经网络,即使物理层与传统的人工神经网络层缺乏任何数学同构性。

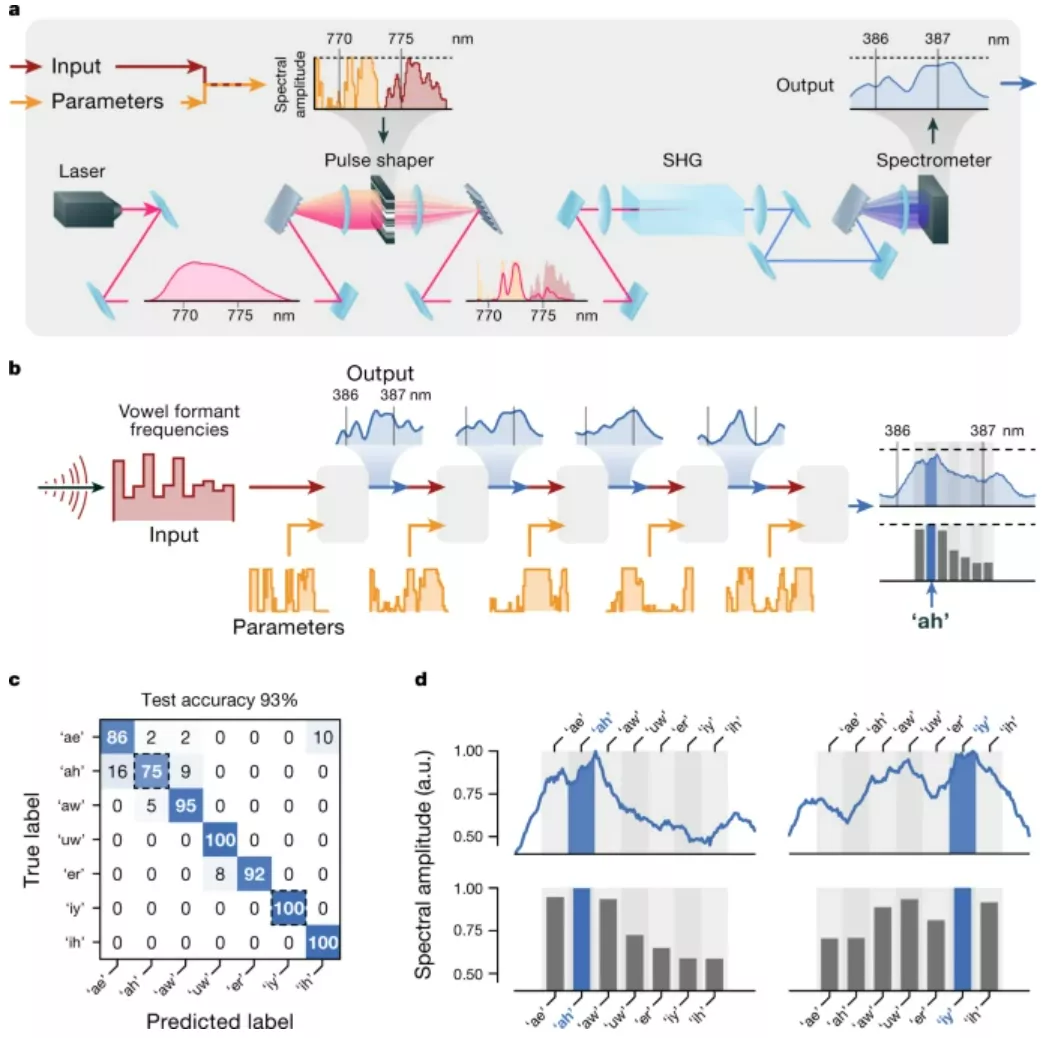

为了证明该方法的普遍性,作者训练了基于光学、机械学和电子学的各种物理神经网络,以实验方式执行音频和图像分类任务。物理感知训练结合了反向传播的可扩展性和原地算法可实现的缺陷和噪声的自动缓解。物理神经网络有可能比传统的电子处理器更快、更节能地进行机器学习,更广泛地说,可以赋予物理系统自动设计的物理功能,例如,机器人,材料和智能传感器。

https://www.nature.com/articles/s41586-021-04223-6

与人工智能的许多历史发展一样,深度神经网络(DNNs)的广泛采用部分是由协同硬件促成的。2012年,在早期工作的基础上,Krizhevsky等人表明,反向传播算法可以通过图形处理单元有效执行,以训练大型DNN进行图像分类。自2012年以来,DNN模型的计算要求迅速增长,超过了摩尔定律。现在,DNNs越来越受到硬件能效的限制。新出现的DNN能源问题激发了特殊用途的硬件。DNN "加速器 ",其中大多数是基于硬件物理和DNN数学运算之间的直接数学同构(图1a,b)。有几个加速器提案使用了传统电子学以外的物理系统,如光学和模拟电子横梁阵列。大多数设备针对的是深度学习的推理阶段,在商业部署中,推理阶段占深度学习能源成本的90%以上(Patterson et al., 2020),尽管越来越多的设备也在解决训练阶段的问题(e.g., Kohda et al., 2020)。

图示:PNN 简介。(来源:论文)

然而,通过为严格的、逐个操作的数学同构设计硬件,来实现训练有素的数学变换,并不是执行高效机器学习的唯一方法。相反,研究人员可以直接训练硬件的物理转换来执行所需的计算。在这里,研究人员将这种方法称为物理神经网络(PNN),以强调训练的是物理过程,而不是数学运算。 这种区别不仅仅是语义上的:通过打破传统的软件-硬件划分,PNN 提供了从几乎任何可控的物理系统构建神经网络硬件的可能性。正如任何模拟复杂物理系统演变的人所了解的那样,物理转换通常比数字仿真更快,且消耗更少的能量。

这表明如果最直接地利用这些物理转换的 PNN,可能会比传统范式更有效地执行某些计算,从而为可扩展、更节能和更快的机器学习提供途径。

PNN 尤其适用于类似 DNN 的计算,远远超过数字逻辑甚至其他形式的模拟计算。正如它们对自然数据的稳健处理所预期的那样,DNN 和物理过程具有许多结构相似性,例如层次结构、近似对称性、噪声、冗余和非线性。

随着物理系统的发展,它们执行的转换有效地等效于 DNN 中常用的数学运算的近似、变体或组合,例如卷积、非线性和矩阵向量乘法。因此,使用受控物理变换序列,研究人员可以实现可训练的分层物理计算,即深度 PNN。

虽然通过直接训练物理转换来构建计算机的范式起源于进化的计算材料,但它今天正在各个领域出现,包括光学、自旋电子纳米振荡器、纳米电子器件和小型量子计算机。

一个密切相关的趋势是物理储层计算(PRC),其中未经训练的物理「储层」的转换由可训练的输出层线性组合。尽管 PRC 利用通用物理过程进行计算,但它无法实现类似 DNN 的分层计算。

相比之下,训练物理转换本身的方法原则上可以克服这一限制。为了通过实验训练物理变换,研究人员经常依赖无梯度学习算法。基于梯度的学习算法,例如反向传播算法,被认为对于大规模 DNN 的高效训练和良好泛化至关重要。

因此,出现了在物理硬件中实现基于梯度的训练的建议。然而,这些鼓舞人心的提议却做出了排除许多物理系统的假设,例如线性、无耗散演化或梯度动力学很好地描述了系统。最普遍的建议通过在计算机上进行训练来克服这些限制,即完全在数值模拟中学习。尽管计算机训练的普遍性赋予了力量,但非线性物理系统的模拟很少足够准确,无法使计算机训练的模型准确地转移到真实设备。

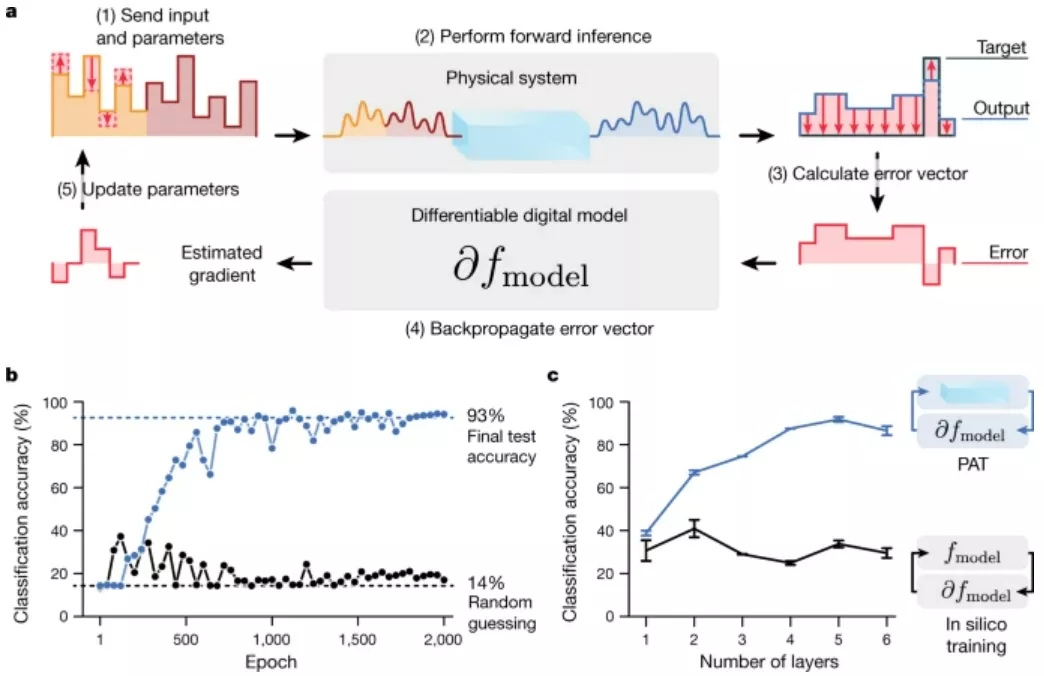

图示:物理意识培训。(来源:论文) 在这里,康奈尔大学的团队演示了一个使用反向传播直接训练任意物理系统来执行 DNN 的通用框架,即 PNN。他们的方法是通过一种混合原位 - 计算机算法实现的,称为物理感知训练(PAT)。PAT 允许研究人员在任何物理输入-输出转换序列上高效准确地执行反向传播算法。

他们通过使用三个不同的系统实验性地执行图像分类,来证明这种方法的普遍性:驱动金属板的多模机械振荡、非线性电子振荡器的模拟动力学和超快光学二次谐波产生 (SHG)。

研究人员获得了准确的分层分类器,该分类器利用了每个系统独特的物理变换,并从本质上减轻了每个系统的独特噪声过程和缺陷。

尽管 PNN 与传统硬件大相径庭,但很容易将它们集成到现代机器学习中。实验表明,PNN 可以通过物理-数字混合架构与传统硬件和神经网络方法无缝结合,其中传统硬件学习使用 PAT 与非传统物理资源进行机会合作。

最终,PNN 提供了将机器学习的能源效率和速度提高多个数量级的途径,以及自动设计复杂功能设备(例如功能性纳米颗粒、机器人和智能传感器)的途径。

参考链接: