最近在深度学习领域的进展使得生成模型能够制作出前所未有的高质量样本。然而,这些模型的真正价值来源于我们控制它们的能力。可控的合成与操作作为一种民主化工具持有潜力,使那些没有专家培训的人也能够实现创意概念,并革新多个行业:娱乐、虚拟与增强现实、电子商务及工业设计。 本论文在此领域提供四个主要贡献。

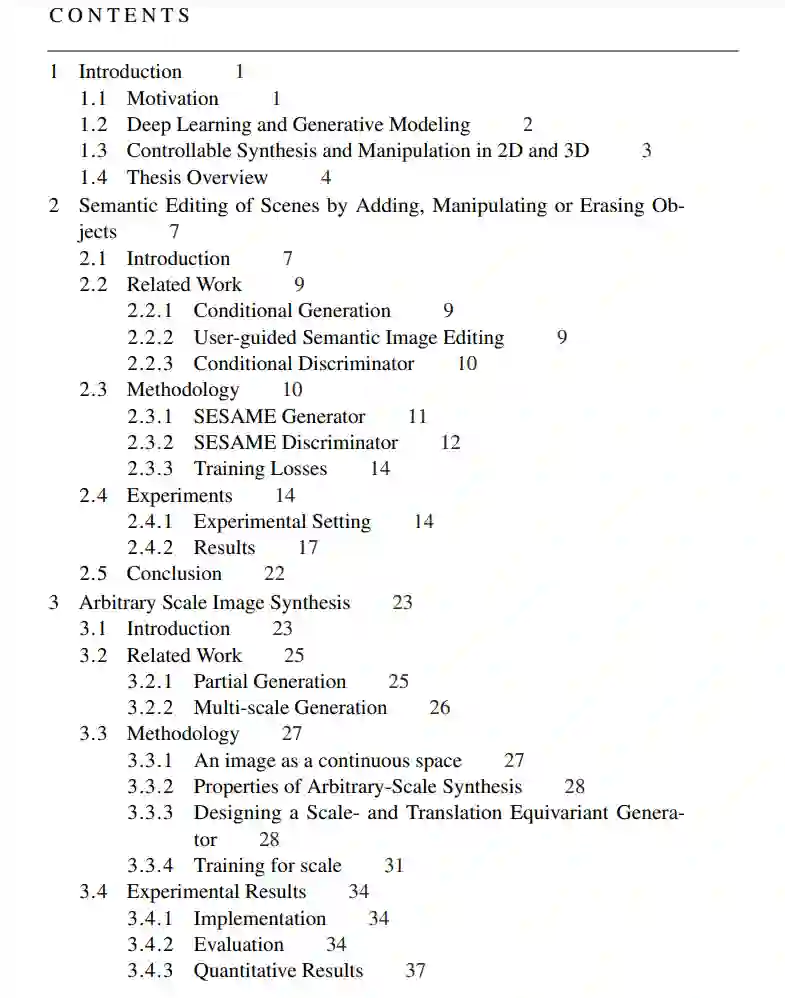

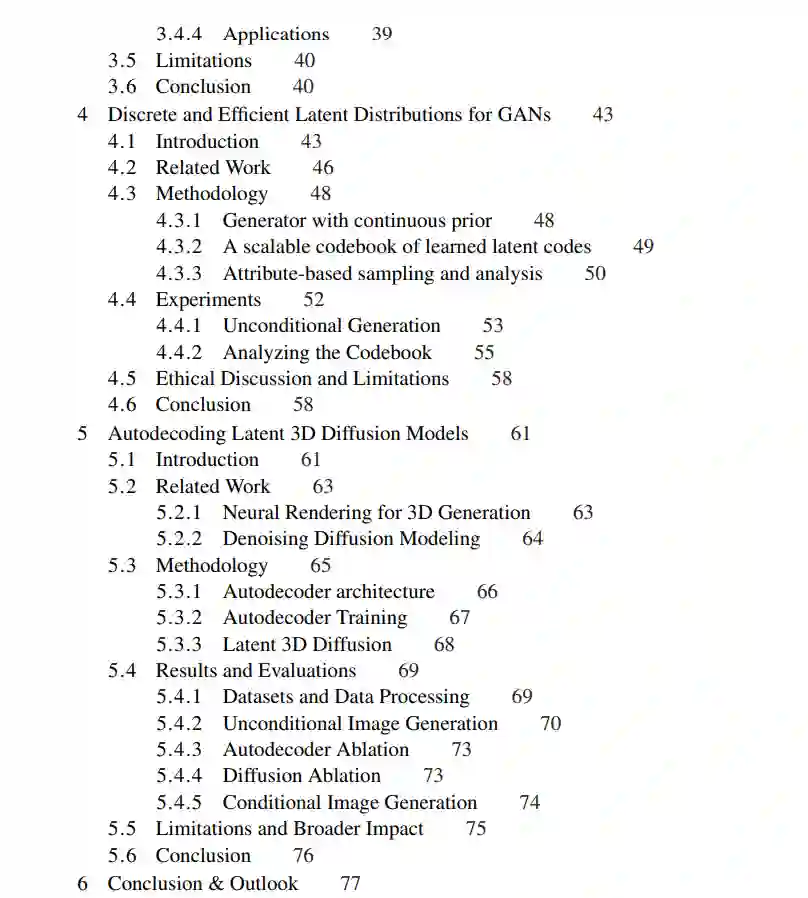

首先,我们提出了一个语义图像编辑管道,用户只需提供他们想要编辑区域的语义信息即可实现更改。我们引入了一个语义修复生成器和一个创新的双流条件判别器,使得局部控制和感知质量得以改进。 其次,我们设计了一个能够合成任意尺度图像的生成对抗网络(GAN)。我们实施了尺度一致的位置编码,并用新颖的跨尺度增强训练了一个基于补丁的生成器。我们的模型促进了一系列尺度的生成,甚至是训练期间未见过的尺度。

第三,我们建议通过连接从一系列小型可学习嵌入代码本中独立采样的子向量列表来采样GANs的潜在向量。我们展示了我们的方法仅使用有限数量的参数就能创建一个广泛且多样的潜在表示,同时通过预训练的分类器实现直观的潜在空间探索、更好的解耦和条件采样。

最后,我们引入了一个用于合成静态和可动3D资产的潜在3D扩散模型。首先,我们通过训练一个体积自解码器来重建多视图图像,学习一个紧凑的3D表示。然后,我们在自解码器的中间特征上训练潜在扩散模型。我们在多种多视图图像数据集、真实野生视频中移动的人的数据集,以及一个大规模的静态物体真实视频数据集上应用我们的方法。我们执行无条件和文本驱动的生成;我们的方法足够灵活,可以使用现有的相机监督或在训练期间有效地推断相机参数。 总之,本论文探索了不同的可控合成与图像及3D资产操作方法。我们希望我们的贡献能使我们更接近于我们的愿景:民主化内容创造和激发人类创造力。

成为VIP会员查看完整内容

相关内容

Arxiv

225+阅读 · 2023年4月7日