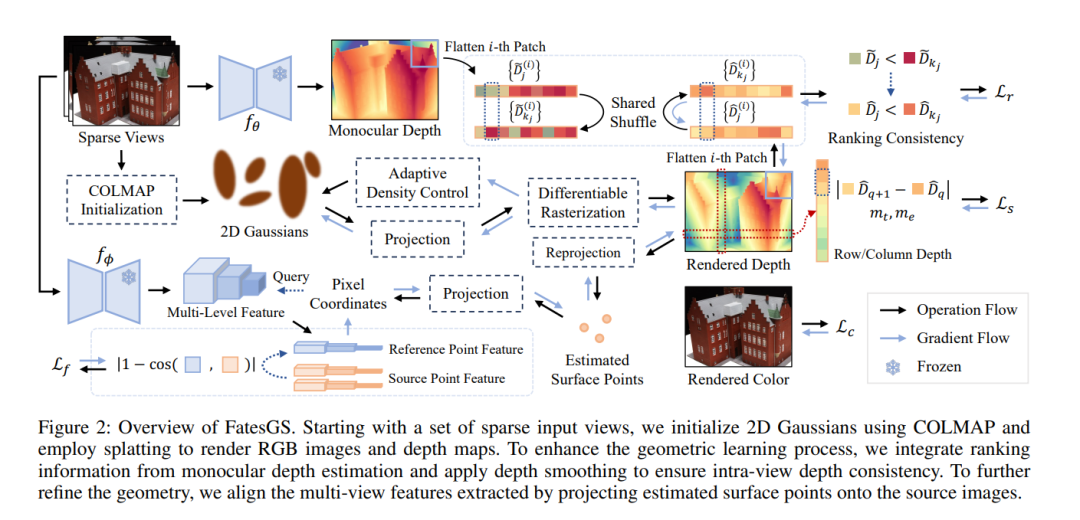

最近,高斯溅射法(Gaussian Splatting)在计算机视觉领域引发了一股新潮流。除了新颖的视图合成,它还被扩展到了多视角重建领域。最新的方法能够在保证快速训练速度的同时,实现完整且详细的表面重建。然而,这些方法仍然需要密集的输入视角,并且在稀疏视角下,输出质量显著下降。我们观察到,高斯原语(Gaussian primitives)往往会过拟合少量的训练视角,导致噪声浮动物(floaters)和不完整的重建表面。 在本文中,我们提出了一种创新的稀疏视角重建框架,利用视角内深度和多视角特征一致性,实现了显著准确的表面重建。具体而言,我们利用单目深度排名信息来监督补丁内深度分布的一致性,并采用平滑损失(smoothness loss)来增强分布的连续性。为了实现更精细的表面重建,我们通过多视角投影特征来优化深度的绝对位置。 在DTU和BlendedMVS数据集上的大量实验表明,我们的方法在速度上相比最先进的技术提升了60倍到200倍,在无需昂贵的预训练的情况下,实现了快速且细粒度的网格重建。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

224+阅读 · 2023年4月7日