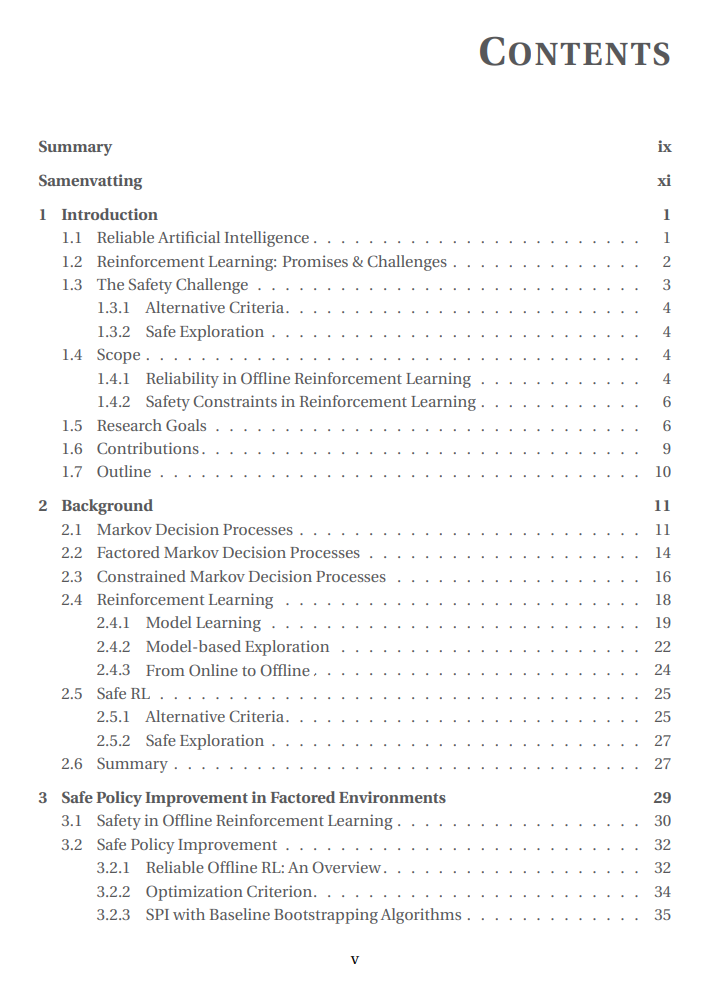

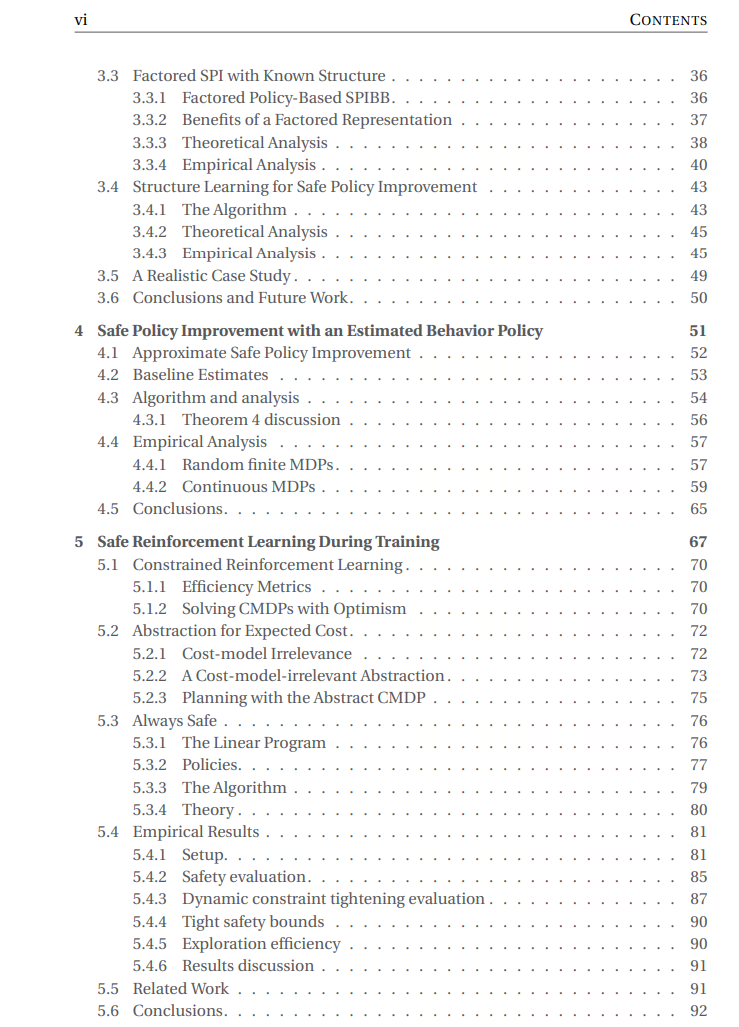

强化学习(RL)代理可以在几乎不了解底层环境的情况下解决通用问题。这些代理通过经验进行学习,采用试错策略,这种随机化过程可能会带来有效的创新,但也可能引发不良事件。因此,为了使RL在日常生活中得到应用,我们必须确保其可靠性和安全性。安全需求往往与RL代理通常进行的天真随机探索不兼容。安全RL研究如何使这些代理更加可靠以及如何确保它们行为得当。我们在在线设置中研究这些问题,即代理直接与环境交互,以及离线设置中,代理仅能访问历史数据而不直接与环境交互。

虽然RL中的安全性有许多方面,但在本论文中,我们关注两个方面。首先是安全策略改进问题,它考虑如何可靠地离线计算策略。其次是约束强化学习问题,它研究如何学习满足一组安全约束的策略。接下来,我们详细阐述这些观点以及我们如何处理它们。

第一个观点在离线设置中特别有趣。在这种设置中,我们可以想象某个决策机制一直在运行系统,我们称这种机制为行为策略。假设这些过去的决策记录在一个数据库中,我们希望使用RL来利用该数据库计算一个新策略。如果新策略可能导致与行为策略相比的显著性能下降,那么很难说服利益相关者采用RL计算的策略。因此,开发能够可靠地计算出优于行为策略的策略的算法至关重要,这样可以使决策者相信新策略不会降低底层系统的性能。安全策略改进问题正式化了这些问题。

考虑到现实世界中的数据有限且成本高昂,在第3章中,我们研究了如何通过利用底层问题的分解结构来提高安全策略改进算法的样本复杂度。具体来说,我们考虑了每个状态变量的动态仅依赖于一小部分状态变量的问题。通过利用这种结构,我们开发了RL算法,这些算法需要的样本数量比忽略这种结构的算法少得多。这种方法还可以将样本从一个状态推广到另一个状态,这使我们能够在数据只部分覆盖问题时计算改进的策略。 在许多现实世界的应用中,例如对话系统、药物测试和作物管理,数据是在人工监督下收集的,并且行为策略未知。在第4章中,我们应用安全策略改进算法,用数据构建的估计策略。我们正式提供了即使在没有直接访问行为策略的情况下,相对于行为策略的安全策略改进保证。我们在有限状态和连续状态任务上的实验证实了理论发现。

第二个安全视角与在线RL代理相关。设计一个奖励信号,使代理在最大化性能的同时保持安全并非易事。因此,最好使用约束马尔可夫决策过程(CMDP)将安全与奖励分离,在这种设置中,独立信号对安全方面建模。在这种情况下,RL代理可以自主地在性能和安全之间找到权衡。不幸的是,大多数为约束设置设计的RL代理只在学习阶段之后保证安全,这阻止了它们的直接部署。

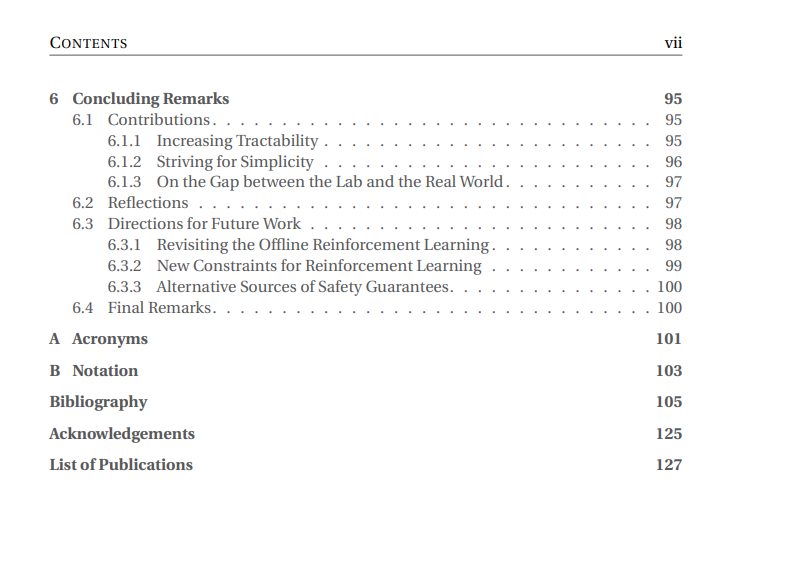

在第6章中,我们研究了给出简明抽象安全模型的设置,这是一个合理的假设,因为深入理解安全相关事宜是部署RL的前提。我们提出了一种使用此抽象模型来安全地学习策略的RL算法。在训练过程中,该算法可以在不违反安全约束的情况下无缝地从保守策略切换到贪婪策略。我们证明了在给定假设下该算法是安全的。实验证明,即使安全和奖励信号相互矛盾,该算法也始终安全运行,而当它们一致时,该方法还可以提高代理的性能。最后,我们研究了如何在不牺牲安全保证的情况下减少该算法的性能遗憾。

总而言之,我们开发了利用问题结构先验知识的新RL方法。我们提出了可以用更少数据改进策略的可靠离线算法,以及在学习过程中遵守安全约束的在线算法。除了安全性和可靠性,我们还触及了阻碍RL在现实世界任务中部署的其他问题,如数据效率和使用固定批数据进行学习。然而,我们必须记住,其他挑战,如部分可观测性和可解释性,仍需关注。希望本论文能成为结合不同类型先验知识以改进RL各个方面的垫脚石。