许多任务涉及多个智能体,需要顺序决策策略来实现共同目标,如足球比赛、实时策略游戏和道路网络中的交通灯控制。为获得所有智能体的策略,这些问题可被建模为多智能体系统,并通过多智能体强化学习(MARL)来解决。然而,由于复杂的多智能体行为和环境动态的非平稳性质,优化多智能体场景中的策略并非易事。智能体的行为及其与其他智能体的互动导致环境状态和智能体观察随时间变化,使得开发长期有效的策略成为挑战。此外,部分可观测性(智能体对环境的信息有限或不完整)也增加了问题的复杂性。而且,环境动态的固有不确定性使得决策变得不稳定。

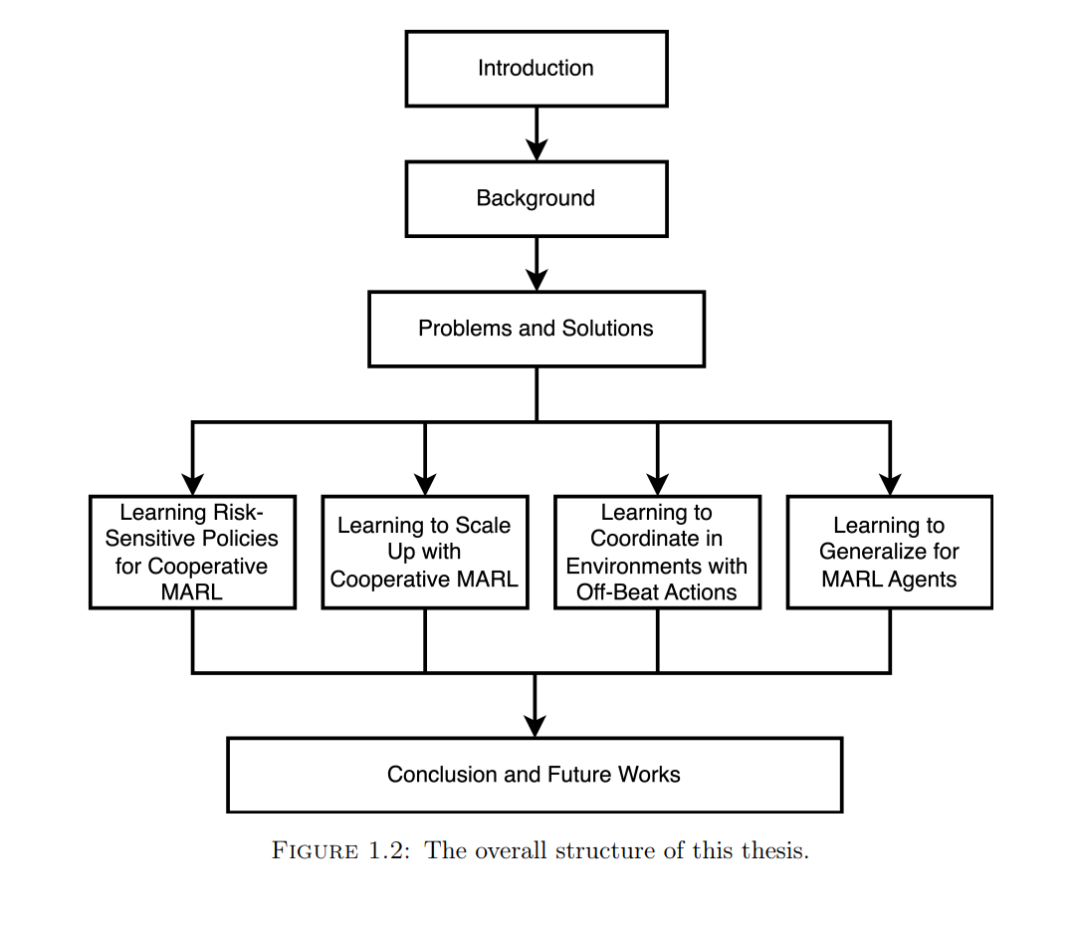

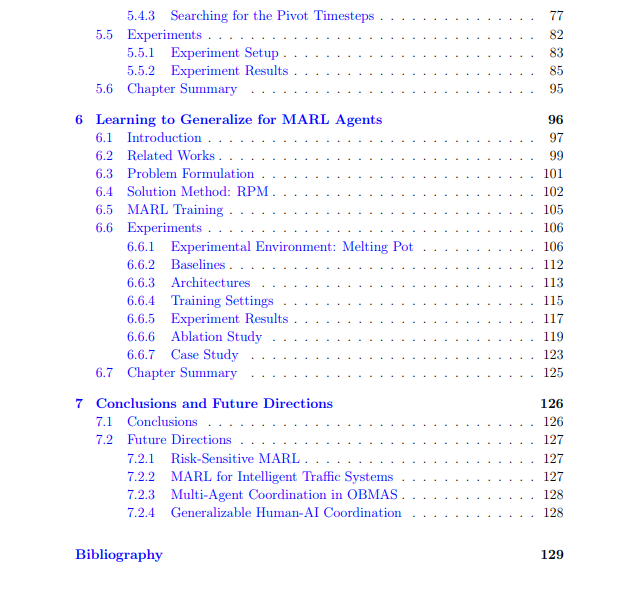

这篇博士论文通过提出新颖的MARL方法来应对这些挑战。这些新方法使智能体能够在动态且部分可观测的环境中学习高效的策略,尤其是在需要合作的环境中。特别是,我们针对以下四个基础的多智能体研究问题提出了解决方案。首先,我们研究了在风险较高的场景中为智能体学习风险敏感的合作策略的问题,这些场景的特点是执行潜在低回报行为可能导致重大的潜在奖励损失。特别是,我们关注那些团队内部存在智能体异质性且对手可能数量众多的环境。为应对此问题,我们提出了RMIX来学习MARL中的风险敏感合作策略。我们首先通过分布式强化学习来模拟个体的Q值分布。然后我们利用条件风险价值(CVaR)来衡量个体回报的分布。我们还提出了一个动态风险水平优化器来处理执行过程中随机 结果的时间性质。实证结果表明,RMIX在多种多智能体风险敏感场景中的表现优于现有最先进方法,它展示了更好的协调能力和提高了样本效率。

接着,我们研究了在动态电子收费(DETC)问题中学习可扩展策略的问题,其中交通网络庞大且动态变化。为此,我们提出了一种新颖的MARL方法,通过将大型状态分解为更小的部分,对每个分解后的状态学习多智能体策略,从而扩展DETC的处理范围。具体来说,我们将图网络分解成更小的图,并提出了一种新型的基于边的图卷积神经网络(eGCN),以提取道路网络特征的时空关联性。提取出的特征被输入到合作MARL方法的策略网络中。实验结果表明,这种分而治之的方法能够扩展到现实规模的问题,并且性能稳健,显著优于现有最先进方法。

第三,我们关注在行动持续时间的场景中学习高效多智能体协调策略的问题。由于行动持续时间的存在,奖励被推迟,使得基于时间差异的MARL策略训练变得具有挑战性。为了解决这个问题,我们提出了一种基于我们新颖的基于图的情节记忆LeGEM-core的奖励重分配方法,以在非同步行动普遍存在的环境中学习高效的多智能体协调。非同步行动指的是具有行动持续时间的行动,在此期间环境变化受到这些行动的影响。LeGEM-core明确记忆智能体的过去经验,并在MARL训练中实现信用分配。我们将这种解决方案命名为LeGEM。我们在包括Stag-Hunter Game、Quarry Game和Afforestation Game在内的多种多智能体场景中评估LeGEM。实证结果显示,它在具有非同步行动的多智能体环境中显著提升了多智能体协调能力,并实现了领先的性能。 最后,我们的目标是学习能使智能体在训练期间未见过的其他智能体的策略中进行协调或竞争的通用策略。我们提出了RPM,用于在评估场景中学习面向智能体的通用策略,这些场景中其他智能体的行为不同。RPM的主要思想是通过收集大量多智能体互动数据来训练MARL策略。我们首先根据每个智能体的训练集回报对其策略进行排名,然后将排名的策略保存在内存中;当一个情节开始时,每个智能体可以从内存中随机选择一个策略作为行为策略。这种新颖的自我博弈框架在训练数据中多样化了多智能体互动,并提高了MARL的泛化性能。Melting Pot上的实验结果表明,RPM使智能体能够在多智能体泛化评估场景中与未见过的智能体进行交互,并取得了提升的性能。

总结来说,这篇博士论文调查了四个普遍存在且未解决的基础多智能体顺序决策研究问题。所提出的四种MARL方法解决方案,在潜在奖励损失、大状态空间问题、行动持续时间和MARL泛化性缺乏所引起的不确定性多智能体环境中,为智能体提供了高效的策略训练和性能提升。