本文探讨了如何通过将模型与知识表示相结合,使得自然语言理解与生成受益于变换器模型(Transformers)。目前,训练语言模型最普遍的范式是通过在大量原始文本数据上进行预训练,并在下游任务上进行微调。尽管语言模型持续进步,特别是最近大型语言模型(LLMs)如ChatGPT的趋势,似乎仅依靠文本数据所能达成的成就存在限制,研究应用并整合丰富的知识表示形式以提升模型性能是可取的。 语言建模最广泛使用的知识形式是结构化知识,它以实体及其关系组成的三元组形式存在,通常是英语。本文超越了这种传统方法,旨在解决几个关键问题:

- 实体的知识是否可以延伸其益处,超出实体中心任务,如实体链接?

- 我们如何忠实有效地从原始文本中提取这样的结构化知识,尤其是嘈杂的网络文本?

- 除了结构化知识之外,其他类型的知识如何有助于改进自然语言处理(NLP)任务?为此,我们研究了包括多模态和多语言应用在内的各种任务,并考虑了广泛的知识谱系,包括通常以实体及其关系三元组形式表示的结构化知识,以及在语言模型中保存的参数化知识、从大型语言模型中提炼的知识等非结构化知识。

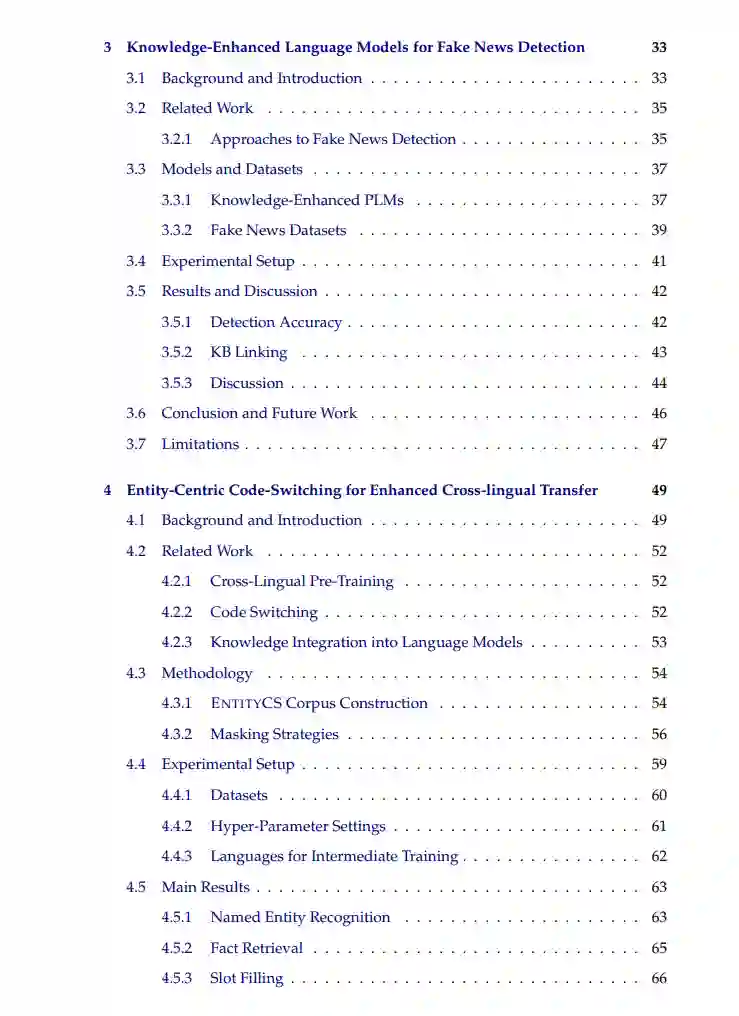

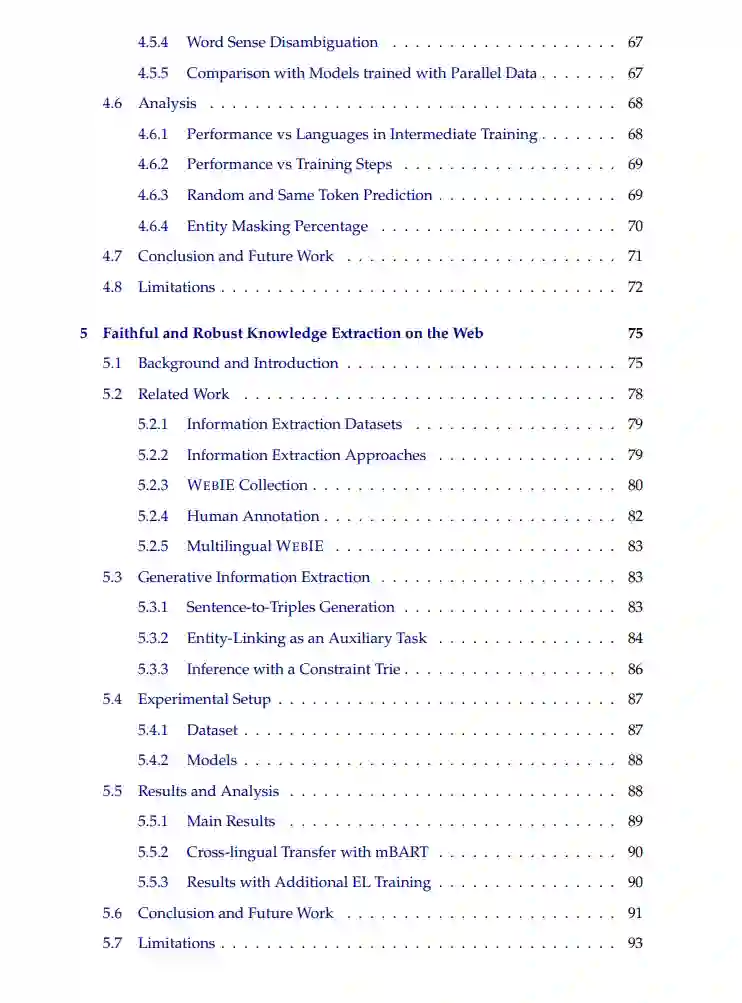

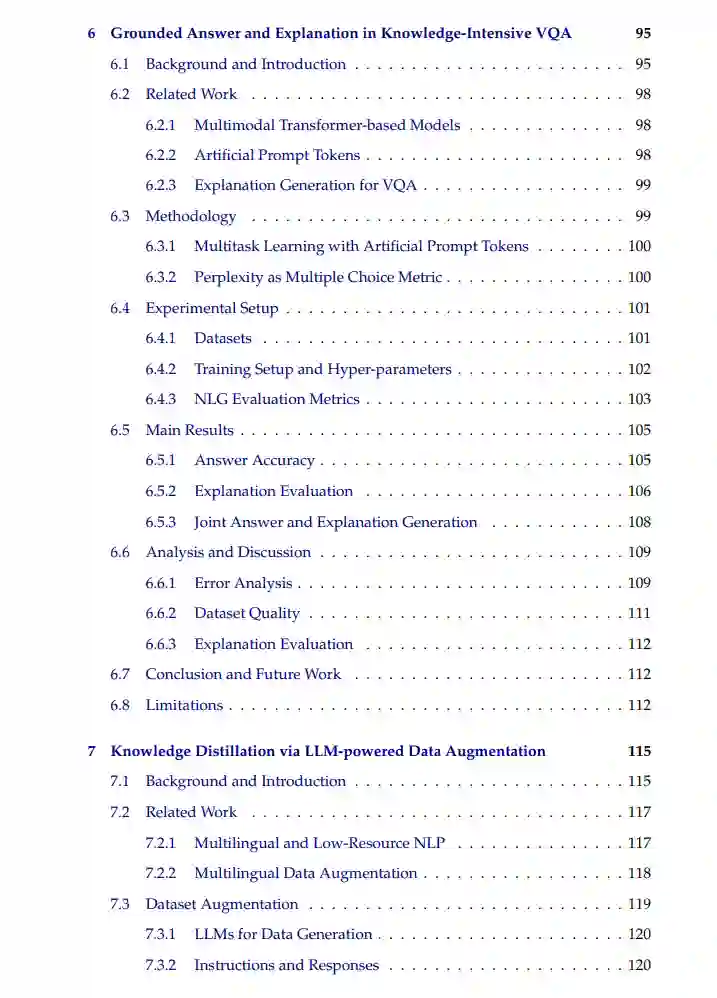

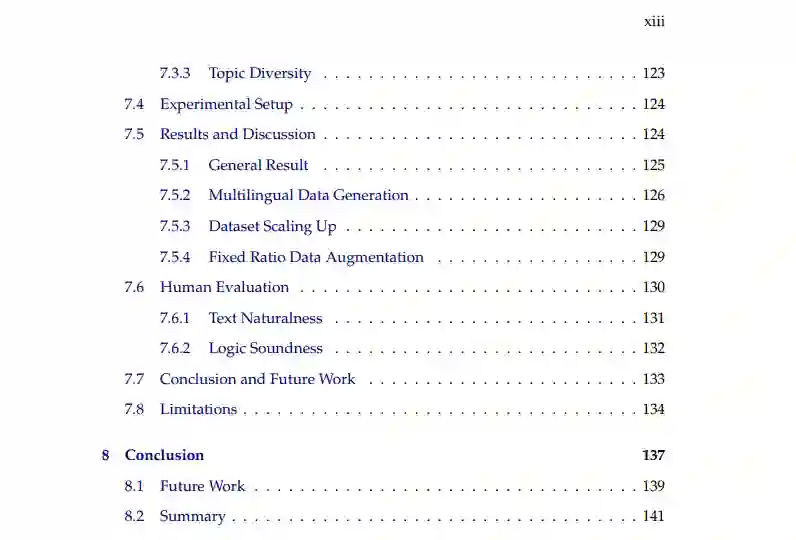

以结构化知识为基础的知识增强。 我们首先探索将结构化知识整合进语言模型。实体的知识已显示出对实体中心任务如实体链接和关系提取的好处,然而,大多数研究局限于单语环境。我们在两个研究方向上扩展了以结构化知识,特别是实体为基础的知识增强。 首先,我们研究实体的知识是否能够有利于真实世界的假新闻检测。我们假设嵌入在实体中的世界知识可以有助于评估新闻声明的真实性。在不同数据集上评估各种知识整合方法显示,当结合相关且最新的知识库时,知识增强的语言模型改善了假新闻检测。 第二个方向超越英语,专注于多语言实体。我们引入了EntityCS,其中我们首先从Wikipedia构建了一个代码切换(CS)训练语料库,通过将英文中的实体切换到其他语言的对应实体。然后我们对这个语料库进行预训练的多语言模型进行中间训练,用于联合掩码语言建模和实体预测。模型在实体中心下游任务上的后续微调一致地改善了零样本跨语言传递能力,展示了整合多语言实体知识的好处。 从网络文本中提取结构化知识。 我们继续研究有效、忠实且稳健地从网络文本中提取结构化知识。大多数现有的信息提取(IE)数据集局限于维基百科文章,而在这样的丰富事实文本语料库上训练的模型应用于网络上更嘈杂的文本时表现不佳。为应对这些挑战,我们引入了WebIE,一个新的数据集,它以原始句子作为输入,以结构化三元组作为输出。WebIE通过引入负面示例并进行严格的人工标注,强调了数据质量。我们还提出了忠实的生成式信息提取管道。我们的实验表明,通过实体规划训练和前缀字典解码,在网上准确提取知识方面取得了改进。 超越结构化知识的知识增强。 为了解答我们的最后一个研究问题,我们研究了更广泛意义上的知识(包括从模型的自我解释中得出的参数化知识和通过数据增强从LLMs中提取的知识)对改善NLP任务的影响。 我们将应用扩展到多模态语言模型,并研究知识密集型的视觉问答(VQA)。我们引入了一种统一方法,用于微调多模态模型,以联合生成答案和解释。我们的实验展示了答案准确性和解释质量的提升。 最后,随着LLMs在性能和规模上的持续进步,我们探索了从通用LLMs中提炼常识知识以惠及更小的任务特定模型的实用性。我们提示各种LLMs生成关于几个挑战性和稀缺的多语言常识数据集的多样化示例。这种增强显示了在微调较小模型上的一致改进,为训练数据有限的情景提供了数据增强策略的新视角。

总结来说,本文探讨了在自然语言理解和生成中知识增强的作用,覆盖了广泛的任务。我们发现,结合相关且最新的实体知识有助于假新闻检测,并且针对实体中心任务的实体焦点代码切换显著增强了零样本跨语言转移。在有效且忠实地提取结构化知识方面,我们的研究发现,整合负面示例和使用实体规划训练显著提高了性能。此外,我们确定了其他一般形式的知识,如参数化和提炼知识,增强了多模态和多语言知识密集型任务。这项研究展示了多样化知识整合的实际好处,并激发了进一步探索这一方向的动机。