在包括强化学习和自主导航在内的众多领域,使用生成式模型进行规划已成为一种有效的决策范式。虽然每个时间步的连续重新规划看似直观,因为它允许根据最新的环境观察结果做出决策,但它却带来了巨大的计算挑战,这主要是由于生成式模型的底层深度学习架构非常复杂。本工作通过引入一种简单的自适应规划策略来应对这一挑战,该策略利用了生成式模型预测长视距状态轨迹的能力,能够连续执行多个行动,而无需立即重新规划。建议利用从反动力学模型深度集合中得出的预测不确定性来动态调整规划会话之间的间隔。在 OpenAI Gym 框架内对运动任务进行的实验中,证明了自适应规划策略可以将重新规划的频率降低到大约 10%,而不会影响性能。研究结果凸显了生成式模型作为高效决策工具的潜力。

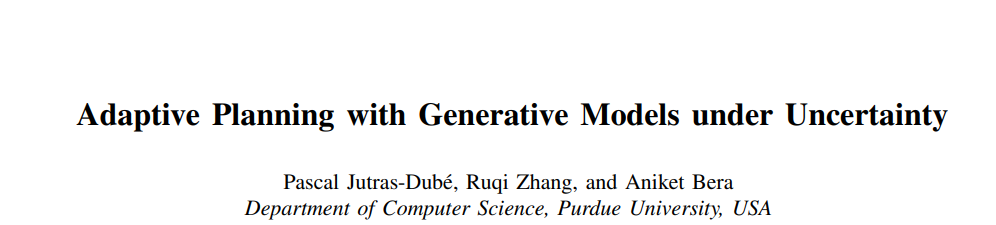

图 1:生成式模型生成状态轨迹,行动模型计算初始行动。只要不确定性保持在预定阈值以下,策略就会持续预测并执行后续行动。

近年来,以 DALL-E [1] 和 Stable Diffusion [2] 等图像合成模型的开发为标志,生成式模型领域取得了变革性的进展。这一技术进步已扩展到根据文本提示生成高质量视频[3]、[4]。与此同时,GPT[5] 等语言模型在根据简短的文本提示生成连贯文本和进行对话方面也取得了重大进展。

最近,生成式模型被应用于离线强化学习(RL),其目标是从以前收集的数据集中推导出最优策略。预测未来状态和行动的挑战可表述为序列建模任务,可通过生成式模型来解决 [6]、[7]、[8]。

然而,由于生成式模型的深度神经网络架构,状态预测过程会产生大量计算成本[9]、[8]。在实时决策应用中,这些计算需求可能会成为一个问题,因为在这种应用中,代理必须在时间受限的控制环路中迅速采取行动,根据新的环境观测结果规划或调整其轨迹。

为提高生成式模型的采样效率,人们做了大量的工作,但专门针对决策环境开发的策略却寥寥无几。大多数解决方案都是针对其所使用的生成式模型的特定结构特征而量身定制的[9], [10]。这些针对特定模型的方法虽然有效,但受限于它们对不同模型的适用性有限。

在这项工作中,引入了一种新方法,利用决策问题的固有结构来提高控制过程的效率。我们使用一个生成式模型来预测未来环境状态的轨迹,并使用一个更小的行动模型来确定基于该轨迹的下一步行动。虽然使用生成式模型进行规划需要大量计算,但它可以预测较长的未来状态。根据这一观察结果,我们的方法会连续执行多个行动,从而减少调用生成式模型的频率。为了确定更新计划和重新调用生成式模型的最佳时间,我们将行动模型预测的不确定性作为指导标准。拟议的自适应策略如图 1 所示。

我们的工作有以下贡献。

-

引入了一种简单的自适应策略,通过利用行动模型的置信度来增强生成式模型的规划流程,从而加快决策速度。与现有解决方案不同的是,我们的方法可普遍应用于不同的生成式模型,无需进行任何改动。我们的方法利用深度集合(Deep Ensembles)[11]进行高效预测不确定性估计,允许根据模型的置信度对规划进行动态调整。

-

使用 D4RL 基准 [12] 对我们的方法进行了全面评估。结果表明,我们的方法可以实现比现有技术快 50 多倍的规划速度。速度提高的同时,对奖励没有影响或影响极小。

本文其余部分的结构如下: 第二节回顾了相关工作,强调了决策中的生成式模型和提高采样速度的努力,重点是扩散模型。第三节将离线 RL 概念化为序列建模任务,详细介绍了如何将问题分成两个阶段:在较长的时间跨度内生成状态序列,然后进行行动预测。第四节介绍了我们利用深度集合(Deep Ensembles)的新颖自适应策略。第五节检验了我们的自适应策略的实证性能,强调了它在速度和功效之间的有效平衡。本文最后的第六节总结了我们的发现,讨论了局限性,并概述了未来的研究方向。