本研究探讨超视距(BVR)环境下的2v2空战机动问题(ACMP)。通过构建离散时间、无限视野的马尔可夫决策过程(MDP)模型对BVR-ACMP进行建模,旨在为双机协同的自主飞行器确定执行战术机动与火力决策的高质量策略。高级仿真、集成与建模框架(AFSIM)被用于表征复杂的六自由度(6-DOF)飞行器动态,涵盖运动学、传感器与武器系统特性。鉴于状态与决策变量的高维度和连续性特征,研究采用深度强化学习(RL)解决方法,通过神经网络(NN)实现价值函数近似。研究内容包括设计中立初始状态场景用于训练,并评估对抗行为与导弹特性对决策策略的影响。通过三阶段超参数调优实验获取高质量策略,并开展多案例研究验证深度RL方法在空战行为建模中的有效性,论证了该方法为基于AFSIM的空战仿真研究生成飞行器行为模型的可行性。

人工智能(AI)方法论的持续发展,包括强化学习(RL)的进步,对全球军事力量而言既是复杂化的挑战,也是战略机遇。2022年美国《国家国防战略》明确指出AI技术进步带来的复杂性,强调美国对手可能引入复杂的升级动态,并对美国战略稳定性构成新型挑战。尤其是受这些技术飞跃推动的自主系统广泛扩散,使军事力量面临来自非国家行为体与政府实体通过技术削弱其优势的潜在脆弱性。针对这些已识别的威胁,美国空军(USAF)认识到AI在增强自身能力、决策流程与作战效能方面的潜力。随着联合部队作战日益依赖数据驱动技术,美国国防部(DoD)计划实施机构改革,通过提供竞争性激励与更灵活的任务分配来强化AI研发。此外,推动强化学习领域的国内进展可为美国空军的一项核心任务——获取对对手的空中优势——提供支持力量。自主载具系统领域,尤其是空中领域的自主系统,对美国空军具有重大战略意义。随着该研究领域的技术突破,美国军方必须正视AI对实现空中优势的潜在威胁与利益。

美国空军正与国防高级研究计划局(DARPA)合作推进自主无人战斗飞行器(AUCAVs)领域的技术发展。DARPA“空战演进”(ACE)项目下开发的AI算法已成功完成概念验证,展示了AI指挥全尺寸战斗机并在模拟视距内(WVR)环境中超越经验丰富的F-16战斗机飞行员的能力。然而,在视距内学习算法取得进展的同时,雷达制导导弹的进步使得从超视距(BVR)发起攻击成为可能,为空战策略带来了新挑战。

超视距(BVR)空战的起源可追溯至第二次世界大战后,其标志性事件是1946年美国海军研发的AIM-7“麻雀”导弹的问世。在冷战的紧张态势中,苏联轰炸机或战斗机可能配备新兴BVR导弹技术被视为对美国国家安全利益的重大威胁。尽管这一威胁从未真正实现,但随着冷战接近尾声,战斗机领域先进机动性与导弹技术的融合显著推动了BVR空战活动的发展。与受光照条件、目标尺寸、视觉敏锐度及目标方位等因素高度影响的视距内空对空(A2A)作战不同,现代BVR空战的机制主要围绕远程制导导弹的使用展开。在实际作战场景中,配备先进雷达系统的技术优势战斗机通过此类高精度远程导弹实现对敌机的压制。BVR空战的性质带来了独特挑战:由于缺乏成熟的战斗机战术与敌我识别(IFF)技术,飞行员常面临有效运用此类武器的局限性。为解决这些难题,基于强化学习(RL)的人工智能方法有望突破这些限制,提升美国空军(USAF)及其作战人员在BVR场景下的能力。

自主载具训练的传统策略通常采用基于规则的逻辑,即自主智能体根据预定义标准做出决策。然而,该方法已被证明易受挫败,且无法为此复杂问题提供新颖的智能解决方案。针对基于规则逻辑的局限性,强化学习(RL)提供了一种解决途径,其核心在于考虑目标导向型智能体在不确定环境中的整体交互问题。RL具备运用先进搜索技术的能力,例如AlphaZero算法在象棋等复杂游戏中实现超越人类水平的性能即为明证。空对空作战固有的复杂性与不确定性要求开发独特且具有挑战性的战略方法。

强化学习已展现出为这一多维度问题设计制胜策略的能力,泰勒(Taylor)、波普(Pope)等人、麦格鲁(McGrew)等人、朴(Piao)等人以及克伦帕克(Crumpacker)等人早期的研究均对此进行了验证。麦格鲁等人开创性地采用基于模型的方法解决空战机动问题(ACMP),为后续ACMP的无模型研究奠定了基础。在麦格鲁等人工作的基础上,朴等人提出了一种端到端的基于RL的竞争性空战智能体训练方法。泰勒则致力于以独特方法填补超视距空战机动问题(BVR-ACMP)研究领域的空白,其利用Q-Learning对1v1 BVR作战场景中的自主无人战斗飞行器(AUCAV)进行建模,以优化其作战机动与武器运用能力。

本研究主要扩展泰勒(Taylor)的研究成果,旨在设计与评估一种基于强化学习(RL)的方法,以解决双机对抗(2v2)超视距空战机动问题(BVR-ACMP),并通过概念验证填补文献空白——该验证不仅评估潜在新型武器能力,还探索两架自主无人战斗飞行器(AUCAV)因交互与通信产生的涌现行为。本研究通过多种通信方案及其实施路径的探究,确定双AUCAV在空战中高效协同与通信的最优模式。

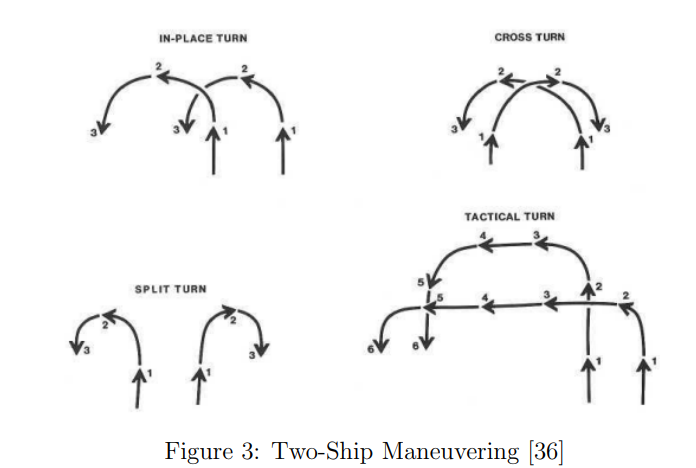

本研究将2v2 BVR-ACMP概念化为马尔可夫决策过程(MDP)。求解MDP需要在既定策略集中识别出能够优化该MDP对应准则的最优策略。泰勒的研究聚焦于1v1场景,其模型负责控制一架飞行器相对于被称为敌机的对抗目标进行定位。本研究中引入的2v2场景显著增加了环境模型的复杂性。为模拟真实战场条件,研究在概念验证中引入第二架敌机实施监视,要求每个智能体在机动过程中追踪三架飞行器。除了每个智能体需追踪敌我双方战斗机的复杂性外,友方战斗机之间还需一定程度的协同合作,以在空战中实现最优结果。这种合作体现为友方战斗机在机动与导弹部署方面的战略协调,从而有效压制敌方编队。

为应对2v2 BVR-ACMP带来的更高复杂度,本研究采用深度Q学习(DQN)算法的能力。DQN作为Q学习算法的进阶版本,通过神经网络优化长期累积奖励。研究中使用的RL方法依托政府所有的C++仿真框架——高级仿真、集成与建模框架(AFSIM)构建空战环境。AFSIM专为开发与实施交战级、任务级分析仿真及虚拟实验设计,具备空战战术建模、武器运动学模拟与传感器系统仿真的能力。作为研究的基础平台,AFSIM支持RL解决方案的实现,并协助生成效能指标(MOE)。这些指标(如任务成功率(友方成功交战次数)与交战时长)为评估RL算法性能提供了量化依据。

本研究的剩余章节分为四部分,分别聚焦2v2 BVR-ACMP的不同维度。第二章系统综述现有BVR-ACMP相关文献,深入解析1v1 BVR-ACMP并探讨其他潜在解决方案。第三章阐述本研究针对2v2 BVR-ACMP的RL方法,详细解释构建的模型框架。第四章展示模型运行结果及基于AFSIM环境生成的效能指标。第五章总结研究成果,提出未来研究方向,并给出2v2 BVR-ACMP研究的最终结论。