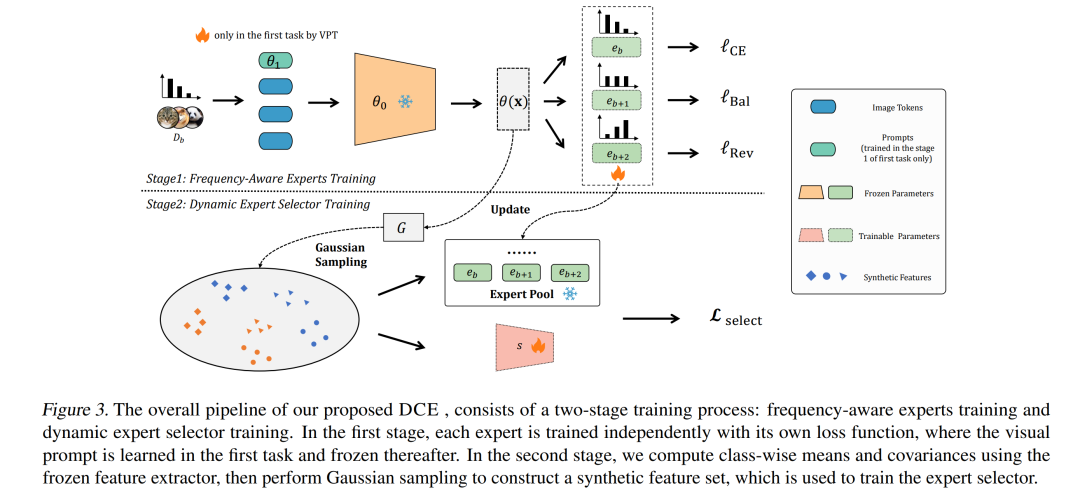

领域增量学习(Domain-Incremental Learning,DIL)旨在应对非平稳环境中的持续学习问题,要求模型能够适应不断变化的领域,同时保留已有的历史知识。在面对不平衡数据时,DIL 面临两个关键挑战:域内类别不平衡和跨域类别分布转移。这些挑战严重阻碍了模型性能的发挥:域内不平衡会导致少样本类别的欠拟合,而跨域分布转移则要求模型在保持多样本类别知识的基础上,提升旧领域中少样本类别的表现。 为解决上述问题,本文提出了双重平衡协同专家(Dual-Balance Collaborative Experts, DCE)框架。DCE 引入了一个频率感知的专家组,每个专家通过特定的损失函数进行引导,学习对应频率组的特征,从而有效应对域内类别不平衡问题。随后,DCE 通过对历史类别统计信息进行平衡高斯采样,合成伪特征,从而学习一个动态专家选择器。该机制在“保留旧领域中多样本类别知识”与“利用新数据提升旧任务中少样本类别性能”之间实现了有效权衡。 在四个基准数据集上的广泛实验结果表明,DCE 在不平衡领域增量学习任务中达到了当前最先进的性能水平。

成为VIP会员查看完整内容

相关内容

Arxiv

213+阅读 · 2023年4月7日