高效处理长上下文一直是自然语言处理领域的不懈追求。 随着长文档、对话及其他文本数据的日益增多,开发能够高效处理与分析长文本输入的**长上下文语言模型(LCLMs)**变得至关重要。本文全面综述了大语言模型在长上下文建模方面的最新进展,围绕三大核心问题展开:如何构建高效且有效的LCLMs——涵盖面向长上下文的数据策略、架构设计及工作流程;如何高效训练与部署LCLMs——深入分析训练与推理所需的基础设施;如何系统评估与分析LCLMs——包括长文本理解与生成的评测范式,以及模型行为分析与机制可解释性研究。此外,本文详细探讨了现有LCLMs的多样化应用场景,并展望了未来发展方向。本综述旨在为学界与工业界提供最新文献参考,相关论文与代码资源已整合于GitHub仓库:LCLM-Horizon。

1. 引言

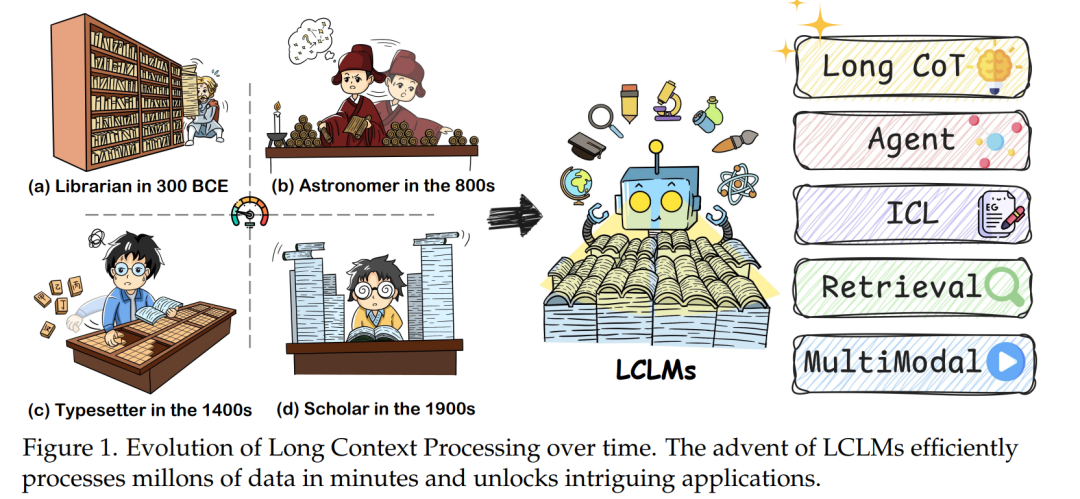

高效数据处理始终是人类孜孜以求的目标——受限于生物本能,人类只能进行局部、线性的阅读,手动处理长上下文数据效率极其低下。如图1所示,回溯历史长河:公元前300年,亚历山大图书馆的学者需手工抄写、校对手稿并编纂目录,以管理数十万卷古籍[553];公元8世纪,唐代司天监官员需人工处理海量天文观测数据以推算节气[554];15世纪,印刷工人必须手动排布数以万计的活字版才能印制报纸[552];直至20世纪,学者仍需逐篇查阅数十甚至数百份文献方能掌握某个领域的全貌。 语言模型的出现终于带来了革命性跃迁[42, 108, 197等],其能在数分钟内自动处理文本数据。这些模型通过固定上下文窗口对输入序列进行概率建模,实现下一词元预测。早期模型仅能处理数个至数十个词元[36, 61等];随着BERT[101]和GPT-3[37]分别将上下文长度扩展至数百和数千词元,段落、文档及多轮对话的自动处理首度成为可能。近年来,长上下文语言模型(LCLMs)更将上下文长度从4K呈指数级提升至128K[154]、1M[596]甚至10M[499]词元,可单次处理托尔斯泰级巨著(56万字),将人类60小时的阅读量压缩至分钟级计算。更重要的是,超长上下文为测试时扩展[164, 386]提供了空间——模型能在单次上下文中探索、反思、回溯与总结,从根本上改变了人类与生成式AI的交互模式,并解锁了一系列惊艳能力: * 类o1的长链推理[164, 373, 386] * 复杂智能体工作流[506] * 卓越的上下文学习[366, 499] * 高效信息检索与理解[262, 531] * 先进多模态智能[507, 550]

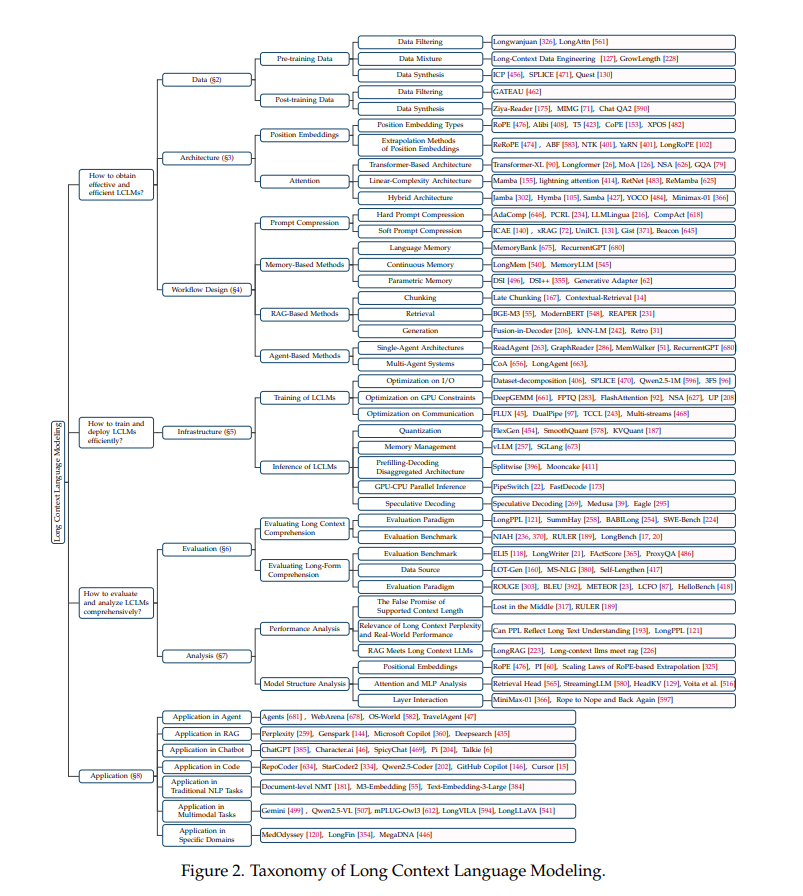

本文系统梳理了长上下文语言建模的研究进展。如图2所示,我们围绕三大核心维度展开: RQ1:如何获得高效能LCLMs? RQ2:如何高效训练与部署LCLMs? RQ3:如何全面评估与分析LCLMs? 除上述方向外,我们还深入探讨了LCLMs的多样化应用场景。 首先(对应RQ1),我们从数据策略(§2)、架构设计(§3)和工作流设计(§4)三方面展开: * 数据策略:详述预训练/微调阶段的数据工程方法,包括数据选择、过滤、合成与混合等 * 架构设计:系统分析三大类方案——基于Transformer的改进、线性复杂度架构、混合范式 * 工作流设计:涵盖提示压缩、基于记忆/检索增强生成(RAG)/智能体的扩展方案

其次(对应RQ2),我们总结AI基础设施优化策略(§5): * 训练基础设施:I/O优化、GPU内存访问优化、通信-计算重叠优化 * 推理基础设施:量化、内存管理、预填充-解码分离架构、GPU-CPU并行推理、推测解码

再次(对应RQ3),我们建立评估体系(§6)与分析框架(§7): * 评估:划分长上下文理解与长文本生成两类任务,梳理评测范式与基准数据集 * 分析:外部性能分析(有效上下文长度、PPL指标、中间信息丢失等)与内部结构分析(位置编码、注意力头、MLP层等)

最后,§8归纳LCLMs在智能体、RAG、编程、多模态等领域的应用;§9提出五大未来方向: 1. 长思维链推理 1. 有效的上下文扩展 1. 高效架构与基础设施 1. 鲁棒性评估 1. 机制可解释性

如表1所示,相较已有综述[106, 327, 397]聚焦特定主题,本文首次全面覆盖LCLMs技术图谱,通过跨领域整合解答上述核心问题。 我们期望本综述能为NLP领域的研究者、工程师及爱好者提供全景式参考,既呈现当前进展,亦指明现存挑战,助力这一激动人心的领域持续突破。