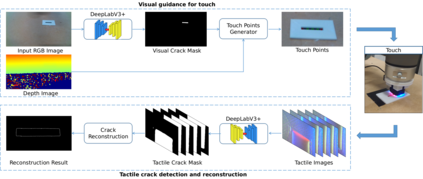

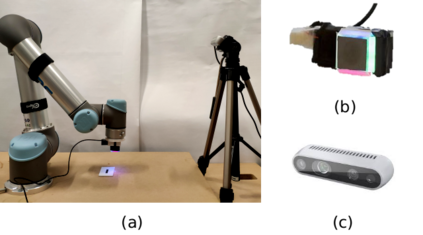

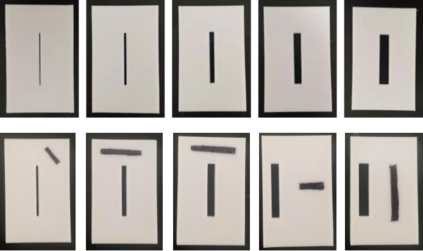

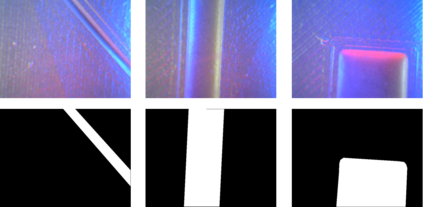

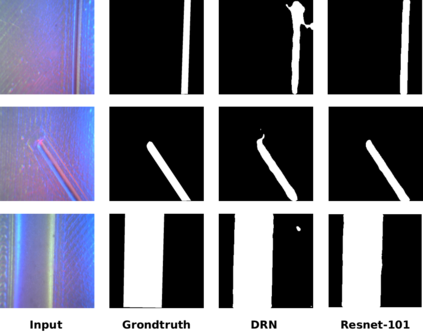

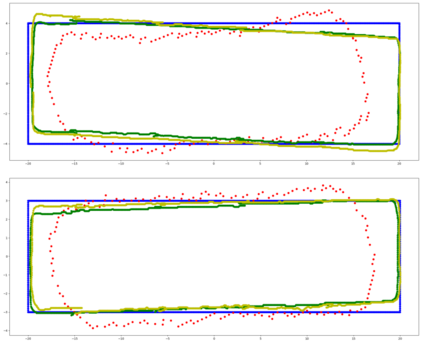

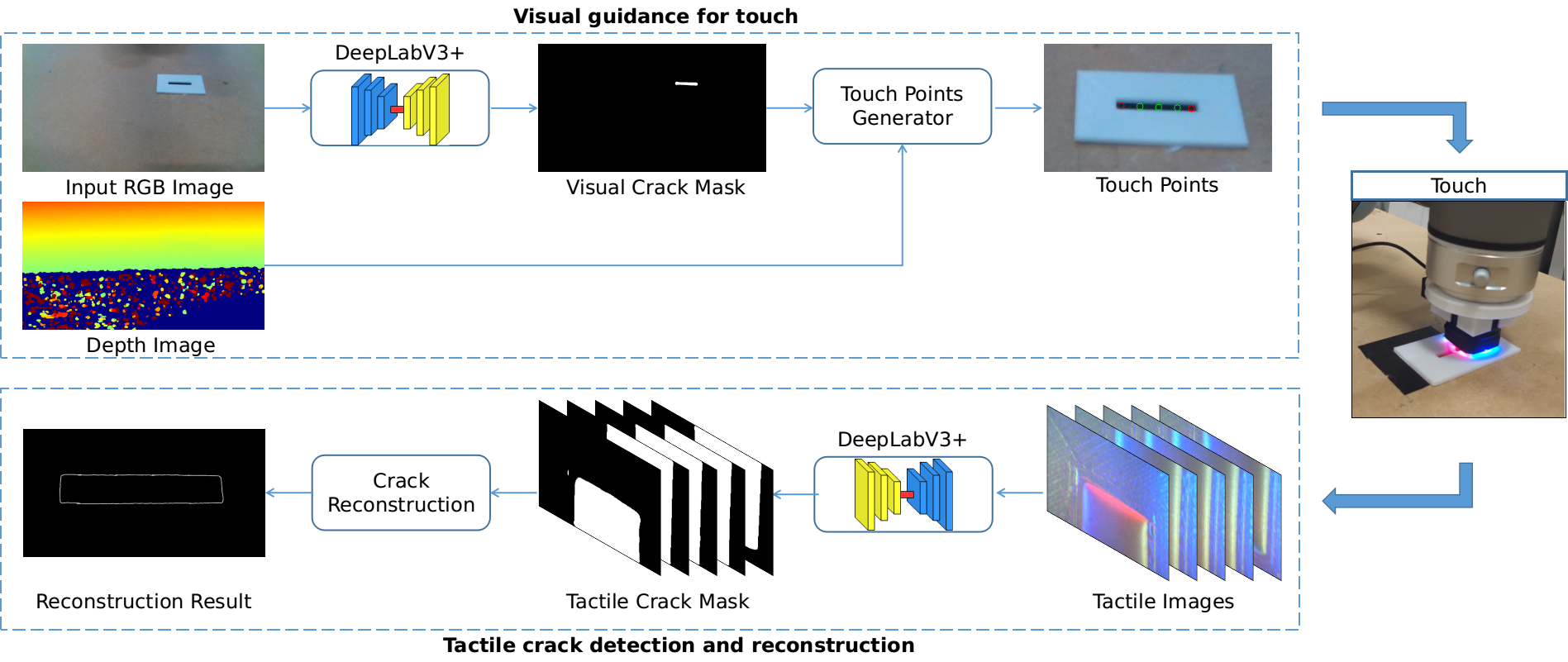

Crack detection is of great significance for monitoring the integrity and well-being of the infrastructure such as bridges and underground pipelines, which are harsh environments for people to access. In recent years, computer vision techniques have been applied in detecting cracks in concrete structures. However, they suffer from variances in light conditions and shadows, lacking robustness and resulting in many false positives. To address the uncertainty in vision, human inspectors actively touch the surface of the structures, guided by vision, which has not been explored in autonomous crack detection. In this paper, we propose a novel approach to detect and reconstruct cracks in concrete structures using vision-guided active tactile perception. Given an RGB-D image of a structure, the rough profile of the crack in the structure surface will first be segmented with a fine-tuned Deep Convolutional Neural Networks, and a set of contact points are generated to guide the collection of tactile images by a camera-based optical tactile sensor. When contacts are made, a pixel-wise mask of the crack can be obtained from the tactile images and therefore the profile of the crack can be refined by aligning the RGB-D image and the tactile images. Extensive experiment results have shown that the proposed method improves the effectiveness and robustness of crack detection and reconstruction significantly, compared to crack detection with vision only, and has the potential to enable robots to help humans with the inspection and repair of the concrete infrastructure.

翻译:裂缝探测对于监测桥梁和地下管道等基础设施的完整性和福祉非常重要,因为桥梁和地下管道是人们可以进入的恶劣环境。近年来,计算机视觉技术被用于探测混凝土结构的裂缝,但是,由于光线条件和阴影的差异,缺乏坚固性,并导致许多假阳性,这些技术因光线和阴影的差异而受到影响。为了解决视力的不确定性,检查员积极触摸结构表面,这种视觉没有在自主裂缝探测中探索过。在本文件中,我们提出一种新的方法,用视觉引导的积极触觉感知来探测和重建混凝土结构的裂缝。鉴于一个结构的 RGB-D 图像,结构表面裂缝的粗形图将首先与精心调整的深层进化神经网络进行分割,并产生一系列联络点,以指导通过光学感应感应传感器收集触动图像。在进行接触时,只能从触摸图中获取对裂裂的像的平流面面遮掩罩,因此,根据结构结构结构的图象图象将结构结构结构的粗糙图谱进行分解,通过快速的勘测来大大改进,并对比测结果。通过不断改进的研测结果,将研测结果与机勘测结果加以改进。