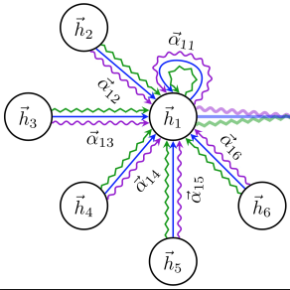

Traffic flow prediction as an essential part of the intelligent transportation system has received critical attention from researchers. However, the complex spatial and temporal dependencies between traffic roads make traffic flow prediction challenging. Existing methods are usually based on graph neural networks using predefined spatial adjacency graphs of traffic networks to model spatial dependencies, ignoring the dynamic correlation of relationships between road nodes. In addition, they usually use independent Spatio-temporal components to capture Spatio-temporal dependencies and do not effectively model global Spatio-temporal dependencies. This paper proposes a new Spatio-temporal Causal Graph Attention Network (STCGAT) for traffic prediction to address the above challenges. In STCGAT, we use a node embedding approach that can adaptively generate spatial adjacency subgraphs at each time step without a priori geographic knowledge and fine-grained modeling of the topology of dynamically generated graphs for different time steps. Meanwhile, we propose an efficient causal temporal correlation component that contains node adaptive learning, graph convolution, and local and global causal temporal convolution modules to learn local and global Spatio-temporal dependencies jointly. Extensive experiments on four real, large traffic datasets show that our model consistently outperforms all baseline models.

翻译:交通流量预测是智能交通系统的一个基本部分,但受到研究人员的高度重视。然而,交通道路之间复杂的空间和时间依赖性使得交通流量预测具有挑战性。现有方法通常以图形神经网络为基础,使用预先定义的空间相邻图显示交通网络,以模拟空间依赖性,忽视道路节点之间关系的动态关联性。此外,它们通常使用独立的空间时空构件捕捉时空依赖性,不有效地模拟全球时空依赖性。本文提议建立一个新的空间时空构造注意网络(STCGAT),用于交通预测,以应对上述挑战。在STCGAT中,我们使用节心嵌方法,可以适应性地生成每一步的空间相邻性亚谱,而没有事先的地理知识,也没有精确地模拟动态生成的图表的地形学,没有有效地模拟全球时空依赖性模型。同时,我们提出一个高效的因果相关时因相关部分,包含节调学习、图表同源、本地和全球时空连续的动态数据模型,显示我们所有全球时空连续的时空数据模型。