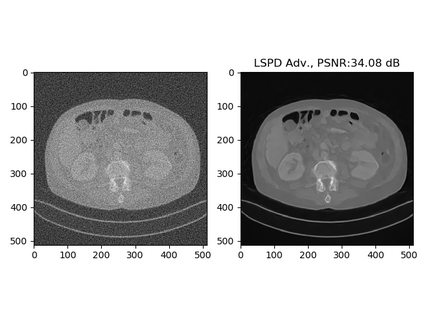

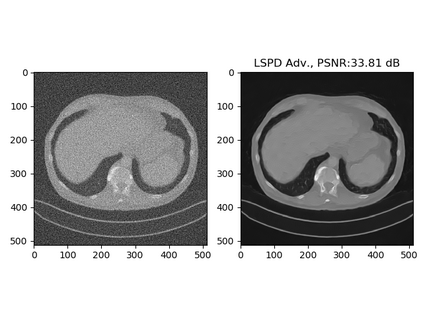

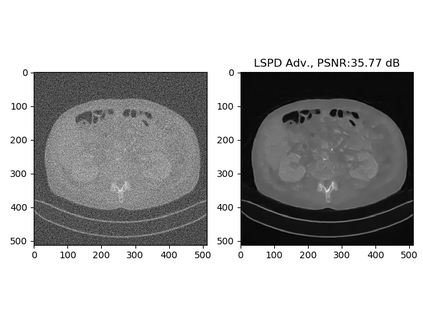

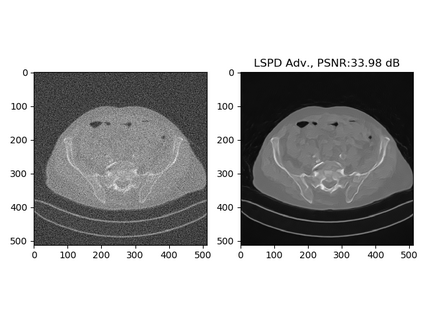

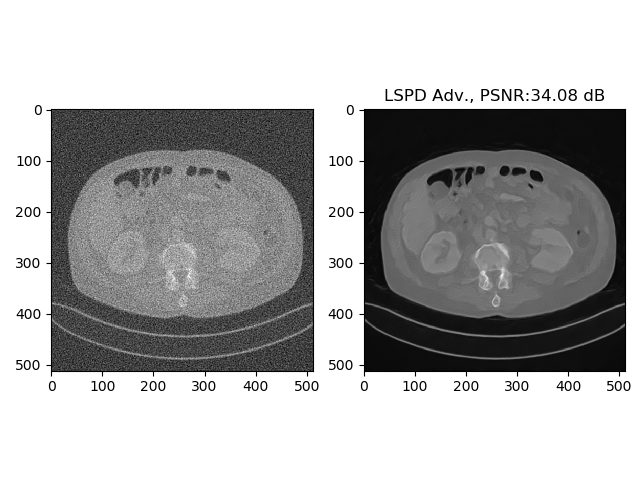

In this work we present a new type of efficient deep-unrolling networks for solving imaging inverse problems. Classical deep-unrolling methods require full forward operator and its adjoint across each layer, and hence can be computationally more expensive than other end-to-end methods such as FBP-ConvNet, especially in 3D image reconstruction tasks. We propose a stochastic (ordered-subsets) extension of the Learned Primal-Dual (LPD) which is the state-of-the-art unrolling network. In our unrolling network, we only use a subset of the forward and adjoint operator, to achieve computational efficiency. We consider 3 ways of training the proposed network to cope with different scenarios of the availability of the training data, including (1) supervised training on paired data, (2) unsupervised adversarial training which enable us to train the network without paired ground-truth data, (3) equivariant self-supervised training approach, which utilizes equivariant structure which is prevalent in many imaging applications, and only requires measurement data. Our numerical results demonstrate the effectiveness of our approach in X-ray CT imaging task, showing that our networks achieve similar reconstruction accuracies as the full-batch LPD, while require only a fraction of the computation.

翻译:在这项工作中,我们提出了一种新型高效的深层滚动网络,以解决成像反的问题。典型的深层滚动方法需要全前端操作员及其各层之间的连接,因此,可以比FBP-ConvNet等其他端到端方法,特别是3D图像重建任务,计算成本更高。我们建议采用一种随机(有序的子集)扩展(Primal-Dual)网络,这是最先进的解动网络。在我们的非滚动网络中,我们只使用前方和联合操作员的一组子集来实现计算效率。我们考虑用三种方法来培训拟议的网络,以应对培训数据提供的不同情景,例如FBPP-ConNet, 特别是在3D图像重建任务中:(1) 监督的配对数据培训,(2) 不受监督的对抗性培训,使我们能够在没有配对的地面图象数据的情况下对网络进行培训,(3) 等式自上自上超的训练方法,它利用许多成像应用中普遍存在的等变量结构,只需要测量数据。我们的数字结果显示我们的X光谱的重建方法,同时显示我们的X光谱的成像系统也需要完全的计算。