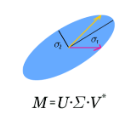

We develop singular value shrinkage priors for the mean matrix parameters in the matrix-variate normal model with known covariance matrices. Our priors are superharmonic and put more weight on matrices with smaller singular values. They are a natural generalization of the Stein prior. Bayes estimators and Bayesian predictive densities based on our priors are minimax and dominate those based on the uniform prior in finite samples. In particular, our priors work well when the true value of the parameter has low rank.

翻译:我们开发了具有已知共变矩阵的基质变异正常模型中平均矩阵参数的单值缩进前科。 我们的前科是超共和制, 并给具有较小单值的矩阵增加重量。 它们是Stein 之前的自然概括。 以我们前科为基础的贝亚斯测算器和贝叶斯预测密度是微型最大值, 并且以在有限样本中之前的一致值为主。 特别是, 当参数的真实值低时, 我们的前科效果很好 。

相关内容

专知会员服务

36+阅读 · 2019年10月17日

Arxiv

0+阅读 · 2021年5月28日