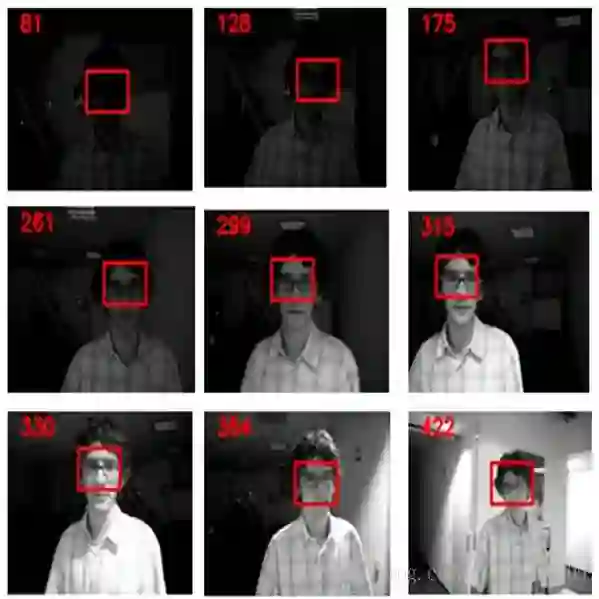

Object tracking is a key aspect in many applications such as augmented reality in medicine (e.g. tracking a surgical instrument) or robotics. Squared planar markers have become popular tools for tracking since their pose can be estimated from their four corners. While using a single marker and a single camera limits the working area considerably, using multiple markers attached to an object requires estimating their relative position, which is not trivial, for high accuracy tracking. Likewise, using multiple cameras requires estimating their extrinsic parameters, also a tedious process that must be repeated whenever a camera is moved. This work proposes a novel method to simultaneously solve the above-mentioned problems. From a video sequence showing a rigid set of planar markers recorded from multiple cameras, the proposed method is able to automatically obtain the three-dimensional configuration of the markers, the extrinsic parameters of the cameras, and the relative pose between the markers and the cameras at each frame. Our experiments show that our approach can obtain highly accurate results for estimating these parameters using low resolution cameras. Once the parameters are obtained, tracking of the object can be done in real time with a low computational cost. The proposed method is a step forward in the development of cost-effective solutions for object tracking.

翻译:物体跟踪是许多应用中的一个关键方面,例如医学(如跟踪手术仪器)或机器人等强化现实。平方平面标记已成为常用的跟踪工具,因为其形状可以从四角进行估计。在使用单一标记和单一摄像头大大限制工作区域的同时,使用与物体相连的多标记需要估计其相对位置(这不是微不足道的),以便进行高度精确的跟踪。同样,使用多摄像头需要估计其外表参数,这也是一个在移动相机时必须重复的繁琐过程。这项工作提出了同时解决上述问题的新方法。从显示从多摄像头记录的一系列僵硬的平面标记的视频序列中,拟议方法能够自动获得标记的三维配置、照相机的外部参数以及每个框架的摄像头之间的相对位置。我们的实验表明,我们的方法可以获得非常准确的结果,用低分辨率摄像头来估计这些参数。一旦获得参数,就可以实时地用低计算成本来跟踪物体。拟议的方法是前步式的成本解决方案。