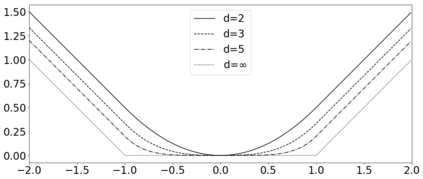

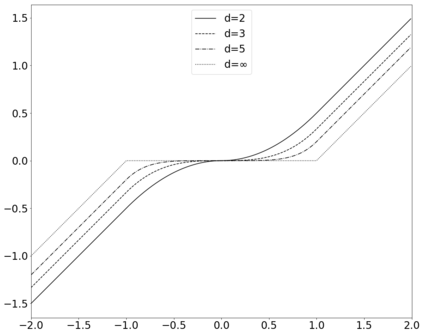

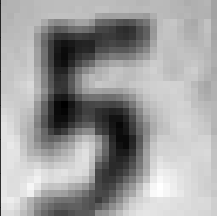

Convolutional neural networks (CNNs) have become the state-of-the-art tool for dealing with unsolved problems in computer vision and image processing. Since the convolution operator is a linear operator, several generalizations have been proposed to improve the performance of CNNs. One way to increase the capability of the convolution operator is by applying activation functions on the inner product operator. In this paper, we will introduce PowerLinear activation functions, which are based on the polynomial kernel generalization of the convolution operator. EvenPowLin functions are the main branch of the PowerLinear activation functions. This class of activation functions is saturated neither in the positive input region nor in the negative one. Also, the negative inputs are activated with the same magnitude as the positive inputs. These features made the EvenPowLin activation functions able to be utilized in the first layer of CNN architectures and learn complex features of input images. Additionally, EvenPowLin activation functions are used in CNN models to classify the inversion of grayscale images as accurately as the original grayscale images, which is significantly better than commonly used activation functions.

翻译:革命神经网络(CNNs)已成为处理计算机视觉和图像处理中未解决的问题的最先进工具。 由于革命操作员是一个线性操作员, 提议了几种一般化功能来改进CNN的性能。 提高革命操作员能力的方法之一是对内产品操作员应用激活功能。 在本文中, 我们将引入基于聚合操作员多圆内圈的PowLear激活功能。 EvenPowLin功能是PowLin激活功能的主要分支。 这种类型的激活功能既不在正输入区,也不在负输入区。 另外, 负输入与正输入的强度相同。 这些功能使得EvenPowLin激活功能能够用于CNN结构的第一层, 并学习输入图像的复杂特征。 此外, EvenPowLin激活功能在CNN 模型中被用来将灰度图像的转换与原始灰度图像精确分类, 原始灰度图像比通常使用的激活功能要好得多 。