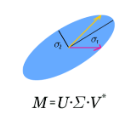

A common sparse linear regression formulation is the l1 regularized least squares, which is also known as least absolute shrinkage and selection operator (LASSO). Approximate message passing (AMP) has been proved to asymptotically achieve the LASSO solution when the regression matrix has independent and identically distributed (i.i.d.) Gaussian entries in the sense that the averaged per-coordinate l2 distance between the AMP iterates and the LASSO solution vanishes as the signal dimension goes to infinity before the iteration number. However, in finite dimensional settings, characterization of AMP iterates in the limit of large iteration number has not been established. In this work, we propose an AMP variant by including a parameter that depends on the largest singular value of the regression matrix. The proposed algorithm can also be considered as a primal dual hybrid gradient algorithm with adaptive stepsizes. We show that whenever the AMP variant converges, it converges to the LASSO solution for arbitrary finite dimensional regression matrices. Moreover, we show that the AMP variant is locally stable around the LASSO solution under the condition that the LASSO solution is unique and that the regression matrix is drawn from a continuous distribution. Our local stability result implies that in the special case where the regression matrix is large and has i.i.d. random entries, the original AMP, which is a special case of the proposed AMP variant, is locally stable around the LASSO solution.

翻译:常见的稀疏线性回归式配方为I1固定最小方形,也称为最小绝对缩缩和选择操作员(LASSO)。当回归矩阵是独立和相同分布的(i.d.) Gaussian 条目时,近似电文流传递(AMP)的特征被证明无一实现LASSO解决方案,因为回归矩阵是独立和相同分布的(i.d.) Gaussian 条目,其含义是:AMP 服务器和 LASSO 解决方案之间的平均每升坐标I2距离随着信号尺寸在迭代数之前的不精确度而消失。然而,在有限的维度设置中,AMP 电文流流流的特征尚未确定。在这项工作中,我们建议AMP 参数变异异变量包含一个取决于回归矩阵的最大单值的参数。 拟议的算法也可以被视为一个带有适应性级的原始双曲线梯度梯度运算法。当AMP变量与LASSO 任意定度回归矩阵的LASO 的原始路径图解算是一个特殊的本地公式。在LASO 上,一个稳定的本地的缩缩缩缩缩缩矩阵是我们LASO 的原模型的原的路径。