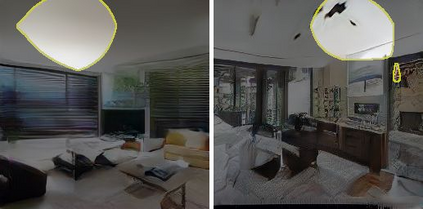

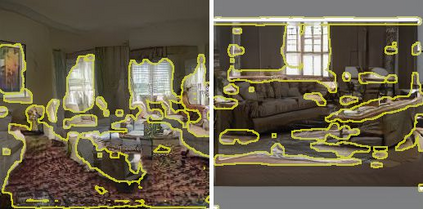

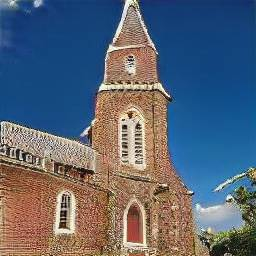

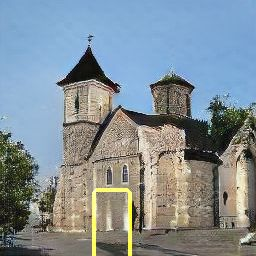

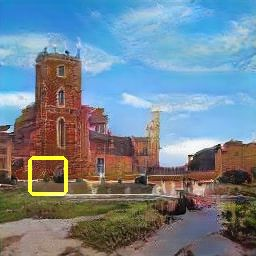

Generative Adversarial Networks (GANs) have achieved impressive results for many real-world applications. As an active research topic, many GAN variants have emerged with improvements in sample quality and training stability. However, visualization and understanding of GANs is largely missing. How does a GAN represent our visual world internally? What causes the artifacts in GAN results? How do architectural choices affect GAN learning? Answering such questions could enable us to develop new insights and better models. In this work, we present an analytic framework to visualize and understand GANs at the unit-, object-, and scene-level. We first identify a group of interpretable units that are closely related to concepts with a segmentation-based network dissection method. We quantify the causal effect of interpretable units by measuring the ability of interventions to control objects in the output. Finally, we examine the contextual relationship between these units and their surrounding by inserting the discovered concepts into new images. We show several practical applications enabled by our framework, from comparing internal representations across different layers, models, and datasets, to improving GANs by locating and removing artifact-causing units, to interactively manipulating objects in the scene. We will open source our interactive tools to help researchers and practitioners better understand their models.

翻译:生成的Adversarial 网络(GANs)在许多现实世界应用中取得了令人印象深刻的成果。作为一个积极的研究课题,许多GAN变量随着样本质量和培训稳定性的改善而出现。然而,GAN的可视化和理解基本上缺乏。GAN如何在内部代表我们的视觉世界?GAN的结果是什么原因?建筑选择如何影响GAN的学习? 回答这些问题可以使我们开发新的洞察力和更好的模型。在这项工作中,我们提出了一个分析框架,以在单位、对象和场景一级可视化和理解GAN。我们首先确定一组可解释的单位,这些单位与以分解为基础的网络分解方法的概念密切相关。我们量化可解释单位的因果关系,通过测量用于控制输出对象的物体的干预能力;最后,我们审视这些单位及其周围的背景关系,将发现的概念插入新的图像。我们展示了我们框架所促成的一些实际应用,从比较不同层次、模型和数据集的内部表现,到改进GANs的可解释性单位,我们通过定位和删除互动工具来理解其互动的模型,从而更好地理解其互动工具来源。