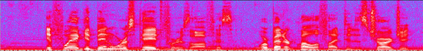

A deep neural network (DNN)-based speech enhancement (SE) aiming to maximize the performance of an automatic speech recognition (ASR) system is proposed in this paper. In order to optimize the DNN-based SE model in terms of the character error rate (CER), which is one of the metric to evaluate the ASR system and generally non-differentiable, our method uses two DNNs: one for speech processing and one for mimicking the output CERs derived through an acoustic model (AM). Then both of DNNs are alternately optimized in the training phase. Even if the AM is a black-box, e.g., like one provided by a third-party, the proposed method enables the DNN-based SE model to be optimized in terms of the CER since the DNN mimicking the AM is differentiable. Consequently, it becomes feasible to build CER-centric SE model that has no negative effect, e.g., additional calculation cost and changing network architecture, on the inference phase since our method is merely a training scheme for the existing DNN-based methods. Experimental results show that our method improved CER by 7.3% relative derived through a black-box AM although certain noise levels are kept.

翻译:本文建议建立深心神经网络(DNN),目的是最大限度地提高自动语音识别系统(ASR)的性能。为了在字符误差率(CER)方面优化基于DNN的SE模型,这是评价ASR系统的一种衡量标准之一,而且一般来说是无差别的,我们的方法使用两个DNN:一个用于语音处理,一个用于模拟通过音响模型(AM)获得的CER产出。然后,两个DNN在培训阶段进行交替优化。即使AM是一个黑箱,例如第三方提供的黑箱,拟议的方法使基于DNNNS的SE模型在字符误差率(CER)方面得到优化,因为DNNM模拟AM是不同的。因此,在判断阶段建立无负面影响的以CER为中心的SE模型是可行的,例如额外的计算成本和不断变化的网络结构,因为我们的方法仅仅是对基于DNNNE的方法的培训计划,例如第三方提供的一个黑箱。实验结果显示,虽然我们的方法通过黑箱得到一定的噪音水平,但我们的MMER是某种改进的方法。