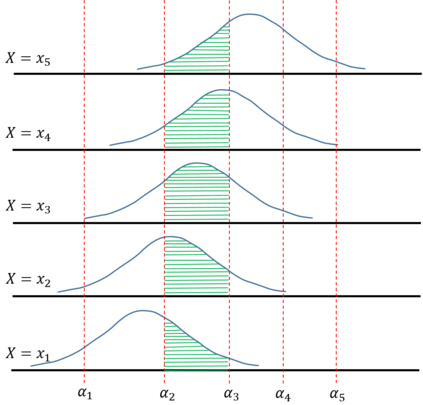

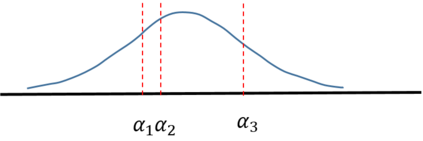

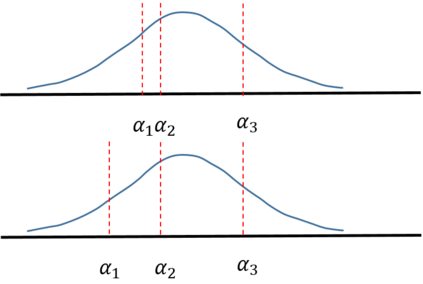

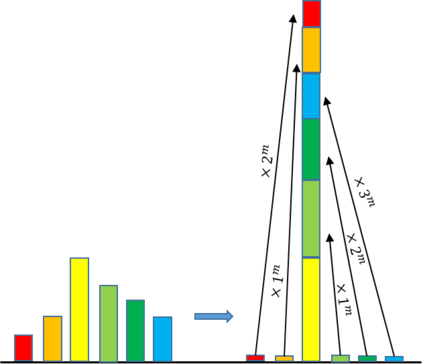

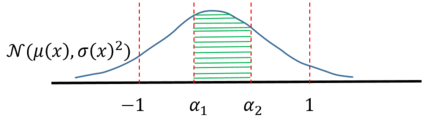

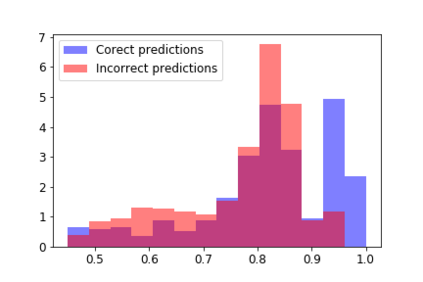

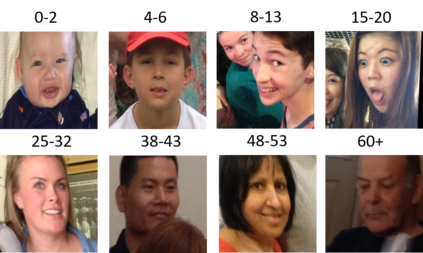

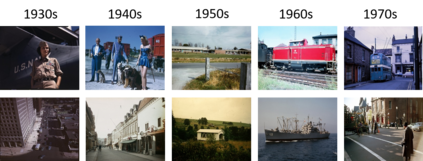

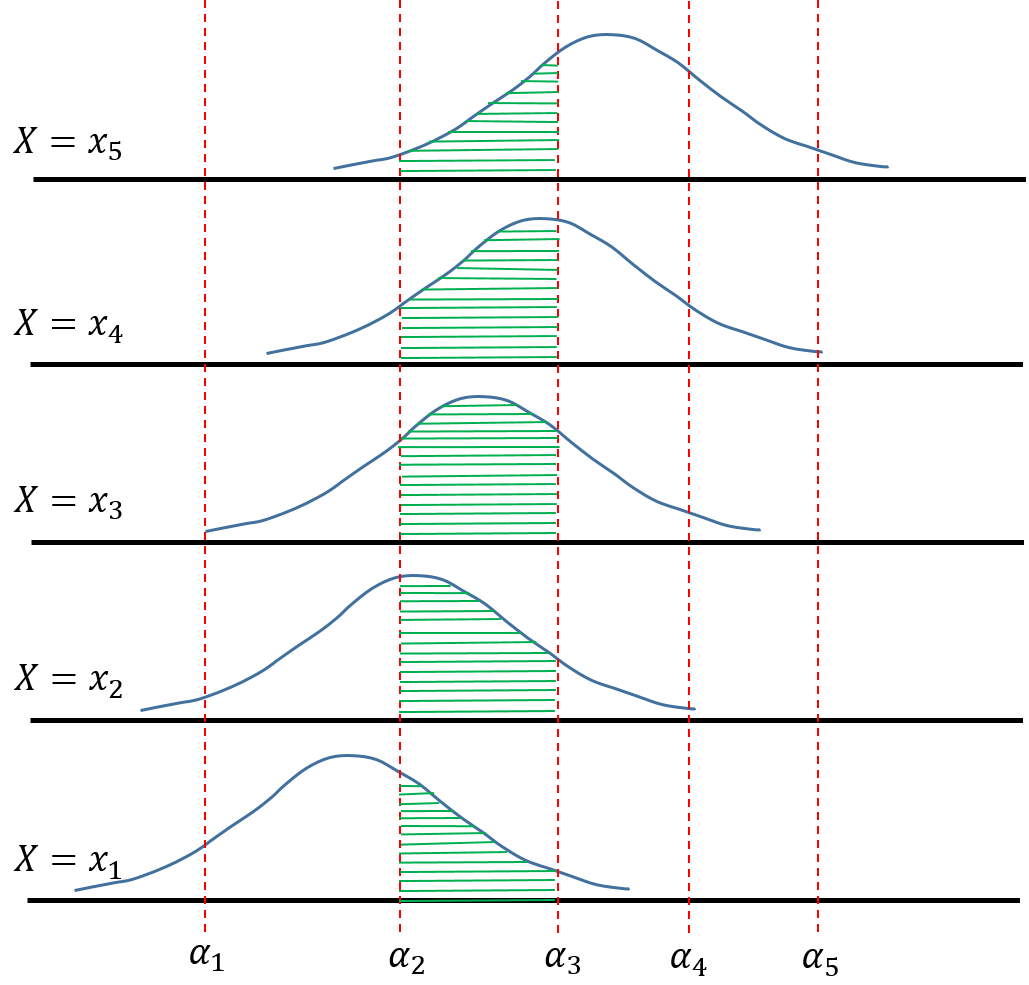

It is often desired that ordinal regression models yield unimodal predictions. However, in many recent works this characteristic is either absent, or implemented using soft targets, which do not guarantee unimodal outputs at inference. In addition, we argue that the standard maximum likelihood objective is not suitable for ordinal regression problems, and that optimal transport is better suited for this task, as it naturally captures the order of the classes. In this work, we propose a framework for deep ordinal regression, based on unimodal output distribution and optimal transport loss. Inspired by the well-known Proportional Odds model, we propose to modify its design by using an architectural mechanism which guarantees that the model output distribution will be unimodal. We empirically analyze the different components of our proposed approach and demonstrate their contribution to the performance of the model. Experimental results on eight real-world datasets demonstrate that our proposed approach consistently performs on par with and often better than several recently proposed deep learning approaches for deep ordinal regression with unimodal output probabilities, while having guarantee on the output unimodality. In addition, we demonstrate that proposed approach is less overconfident than current baselines.

翻译:然而,在许多最近的工程中,这一特征要么不存在,要么是使用软目标加以执行,这并不能保证在推论时的单式产出。此外,我们争辩说,标准最大可能性目标并不适合于异常回归问题,最佳运输更适合这项任务,因为它自然地捕捉了等级的顺序。在这项工作中,我们提出了一个基于单式产出分布和最佳运输损失的深式回归框架。在众所周知的正式产出模型的启发下,我们提议修改其设计,采用一个建筑机制,保证模型产出分布将是单式的。我们从经验上分析我们拟议方法的不同组成部分,并展示它们对模型性能的贡献。八个真实世界数据集的实验结果表明,我们拟议的方法与最近提出的以单式产出概率和最佳运输损失进行深度或低度回归的深层次学习方法一样,而且往往比最近提出的若干项关于以单式产出概率进行深度回归的深层次学习方法要好。我们提议的方法在保证产出的不具有单一性的同时,我们建议修改其设计,方法是使用一种建筑机制,保证模型的分布将是单一式的。我们从实验角度分析了我们提出的方法比目前的基线要低于过分。