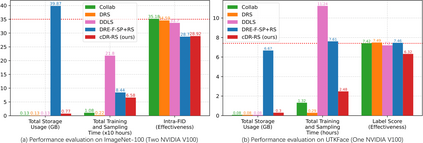

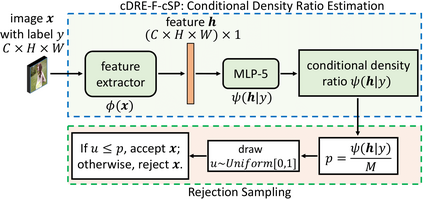

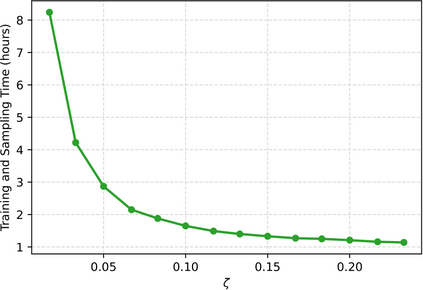

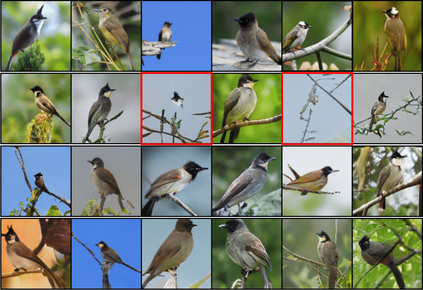

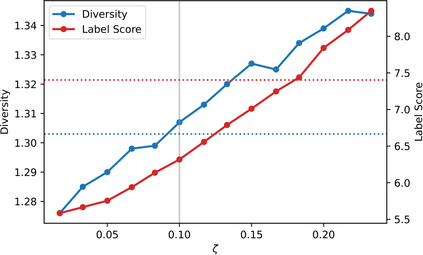

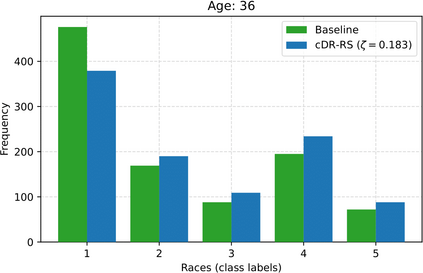

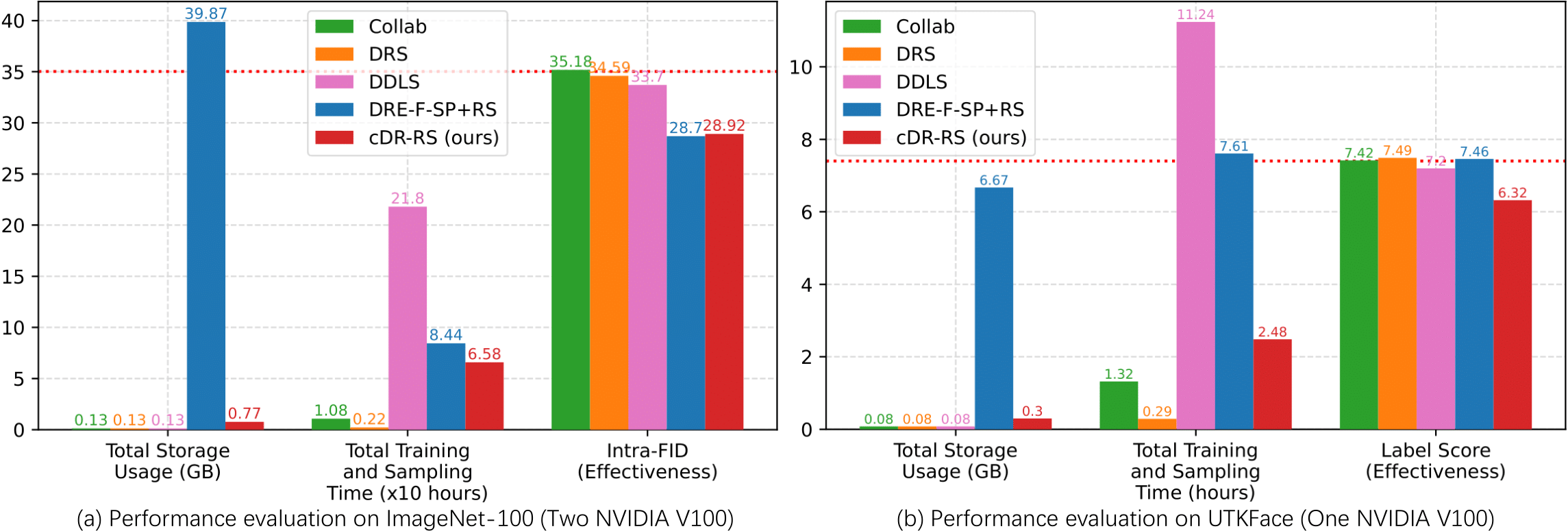

Recently, subsampling or refining images generated from unconditional GANs has been actively studied to improve the overall image quality. Unfortunately, these methods are often observed less effective or inefficient in handling conditional GANs (cGANs) -- conditioning on a class (aka class-conditional GANs) or a continuous variable (aka continuous cGANs or CcGANs). In this work, we introduce an effective and efficient subsampling scheme, named conditional density ratio-guided rejection sampling (cDR-RS), to sample high-quality images from cGANs. Specifically, we first develop a novel conditional density ratio estimation method, termed cDRE-F-cSP, by proposing the conditional Softplus (cSP) loss and an improved feature extraction mechanism. We then derive the error bound of a density ratio model trained with the cSP loss. Finally, we accept or reject a fake image in terms of its estimated conditional density ratio. A filtering scheme is also developed to increase fake images' label consistency without losing diversity when sampling from CcGANs. We extensively test the effectiveness and efficiency of cDR-RS in sampling from both class-conditional GANs and CcGANs on five benchmark datasets. When sampling from class-conditional GANs, cDR-RS outperforms modern state-of-the-art methods by a large margin (except DRE-F-SP+RS) in terms of effectiveness. Although the effectiveness of cDR-RS is often comparable to that of DRE-F-SP+RS, cDR-RS is substantially more efficient. When sampling from CcGANs, the superiority of cDR-RS is even more noticeable in terms of both effectiveness and efficiency. Notably, with the consumption of reasonable computational resources, cDR-RS can substantially reduce Label Score without decreasing the diversity of CcGAN-generated images, while other methods often need to trade much diversity for slightly improved Label Score.

翻译:最近,对无条件GANs生成的图像进行了小规模取样或精炼,以提高总体图像质量。不幸的是,在处理有条件GANs(cGANs)时,这些方法往往不太有效或效率低下,这些方法的处理方式是有条件的GANs(aka类有条件GANs)或连续的变量(aka 连续的cGANs或CcGANs)。在这项工作中,我们引入了一种有效力和效率的子取样办法,名为有条件的密度比率指导拒绝抽样(cDR-RS),以及来自cGANs的高质量图像。 具体地说,我们首先开发了一种全新的有条件的CRSS-FS(CDRE-S)比率估算方法,通常称为CDRE-FS(cRS-F) 标准(cRS-C-S-RS) 标准(cRS-ral-Seral-ral-ral-ral-ral-ral-ral-ral-rest-rests), 而GRC-C-ral-ral-ral-ral-rest-rest-rest-ral-rest-ral-rest-rest-ral-de-de-ral-ral-l-de-de-de-de-de-s) 资源,我们接受或G-l-de-de-de-de-l-de-de-de-de-de-de-de-de-de-de-de-de-deg-de-de-lent-lent-de-l-de-de-de-de-de-de-l-de-de-de-de-de-de-de-de-de-de-de-de-de-de-de-de-de-de-de-de-de-de-de-l-de-de-de-de-de-de-de-de-de-de-deal-de-de-de-de-de-l-l-de-l-de-de-de-de-de-de-de-de-de-l-de-de-de-de-de-de-de-de-de-de-de-de-