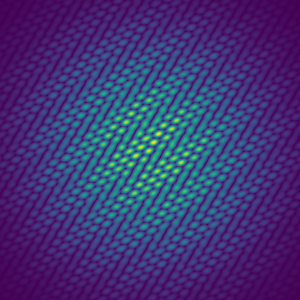

Phase retrieval consists in the recovery of an unknown signal from phaseless measurements of its usually complex-valued Fourier transform. Without further assumptions, this problem is notorious to be severe ill posed such that the recovery of the true signal is nearly impossible. In certain applications like crystallography, speckle imaging in astronomy, or blind channel estimation in communications, the unknown signal has a specific, sparse structure. In this paper, we exploit these sparse structure to recover the unknown signal uniquely up to inevitable ambiguities as global phase shifts, transitions, and conjugated reflections. Although using a constructive proof essentially based on Prony's method, our focus lies on the derivation of a recovery guarantee for multivariate signals using an adaptive sampling scheme. Instead of sampling the entire multivariate Fourier intensity, we only employ Fourier samples along certain adaptively chosen lines. For bivariate signals, an analogous result can be established for samples in generic directions. The number of samples here scales quadratically to the sparsity level of the unknown signal.

翻译:阶段检索包括从对其通常的复杂价值的Fourier变异进行无阶段性测量中恢复一个未知信号。 没有进一步的假设, 这个问题就臭名昭著地严重, 造成真实信号的恢复几乎不可能。 在某些应用中, 如晶体学、 天文学中的分光成像或通信中的盲道估计, 未知信号有一个具体、 稀疏的结构。 在本文中, 我们利用这些稀疏的结构来恢复未知信号, 其独特性到不可避免的模糊性, 正如全球阶段转移、 过渡和混凝土反射一样。 尽管我们使用基本上基于Prony方法的建设性证据, 我们的重点是利用适应性取样方法为多变量信号提供恢复保证。 我们没有对整个多变量 Fourier 强度取样, 而是按照某些适应性选择的路线使用 Fourier 样本 。 对于双变量信号, 可以为通用方向的样本确定一个类似的结果。 这里的样本数量与未知信号的孔径水平是四倍的。