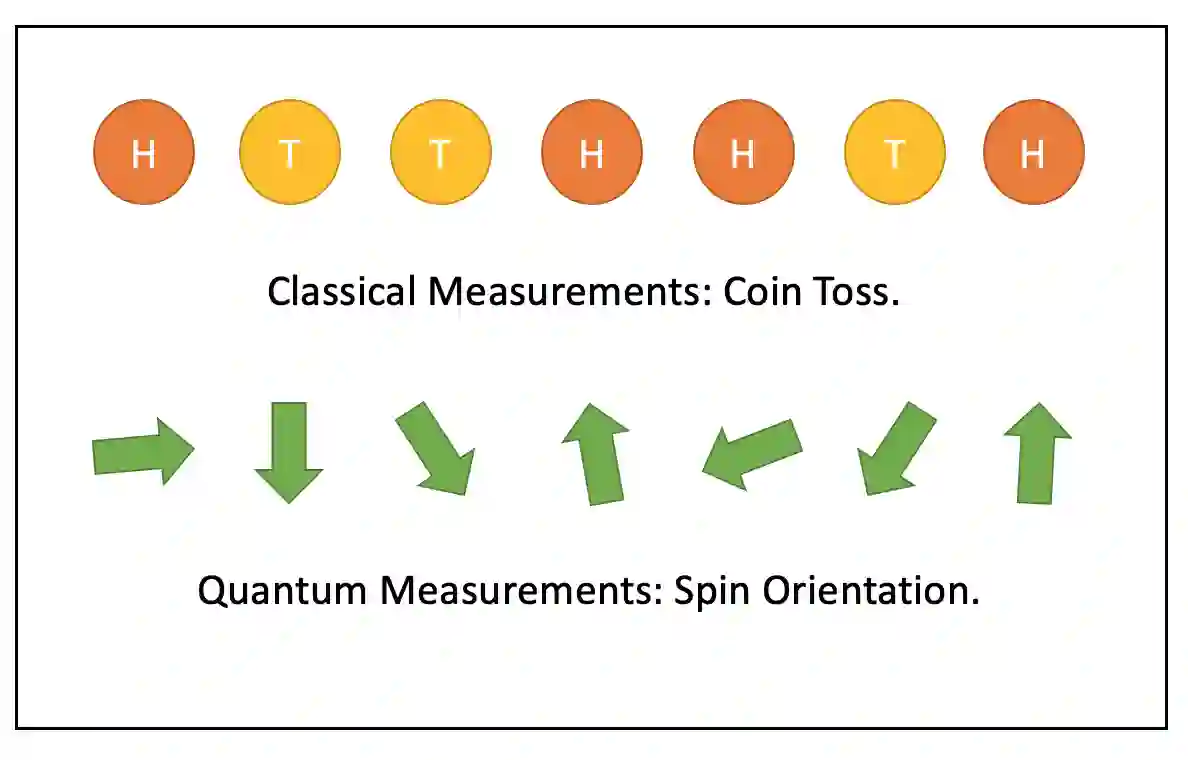

Quantum machine learning is an emerging field at the intersection of machine learning and quantum computing. Classical cross entropy plays a central role in machine learning. We define its quantum generalization, the quantum cross entropy, prove its lower bounds, and investigate its relation to quantum fidelity. In the classical case, minimizing cross entropy is equivalent to maximizing likelihood. In the quantum case, when the quantum cross entropy is constructed from quantum data undisturbed by quantum measurements, this relation holds. Classical cross entropy is equal to negative log-likelihood. When we obtain quantum cross entropy through empirical density matrix based on measurement outcomes, the quantum cross entropy is lower-bounded by negative log-likelihood. These two different scenarios illustrate the information loss when making quantum measurements. We conclude that to achieve the goal of full quantum machine learning, it is crucial to utilize the deferred measurement principle.

翻译:量子机器的学习是机器学习和量子计算交汇处的一个新兴领域。 经典的跨子昆虫在机器学习中发挥着核心作用。 我们定义了它的量子概括性, 量子交叉昆虫, 证明了它的下界, 并调查它与量子忠实性的关系。 在古典案例中, 将量子交叉昆虫的最小化相当于可能性最大化。 在量子案例中, 当量子交叉性从量子测量未受量子测量干扰的量子数据中构建时, 这种关系就保持了下去。 典型的跨子昆虫与负日志相似性相等。 当我们通过测量结果的实验密度矩阵获得量子交叉酶时, 量子交叉昆虫被负日志相似性缩小了。 这两个不同的假设在进行量子测量时说明了信息损失。 我们的结论是,为了实现量子机器全面学习的目标, 利用推迟的测量原则至关重要。