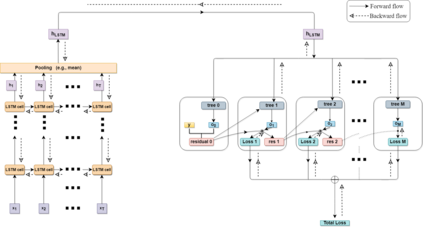

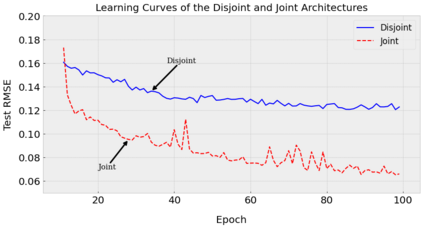

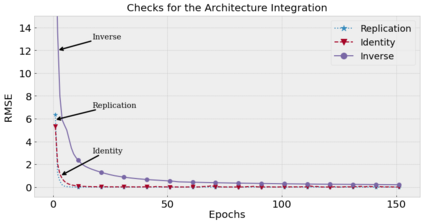

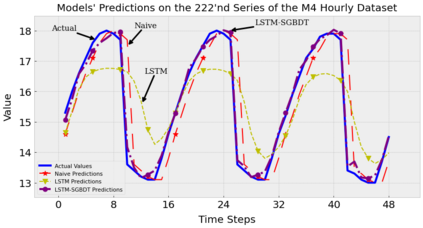

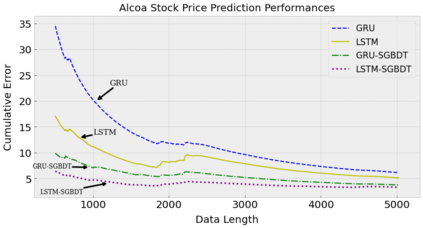

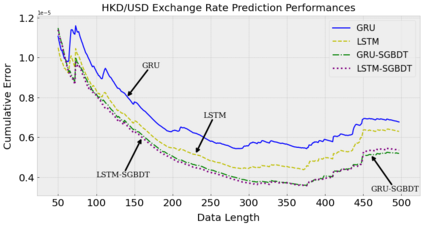

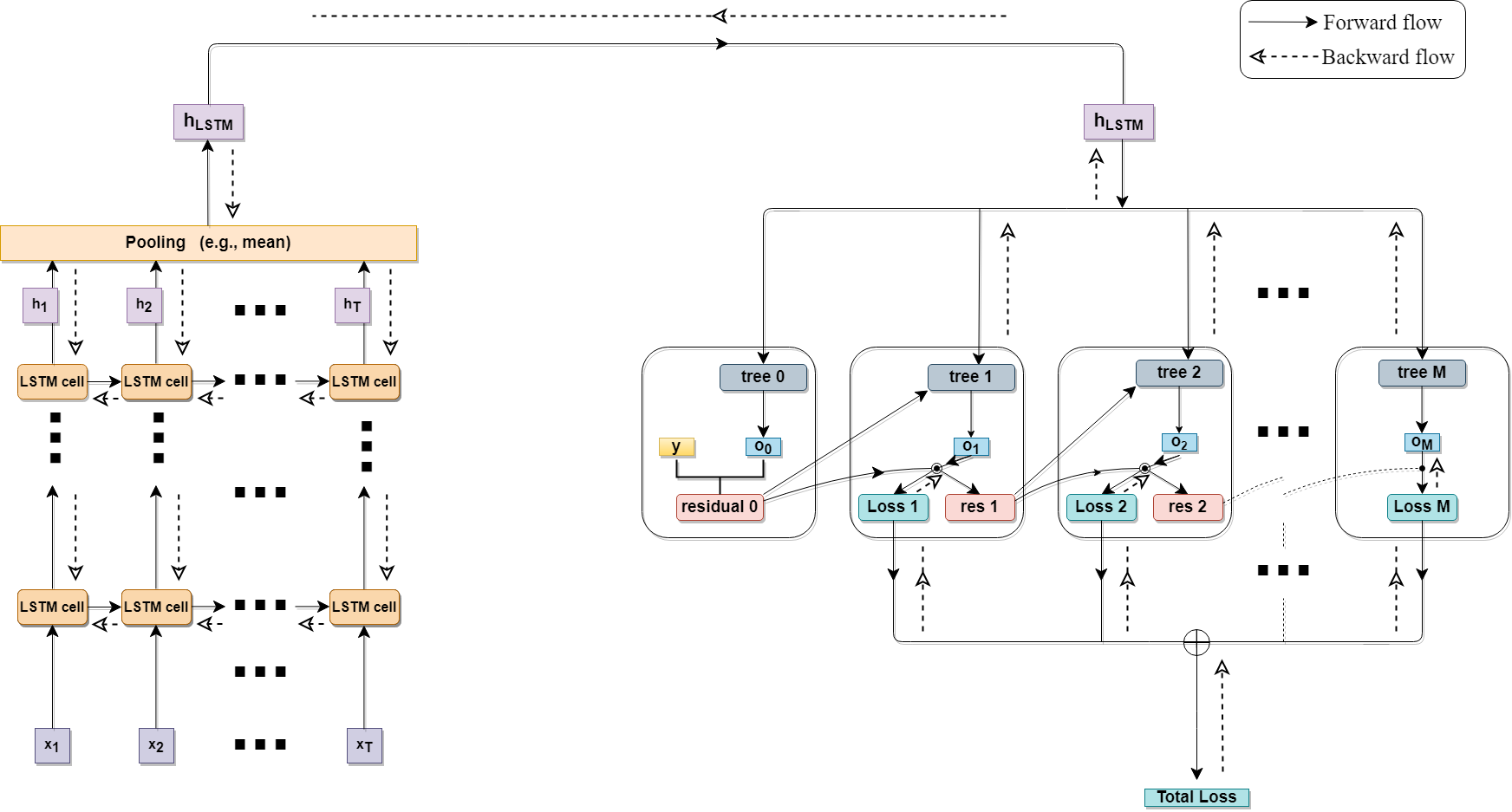

We investigate nonlinear prediction in an online setting and introduce a hybrid model that effectively mitigates, via an end-to-end architecture, the need for hand-designed features and manual model selection issues of conventional nonlinear prediction/regression methods. In particular, we use recursive structures to extract features from sequential signals, while preserving the state information, i.e., the history, and boosted decision trees to produce the final output. The connection is in an end-to-end fashion and we jointly optimize the whole architecture using stochastic gradient descent, for which we also provide the backward pass update equations. In particular, we employ a recurrent neural network (LSTM) for adaptive feature extraction from sequential data and a gradient boosting machinery (soft GBDT) for effective supervised regression. Our framework is generic so that one can use other deep learning architectures for feature extraction (such as RNNs and GRUs) and machine learning algorithms for decision making as long as they are differentiable. We demonstrate the learning behavior of our algorithm on synthetic data and the significant performance improvements over the conventional methods over various real life datasets. Furthermore, we openly share the source code of the proposed method to facilitate further research.

翻译:我们调查在线环境中的非线性预测,并引入一种混合模型,通过端到端结构,有效减轻对传统非线性预测/回归方法手工设计特点和人工模型选择问题的需要,特别是,我们使用循环结构从顺序信号中提取特征,同时保存国家信息,即历史,并提升决策树以产生最终产出。连接是端到端的方式,我们利用随机梯度下降,共同优化整个结构,为此,我们还提供后向传输更新方程式。特别是,我们使用一个经常性神经网络(LSTM),从连续数据中提取适应性特征,并使用一个梯度增强机械(软GBDT),以进行有效监管的回归。我们的框架是通用的,这样可以使用其他深层学习结构进行特征提取(如RNNS和GRUs)和机器学习算法,只要这些算法是不同的,就可以做出决策。我们展示了我们的合成数据算法的学习行为以及各种实际生命数据研究常规方法的显著性改进。此外,我们公开分享了拟议的源代码,以便进一步研究。