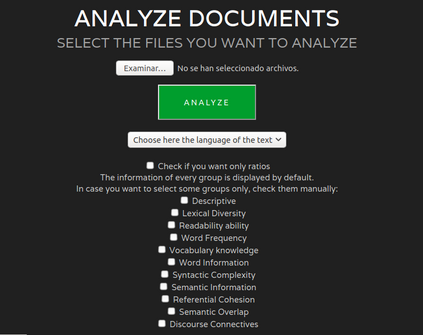

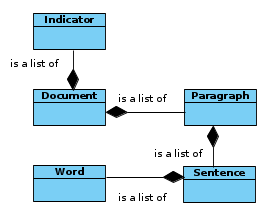

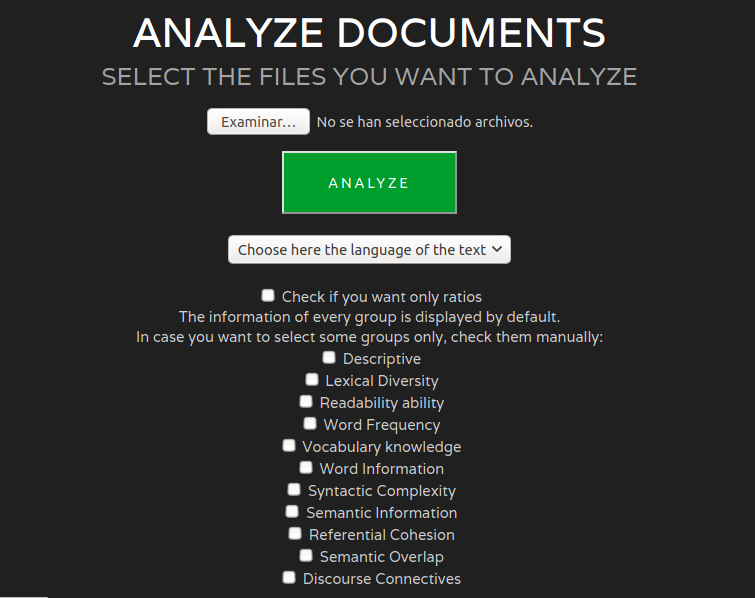

Readability assessment is the task of determining how difficult or easy a text is or which level/grade it has. Traditionally, language dependent readability formula have been used, but these formulae take few text characteristics into account. However, Natural Language Processing (NLP) tools that assess the complexity of texts are able to measure more different features and can be adapted to different languages. In this paper, we present the MultiAzterTest tool: (i) an open source NLP tool which analyzes texts on over 125 measures of cohesion,language, and readability for English, Spanish and Basque, but whose architecture is designed to easily adapt other languages; (ii) readability assessment classifiers that improve the performance of Coh-Metrix in English, Coh-Metrix-Esp in Spanish and ErreXail in Basque; iii) a web tool. MultiAzterTest obtains 90.09 % in accuracy when classifying into three reading levels (elementary, intermediate, and advanced) in English and 95.50 % in Basque and 90 % in Spanish when classifying into two reading levels (simple and complex) using a SMO classifier. Using cross-lingual features, MultiAzterTest also obtains competitive results above all in a complex vs simple distinction.

翻译:可读性评估是确定文本的难度或易易程度或程度/等级的任务。传统上,使用了依赖语言的可读性公式,但这些公式很少考虑文字特性。然而,评估文本复杂性的自然语言处理工具能够衡量不同特点,并且可以适应不同语言。在本文件中,我们提供了多亚兹特测试工具:(一) 开放源代码NLP工具,用于分析英语、西班牙语和巴斯克语125种以上凝聚力、语言和可读性衡量度、语言和可读性等的文本,但其结构设计便于调整其他语言;(二) 可读性评估分类,用于改进英文科美特克语、西班牙文科赫-梅特里斯-ESp语和巴斯克语ErreXail语的性能;(三) 网络工具。多亚兹特测试在将英语和巴斯克语三种阅读水平(基本、中间和高级)分类时,获得了90.09 %的准确度,在将巴斯克语种和西班牙语结构设计结构设计成便于调整的其他语言结构;(二分级(简单和复杂),还使用SMO的竞争性分级,获得所有分级。