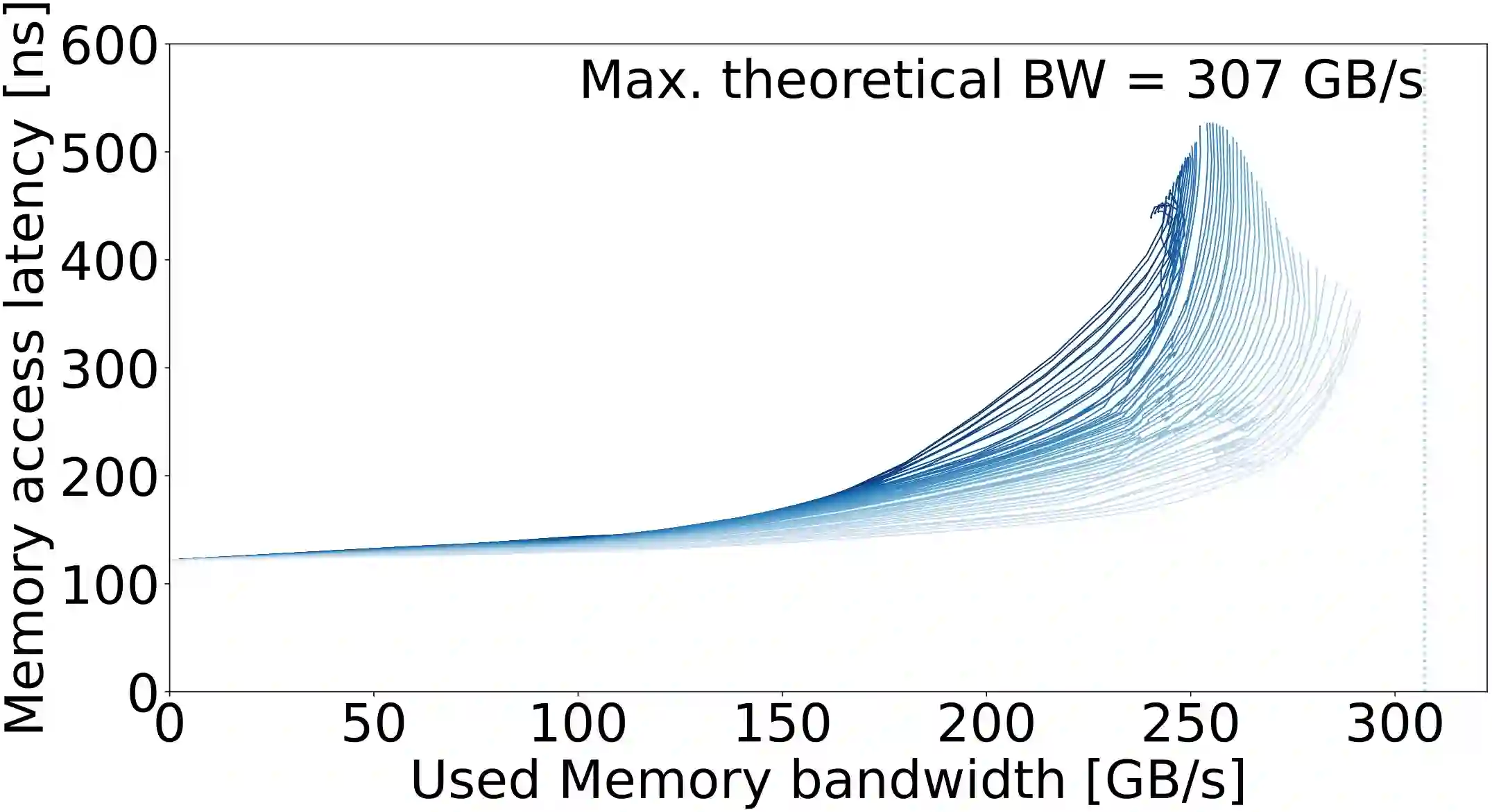

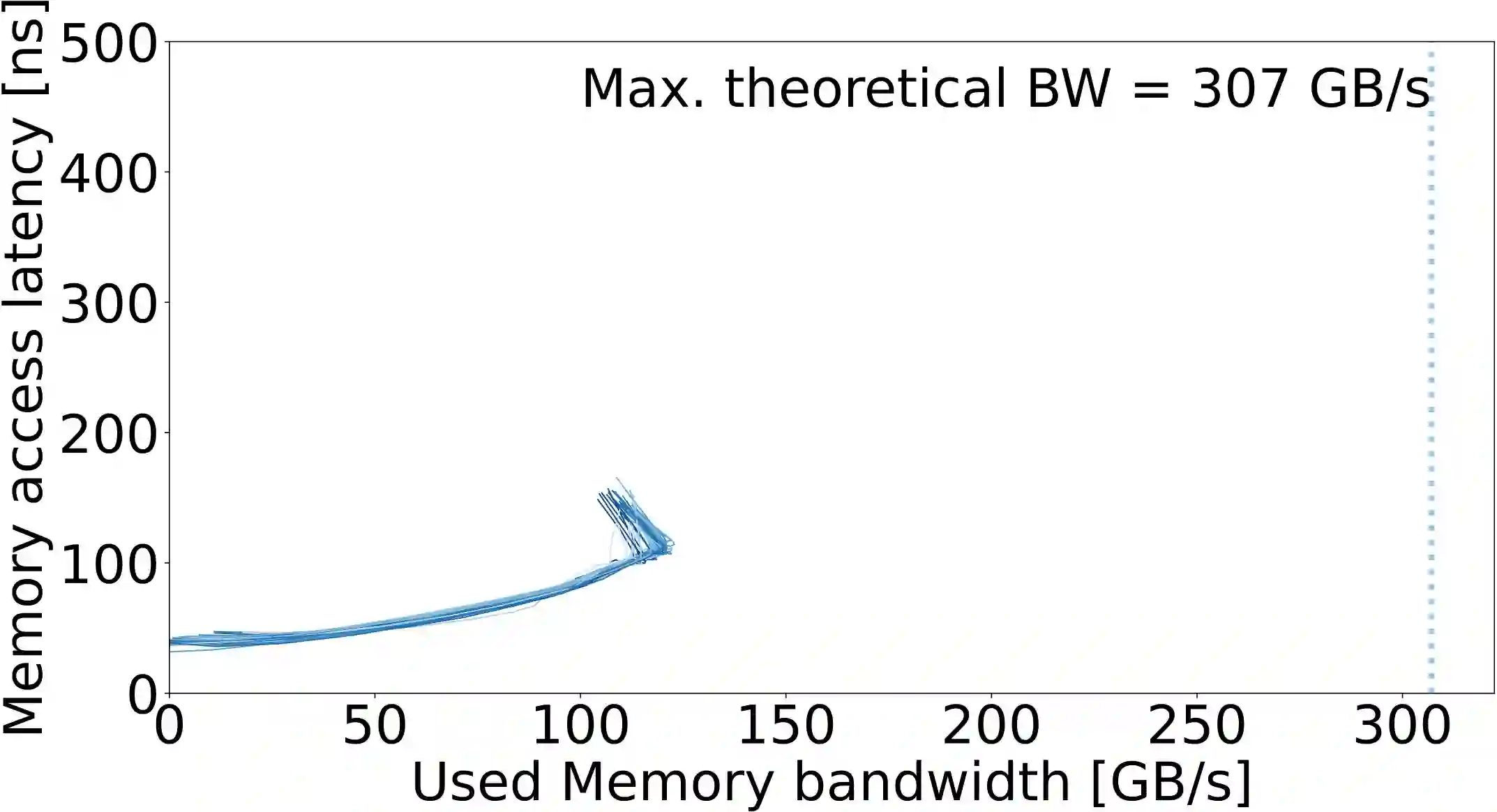

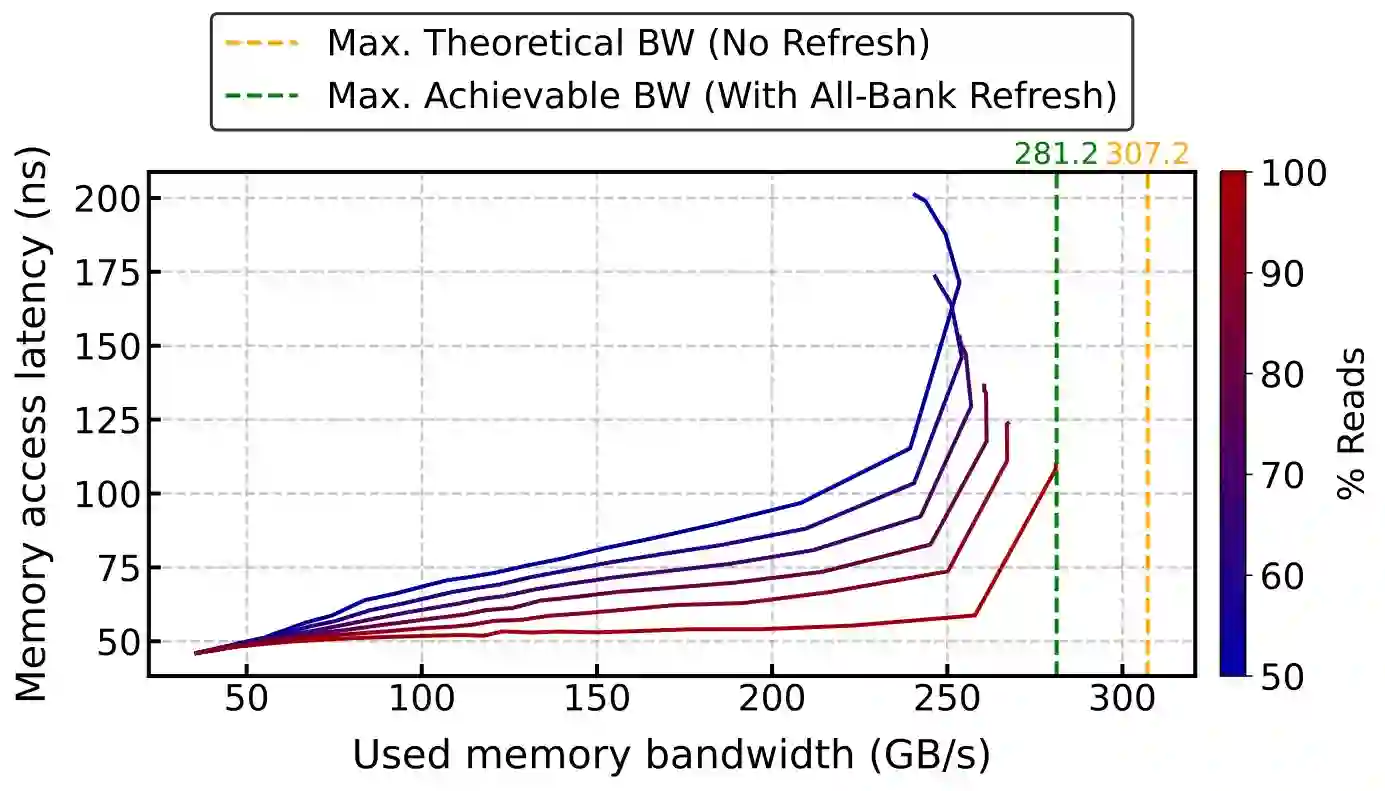

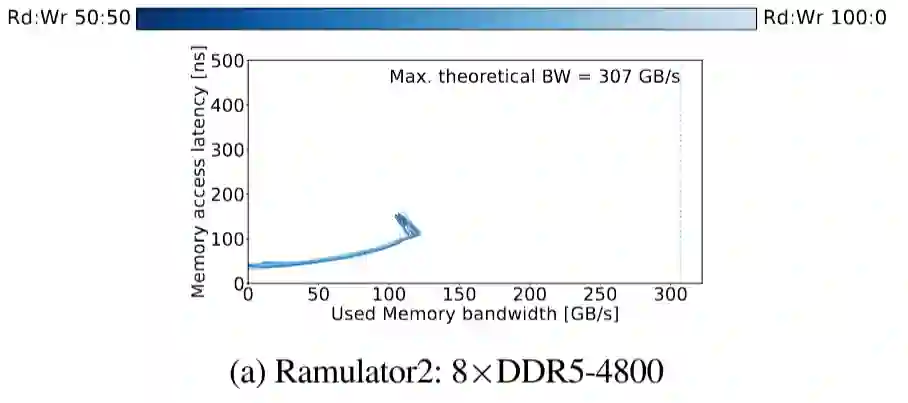

A MICRO 2024 best paper runner-up publication (the Mess paper) with all three artifact badges awarded (including "Reproducible") proposes a new benchmark to evaluate real and simulated memory system performance. In this paper, we demonstrate that the Ramulator 2.0 simulation results reported in the Mess paper are incorrect and, at the time of the publication of the Mess paper, irreproducible. We find that the authors of Mess paper made multiple trivial human errors in both the configuration and usage of the simulators. We show that by correctly configuring Ramulator 2.0, Ramulator 2.0's simulated memory system performance actually resembles real system characteristics well, and thus a key claimed contribution of the Mess paper is factually incorrect. We also identify that the DAMOV simulation results in the Mess paper use wrong simulation statistics that are unrelated to the simulated DRAM performance. Moreover, the Mess paper's artifact repository lacks the necessary sources to fully reproduce all the Mess paper's results. Our work corrects the Mess paper's errors regarding Ramulator 2.0 and identifies important issues in the Mess paper's memory simulator evaluation methodology. We emphasize the importance of both carefully and rigorously validating simulation results and contacting simulator authors and developers, in true open source spirit, to ensure these simulators are used with correct configurations and as intended. We encourage the computer architecture community to correct the Mess paper's errors. This is necessary to prevent the propagation of inaccurate and misleading results, and to maintain the reliability of the scientific record. Our investigation also opens up questions about the integrity of the review and artifact evaluation processes. To aid future work, our source code and scripts are openly available at https://github.com/CMU-SAFARI/ramulator2/tree/mess.

翻译:一篇获得MICRO 2024最佳论文亚军(即《Mess》论文)并囊括全部三项实验制品徽章(包括“可复现”徽章)的论文,提出了评估真实与模拟内存系统性能的新基准。本文论证了《Mess》论文中报告的Ramulator 2.0模拟结果是错误的,且在该论文发表时不可复现。我们发现《Mess》论文作者在模拟器的配置与使用中犯下了多个低级人为错误。通过正确配置Ramulator 2.0,我们证明其模拟的内存系统性能实际上能很好地反映真实系统特性,因此《Mess》论文所宣称的一项关键贡献在事实上是不成立的。我们还发现《Mess》论文中的DAMOV模拟结果使用了与模拟DRAM性能无关的错误统计量。此外,《Mess》论文的实验制品仓库缺乏完整复现其全部结果所需的源代码。本研究修正了《Mess》论文关于Ramulator 2.0的错误,并指出了该论文在内存模拟器评估方法中的重要问题。我们强调,必须以严谨态度验证模拟结果,并本着真正的开源精神联系模拟器作者与开发者,以确保这些模拟器以正确配置按设计意图使用。我们呼吁计算机体系结构学界共同修正《Mess》论文的错误,这对于防止不准确和误导性结果的传播、维护科学记录的可靠性至关重要。我们的调查亦引发了对评审流程与实验制品评估过程完整性的质疑。为助力后续研究,我们的源代码与脚本已公开于https://github.com/CMU-SAFARI/ramulator2/tree/mess。