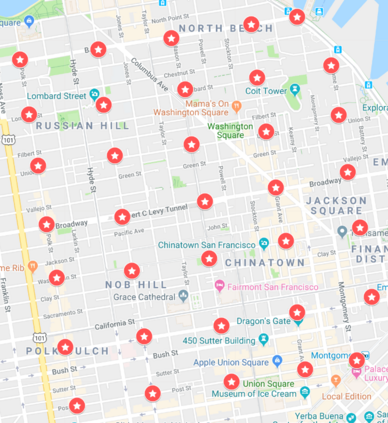

We study the distributed synthesis of policies for multi-agent systems to perform \emph{spatial-temporal} tasks. We formalize the synthesis problem as a \emph{factored} Markov decision process subject to \emph{graph temporal logic} specifications. The transition function and task of each agent are functions of the agent itself and its neighboring agents. In this work, we develop another distributed synthesis method, which improves the scalability and runtime by two orders of magnitude compared to our prior work. The synthesis method decomposes the problem into a set of smaller problems, one for each agent by leveraging the structure in the model, and the specifications. We show that the running time of the method is linear in the number of agents. The size of the problem for each agent is exponential only in the number of neighboring agents, which is typically much smaller than the number of agents. We demonstrate the applicability of the method in case studies on disease control, urban security, and search and rescue. The numerical examples show that the method scales to hundreds of agents with hundreds of states per agent and can also handle significantly larger state spaces than our prior work.

翻译:我们研究多试剂系统用于执行 emph{spatial- 时空任务的政策分布式合成方法。 我们根据\ emph{ phiced} Markov 的规格将合成问题正式化为符合 emph{ 时间逻辑} 规格的马可夫 决策程序。 每个代理器的过渡功能和任务都是该代理器本身及其邻近代理器的功能。 在这项工作中, 我们开发了另一个分布式合成方法, 与我们先前的工作相比, 该方法提高了可扩缩性和运行时间, 与我们先前的工作相比, 以两个数量级的大小。 合成方法将问题分解成一组较小的问题, 每个代理器的运行时间在模型和规格上。 我们显示该方法的运行时间是线性, 代理器的运行时间是线性, 并且每个代理器的数量只有近似小于代理器的数量, 。 我们展示了该方法在疾病控制、 城市安全和搜索和救援案例研究中的适用性。 数字示例显示, 方法的规模是数百, 每个代理器器具有数百 国家, 并且也能处理比我们以前的工作大得多的州空间 。