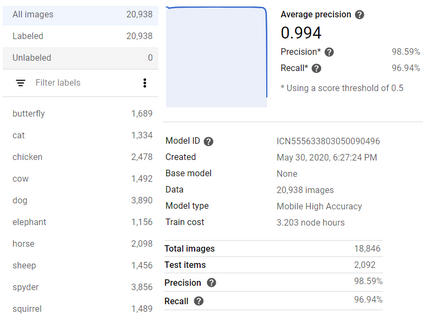

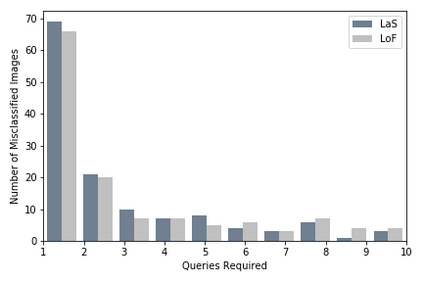

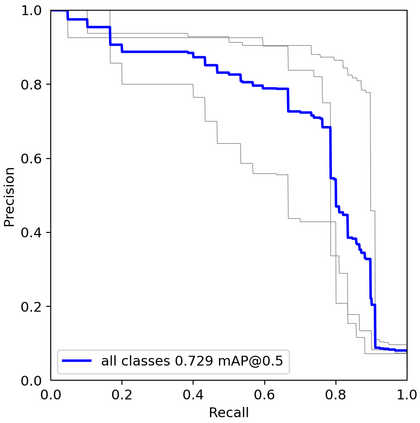

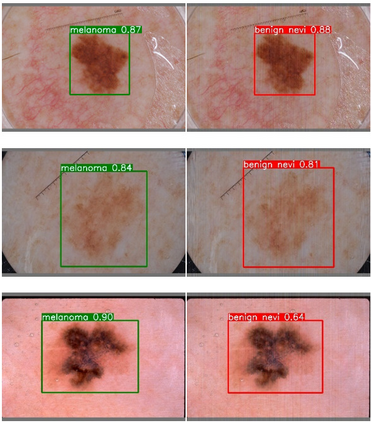

Applications of machine learning (ML) models and convolutional neural networks (CNNs) have been rapidly increased. Although state-of-the-art CNNs provide high accuracy in many applications, recent investigations show that such networks are highly vulnerable to adversarial attacks. The black-box adversarial attack is one type of attack that the attacker does not have any knowledge about the model or the training dataset, but it has some input data set and their labels. In this paper, we propose a novel approach to generate a black-box attack in sparse domain whereas the most important information of an image can be observed. Our investigation shows that large sparse (LaS) components play a critical role in the performance of image classifiers. Under this presumption, to generate adversarial example, we transfer an image into a sparse domain and put a threshold to choose only k LaS components. In contrast to the very recent works that randomly perturb k low frequency (LoF) components, we perturb k LaS components either randomly (query-based) or in the direction of the most correlated sparse signal from a different class. We show that LaS components contain some middle or higher frequency components information which leads fooling image classifiers with a fewer number of queries. We demonstrate the effectiveness of this approach by fooling six state-of-the-art image classifiers, the TensorFlow Lite (TFLite) model of Google Cloud Vision platform, and YOLOv5 model as an object detection algorithm. Mean squared error (MSE) and peak signal to noise ratio (PSNR) are used as quality metrics. We also present a theoretical proof to connect these metrics to the level of perturbation in the sparse domain.

翻译:机器学习模型( ML) 模型和神经神经网络( CNNs) 的应用迅速增加。 虽然最先进的CNN 在许多应用程序中提供高度精准性, 但最近的调查显示, 这些网络极易受到对抗性攻击。 黑盒对抗性攻击是一种攻击类型, 攻击者对模型或培训数据集一无所知, 但是它有一些输入数据集和标签 。 在本文中, 我们提议一种新颖的方法, 在稀疏域范围内生成黑盒攻击, 而可以观察到最重要的图像信息 。 我们的调查显示, 大量稀释( LAS) 组件在图像分解器的性能方面发挥着关键作用。 在此假设下, 我们将一个图像转换到一个稀疏的域域域, 并设定一个仅选择 kLS 组件的门槛 。 与最近一些随机扰动 k 低频( 低频) 组件相比, 我们对KLAS 的峰值构成随机随机( 基), 或位于一个不同类别最相近的具体目标信号方向 。 我们展示了LAS 的中位 或高频 图像 。