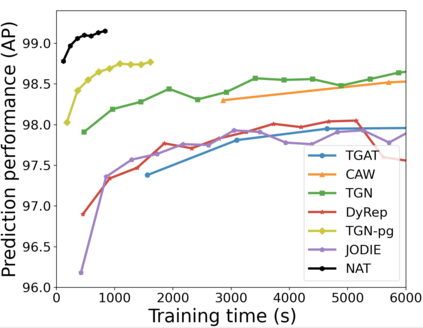

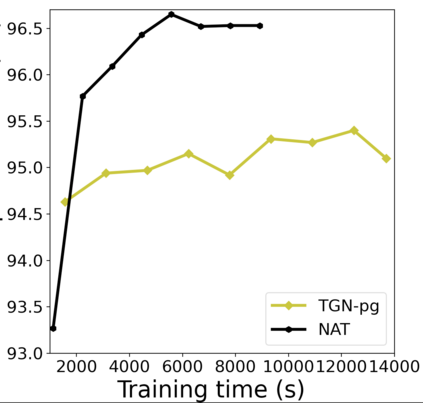

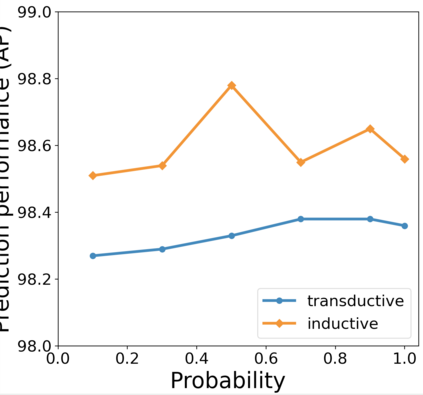

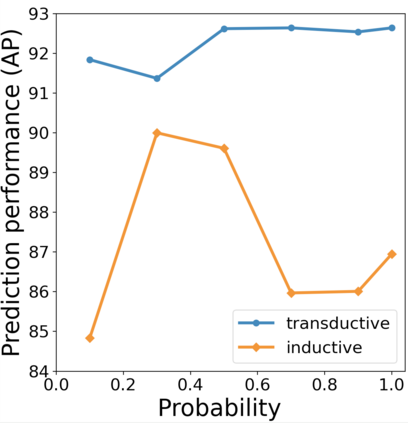

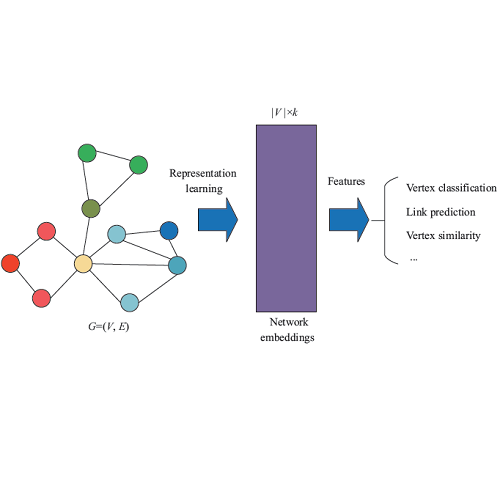

Temporal networks have been widely used to model real-world complex systems such as financial systems and e-commerce systems. In a temporal network, the joint neighborhood of a set of nodes often provides crucial structural information on predicting whether they may interact at a certain time. However, recent representation learning methods for temporal networks often fail to extract such information or depend on extremely time-consuming feature construction approaches. To address the issue, this work proposes Neighborhood-Aware Temporal network model (NAT). For each node in the network, NAT abandons the commonly-used one-single-vector-based representation while adopting a novel dictionary-type neighborhood representation. Such a dictionary representation records a down-sampled set of the neighboring nodes as keys, and allows fast construction of structural features for a joint neighborhood of multiple nodes. We also design dedicated data structure termed N-cache to support parallel access and update of those dictionary representations on GPUs. NAT gets evaluated over seven real-world large-scale temporal networks. NAT not only outperforms all cutting-edge baselines by averaged 5.9% and 6.0% in transductive and inductive link prediction accuracy, respectively, but also keeps scalable by achieving a speed-up of 4.1-76.7 against the baselines that adopts joint structural features and achieves a speed-up of 1.6-4.0 against the baselines that cannot adopt those features. The link to the code: https://github.com/Graph-COM/Neighborhood-Aware-Temporal-Network.

翻译:热量网络被广泛用于模拟真实世界复杂的系统,如金融系统和电子商务系统。在一个时间网络中,一组节点的共同邻里往往提供关键的结构性信息,说明它们是否在某个时候进行互动。然而,最近的时间网络的代表学习方法往往不能提取这种信息,或依赖于耗时性特征构建方法。为解决这一问题,这项工作提议了邻里-仓储时间网络模型(NAT)。对于网络中的每一个节点,NAT放弃常用的单级-视频基代表制,同时采用新颖的字典类型的邻里代表制。这样的字典代表制记录了一组下版的邻里节点作为密钥,并允许为多个节点的联合邻里快速构建结构特征。我们还设计了名为N-cache的专门数据结构,以支持平行访问和更新GPUP的词典表达方式。NAT在7个真实的大型时间网络中得到了评估。NAT不仅超越了所有以平均5.9%和6.0级格式格式为基础的基线,而且无法在结构-轨道上分别实现这些基准和速度的同步链接。