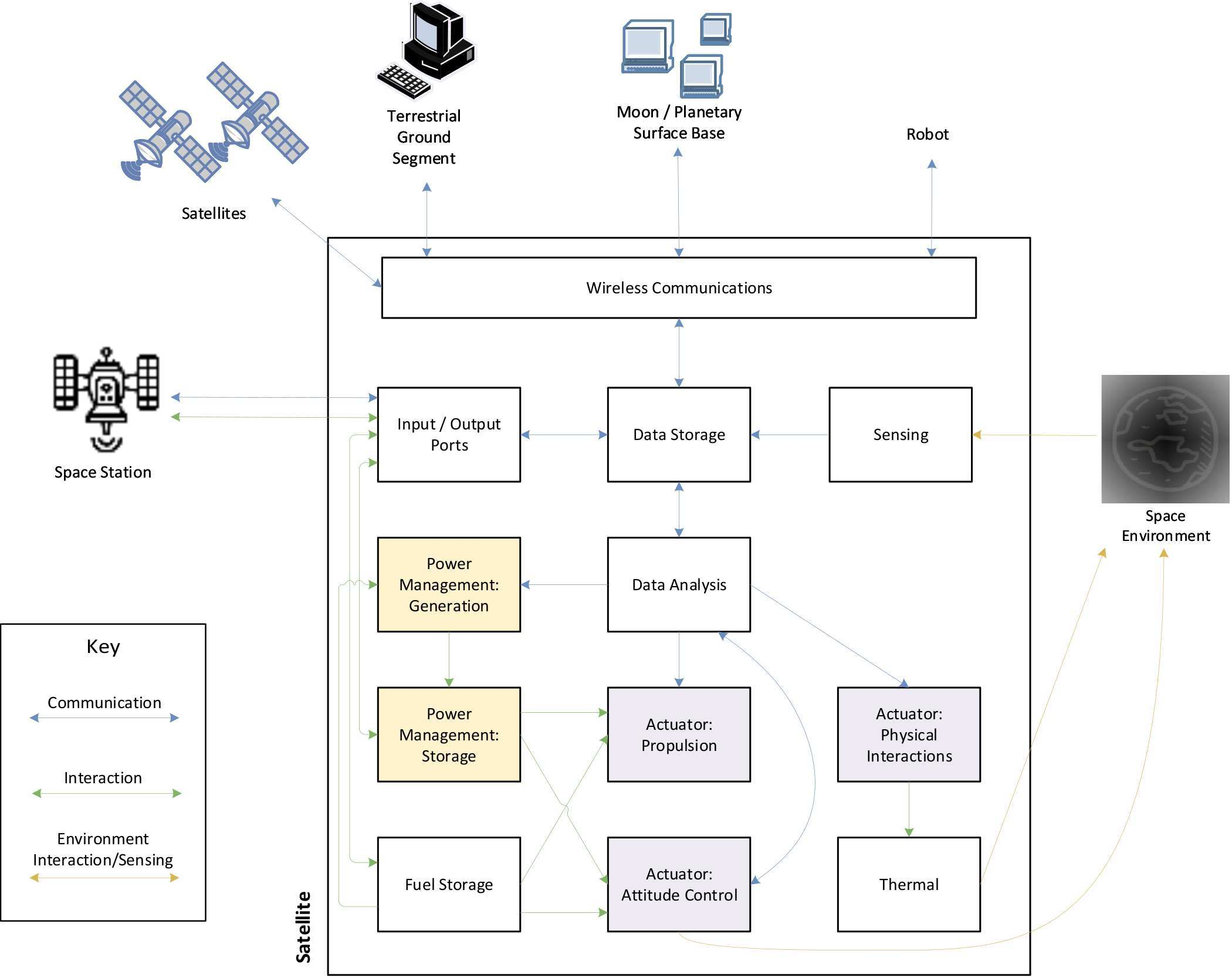

The rise of NewSpace provides a platform for small and medium businesses to commercially launch and operate satellites in space. In contrast to traditional satellites, NewSpace provides the opportunity for delivering computing platforms in space. However, computational resources within space are usually expensive and satellites may not be able to compute all computational tasks locally. Computation Offloading (CO), a popular practice in Edge/Fog computing, could prove effective in saving energy and time in this resource-limited space ecosystem. However, CO alters the threat and risk profile of the system. In this paper, we analyse security issues in space systems and propose a security-aware algorithm for CO. Our method is based on the reinforcement learning technique, Deep Deterministic Policy Gradient (DDPG). We show, using Monte-Carlo simulations, that our algorithm is effective under a variety of environment and network conditions and provide novel insights into the challenge of optimised location of computation.

翻译:“新空间”的兴起为中小商业企业提供了空间卫星商业发射和运营平台。与传统卫星相比,“新空间”为空间计算机平台的交付提供了机会。然而,空间内部的计算资源通常费用昂贵,卫星可能无法在当地计算所有计算任务。Edge/Fog计算中的一种流行做法“计算卸载(CO)”可以证明在这种资源有限的空间生态系统中节省能源和时间是有效的。然而,CO改变了系统的威胁和风险配置。在本文中,我们分析了空间系统中的安全问题,并为CO提出了“安全意识”算法。我们的方法是以强化学习技术“深确定政策梯度 ” ( DDPG)为基础的。我们利用蒙特-卡罗的模拟方法表明,我们的算法在各种环境和网络条件下是有效的,并对优化计算地点的挑战提供了新的洞察力。