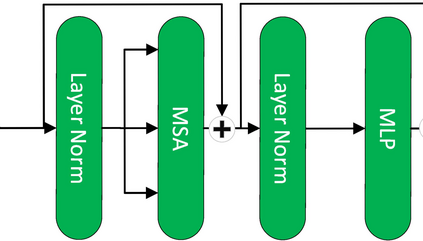

The Transformer architecture has achieved rapiddevelopment in recent years, outperforming the CNN archi-tectures in many computer vision tasks, such as the VisionTransformers (ViT) for image classification. However, existingvisual transformer models aim to extract semantic informationfor high-level tasks such as classification and detection, distortingthe spatial resolution of the input image, thus sacrificing thecapacity in reconstructing the input or generating high-resolutionimages. In this paper, therefore, we propose a Patch PyramidTransformer(PPT) to effectively address the above issues. Specif-ically, we first design a Patch Transformer to transform theimage into a sequence of patches, where transformer encodingis performed for each patch to extract local representations.In addition, we construct a Pyramid Transformer to effectivelyextract the non-local information from the entire image. Afterobtaining a set of multi-scale, multi-dimensional, and multi-anglefeatures of the original image, we design the image reconstructionnetwork to ensure that the features can be reconstructed intothe original input. To validate the effectiveness, we apply theproposed Patch Pyramid Transformer to the image fusion task.The experimental results demonstrate its superior performanceagainst the state-of-the-art fusion approaches, achieving the bestresults on several evaluation indicators. The underlying capacityof the PPT network is reflected by its universal power in featureextraction and image reconstruction, which can be directlyapplied to different image fusion tasks without redesigning orretraining the network.

翻译:近年来,变异器结构取得了快速发展,超过了CNN的古老时代,在很多计算机视觉任务中表现优于CNN的古代,例如用于图像分类的View Transfer(VIT),然而,现有的视觉变异器模型旨在为高级任务提取语义信息,如分类和检测,扭曲输入图像的空间分辨率,从而牺牲重建输入或生成高分辨率图像的能力。因此,我们在本文件中提议建立一个Patch Pyramid Transferent(PPPT),以有效解决上述问题。从外观角度讲,我们首先设计了一个修补变异器,将图像转换成一个补异序列,每个补异的变异器编码都用于提取本地表示。此外,我们建造了一台Pyramid变异器,将非本地信息从整个图像中有效提取。在保存一套多尺度、多维度和多相交错的原始图像模型之后,我们设计了图像重建网络的网络,以确保这些特征可以重建成原始的原图像。为了验证其原始输入的图像,我们用变异的变异性变变变的图像模型,我们应用了它的图像变的图像变变的模型, 将它的模型的图像升级的模型的模型的模型的模型的模型的模型的模型的模型的模型,可以用来进行实验性变现。