【普林斯顿大学-微软】加权元学习,Weighted Meta-Learning

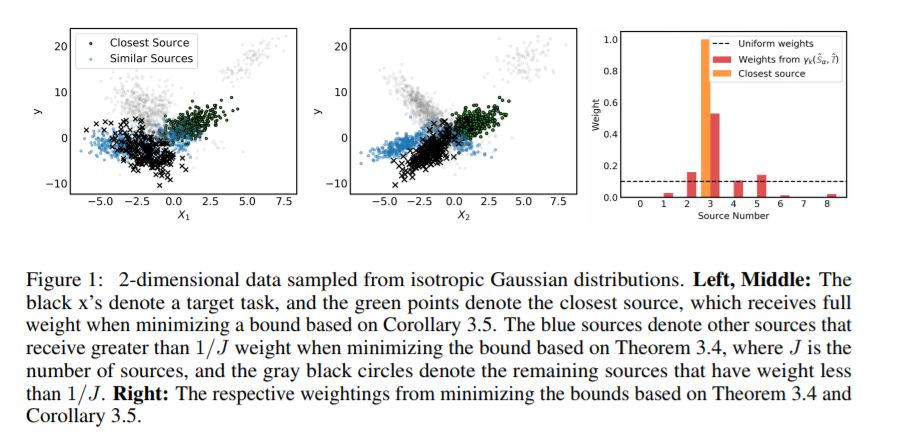

元学习利用相关的源任务来学习初始化,可以通过有限的标记示例将初始化快速调整到目标任务。然而,许多流行的元学习算法,如模型无关元学习(MAML),都只假设可以访问目标样本进行微调。在这项工作中,我们提供了一个通用的元学习框架,该框架基于对不同源任务的损失进行加权,其中的权重允许依赖于目标样本。在这个一般的设置中,我们提供了基于积分概率度量(IPM)和Rademacher复杂性的源任务加权经验风险和预期目标风险之间距离的上限,该上限适用于包括MAML和加权MAML变体在内的许多元学习设置。然后开发一个基于最小化误差学习算法对实证IPM,包括α-MAML加权MAML算法。最后,我们实证地证明了我们的加权元学习算法能够比单加权元学习算法(如MAML)找到更好的初始化。

https://arxiv.org/abs/2003.09465

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“WML” 就可以获取《【普林斯顿大学-微软】加权元学习,Weighted Meta-Learning》专知下载链接

登录查看更多

相关内容

专知会员服务

54+阅读 · 2020年3月5日

专知会员服务

33+阅读 · 2020年2月29日

专知会员服务

32+阅读 · 2020年2月26日