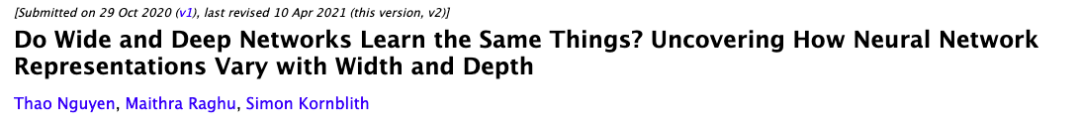

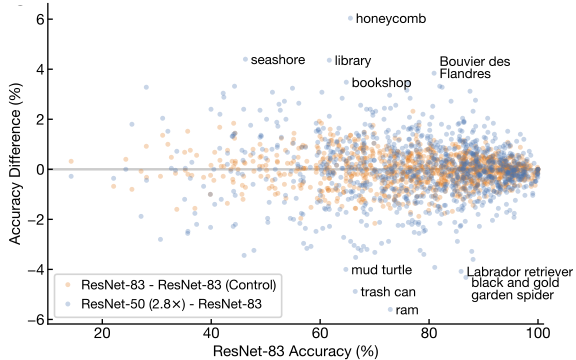

更宽还是更深?Google AI:广度网络和深度网络能学到同样的东西吗?

新智元报道

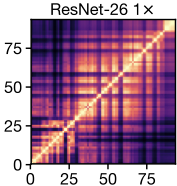

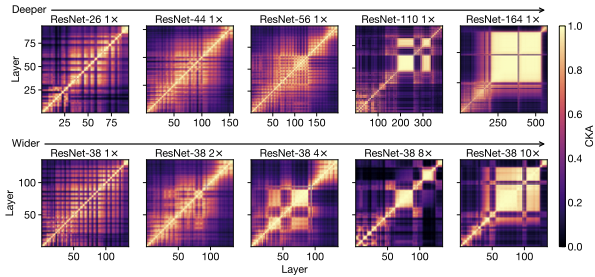

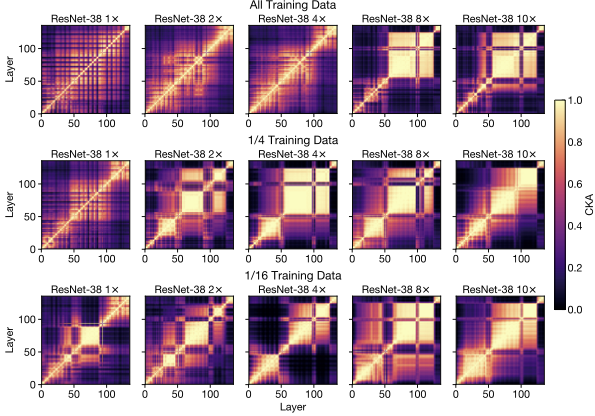

【新智元导读】广度网络和深度网络学到的东西是一样的吗?下面这篇文章也许能给你一些思路。

登录查看更多