深度解析神经网络中每个神经元的使命 | MIT朱俊彦&港中文周博磊力作

作者 | 李科雨

编辑 | 陈大鑫

论文链接:https://arxiv.org/pdf/2009.05041v1.pdf

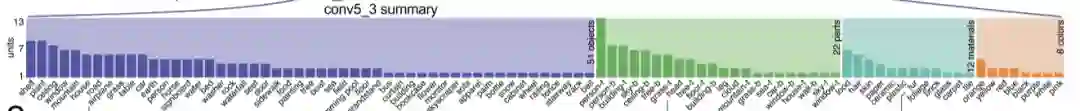

每个神经元的使命之探索

-

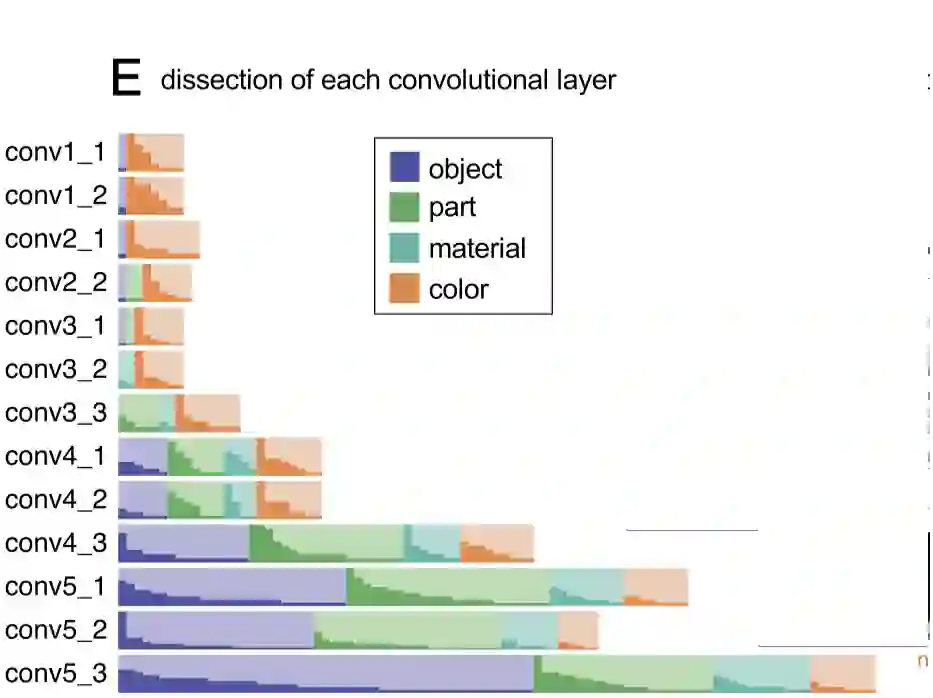

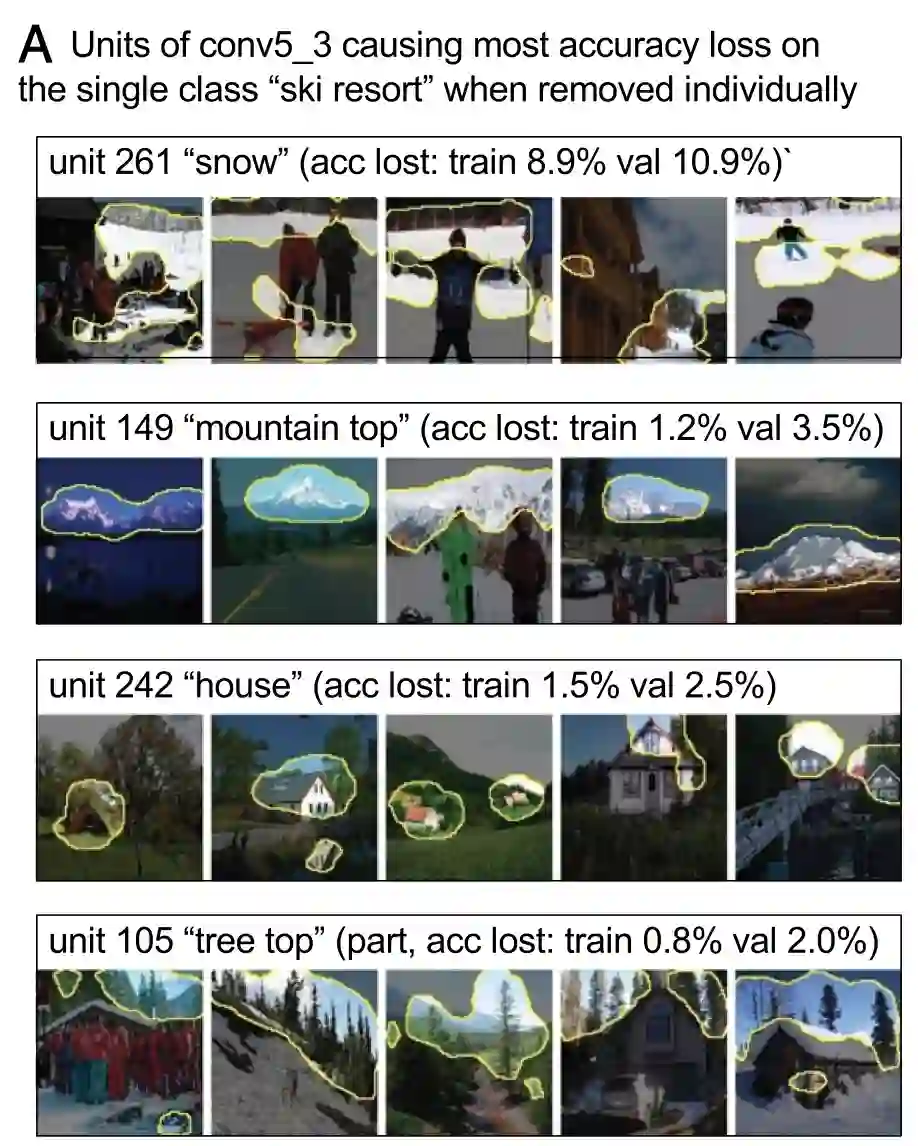

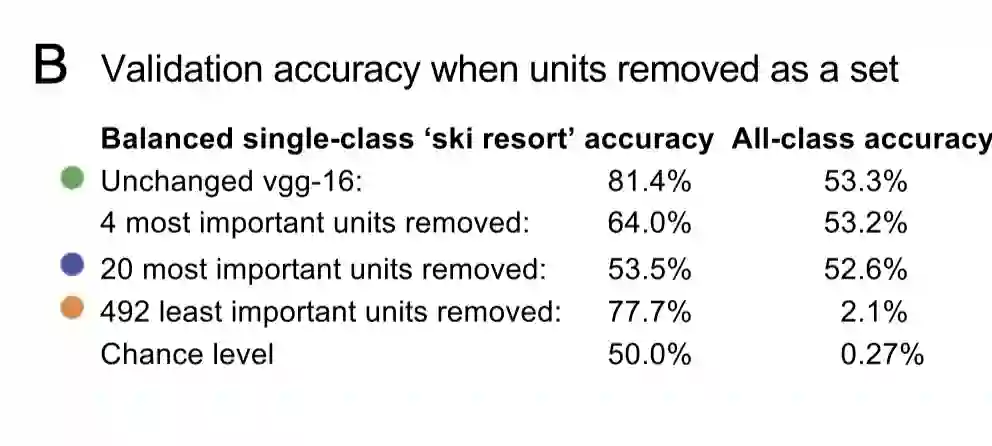

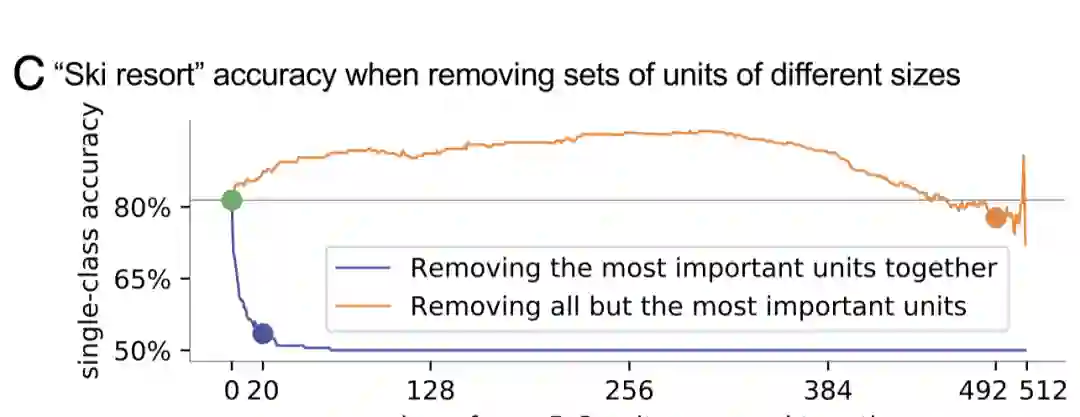

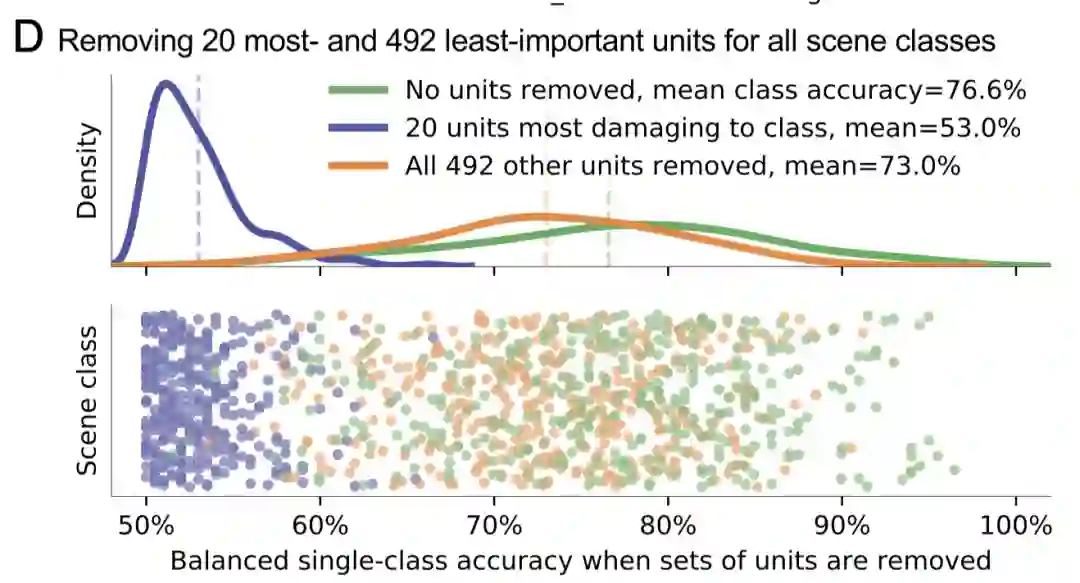

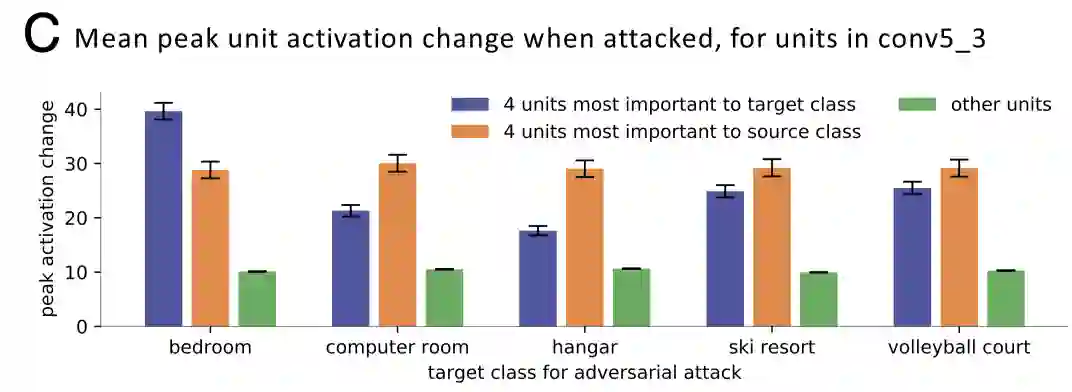

在分类器中,本文主要使用这些干预措施,去探索了一小部分的对应视觉具体概念的神经单元是否可以解释某个特定类的分类表现。 举个例子,研究团队探索了当移动一部分检测雪,山脉,树和房屋的神经元之后,整个网络将图像分类为滑雪胜地的能力将如何被影响。 -

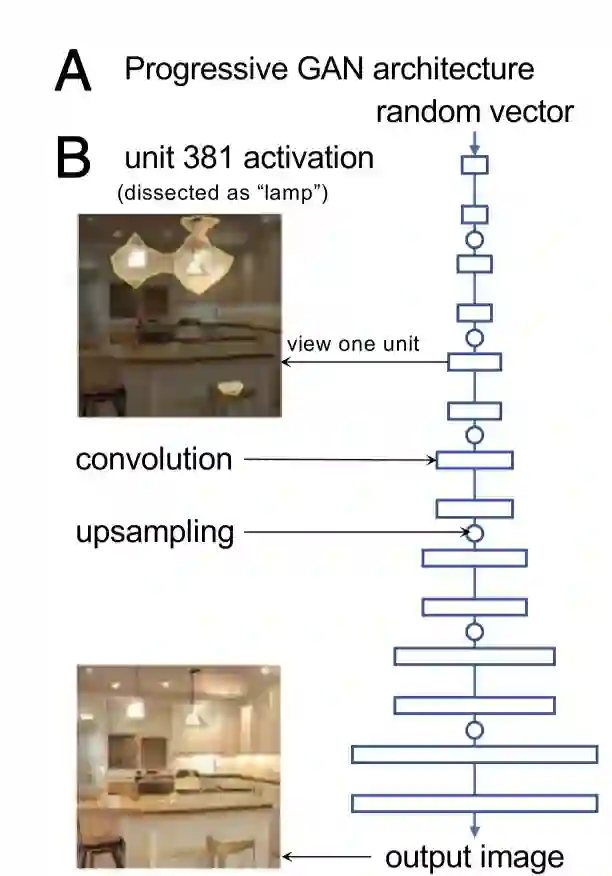

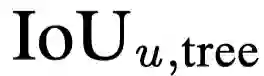

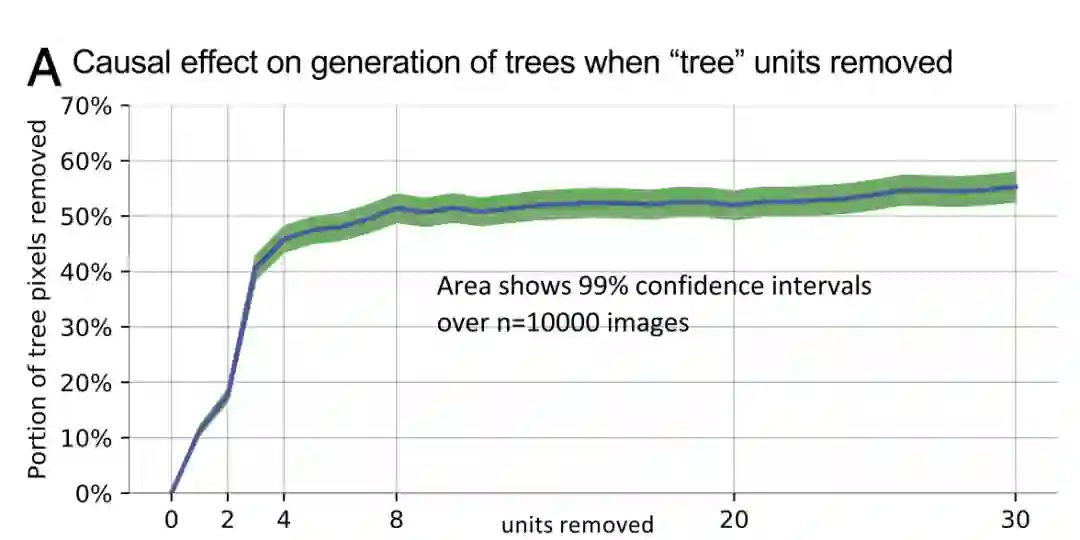

在场景图像生成器神经网络中,研究人员探索了对应于具体对象的单元是如何影响风景中具体物体的渲染的。 比如,移动树单元是如何影响输出图像树的外观和其他物体的展现的。

-

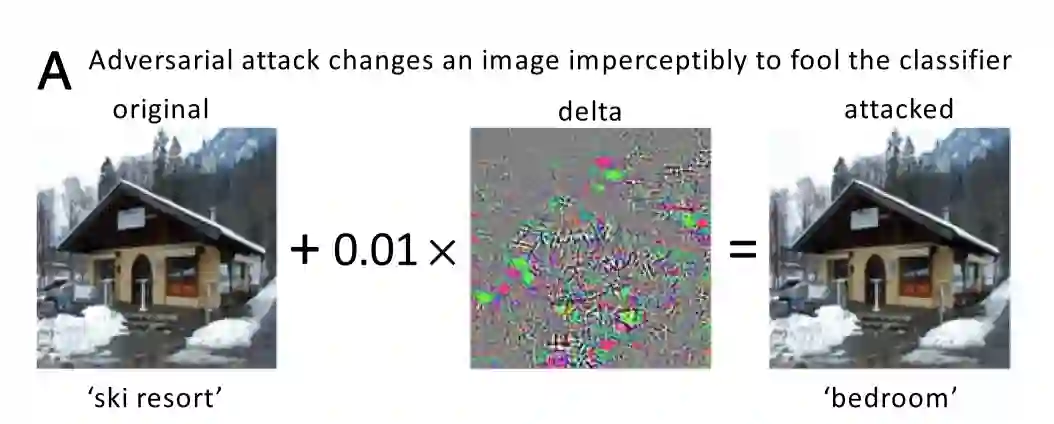

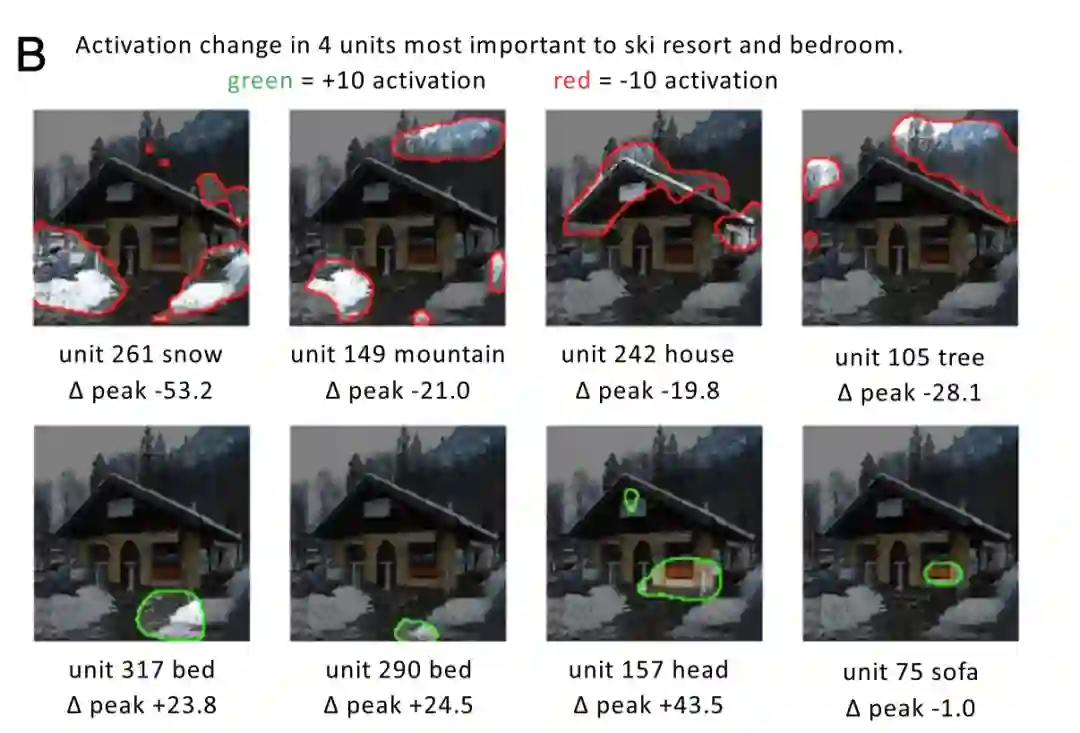

研究人员展示了,在某个分类器上的对抗攻击其实可以被理解为对对应于某个类的重要神经元的攻击。 -

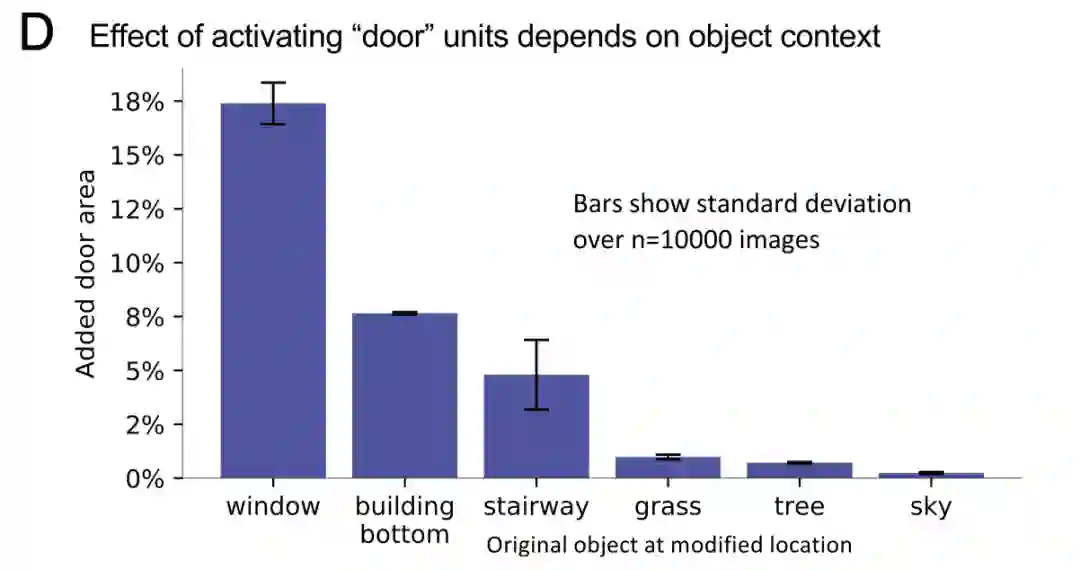

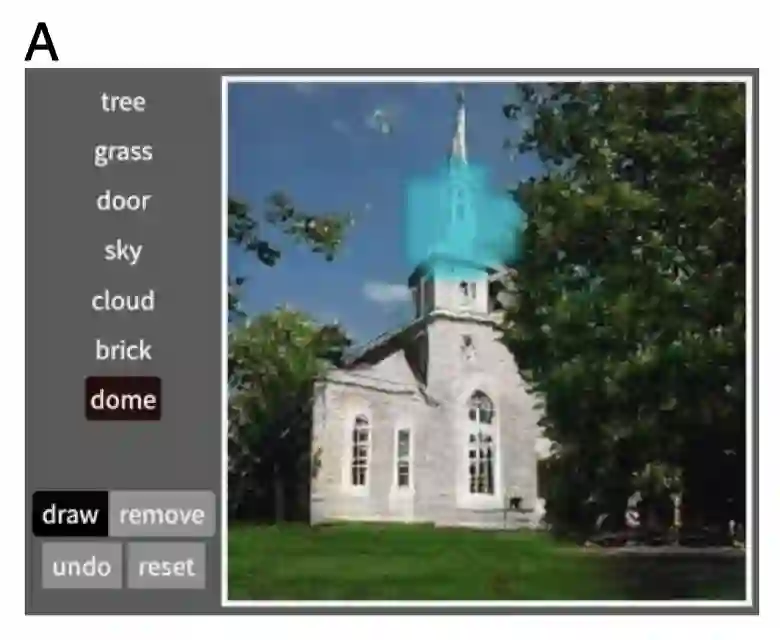

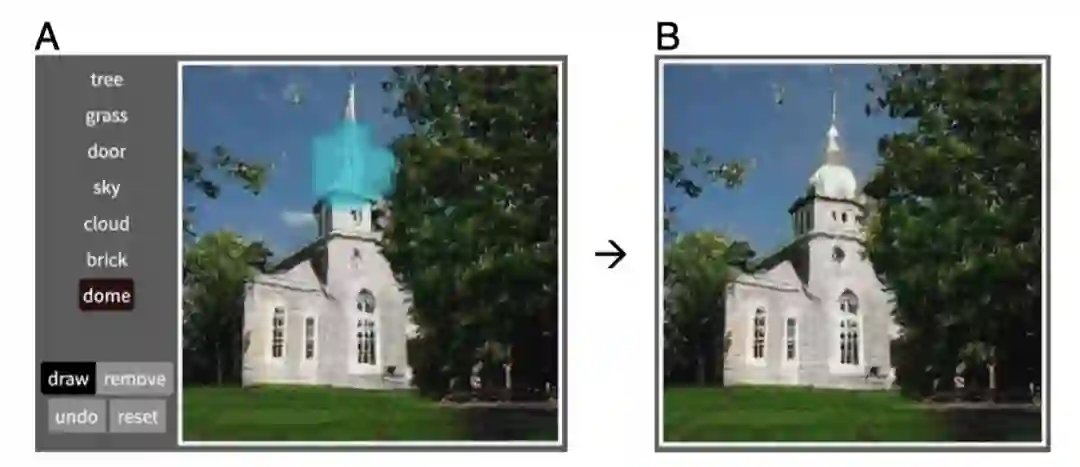

同时,研究人员将单元干预措施使用在生成器上,通过直接操纵神经元的机制,使得人们可以在风景画上修改诸如树和门之类的语义概念。

2

实验结果

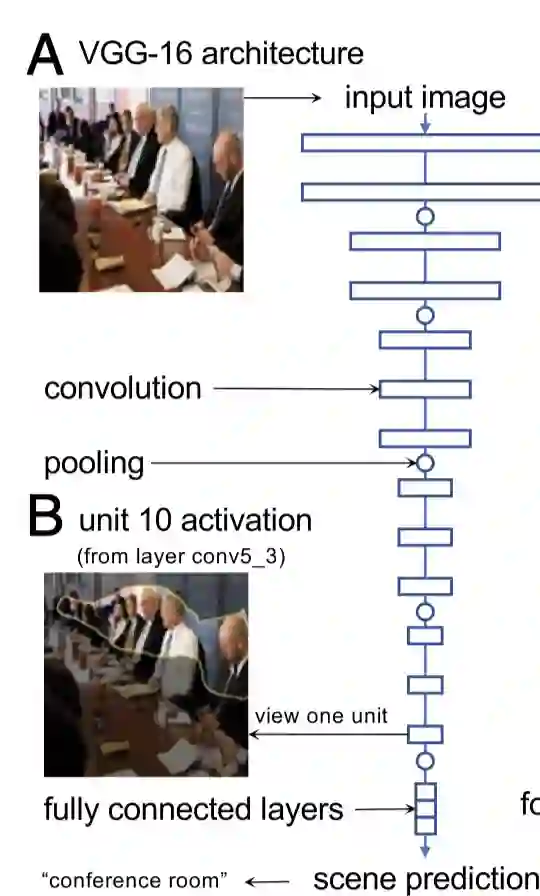

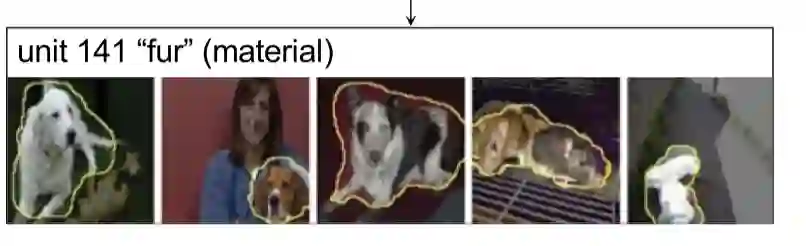

景色分类器中物体检测器的出现

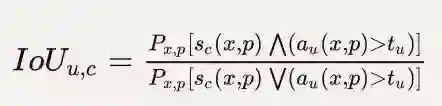

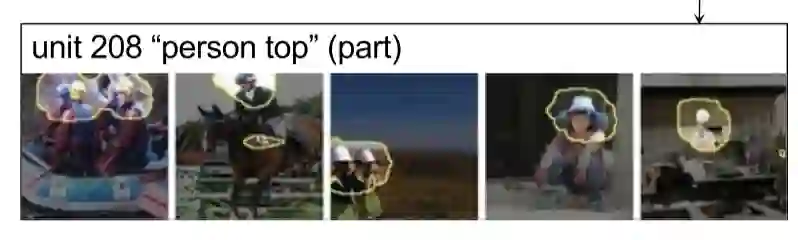

的top1%值)的激活区域进行高亮,结果如图下所示:

的top1%值)的激活区域进行高亮,结果如图下所示:

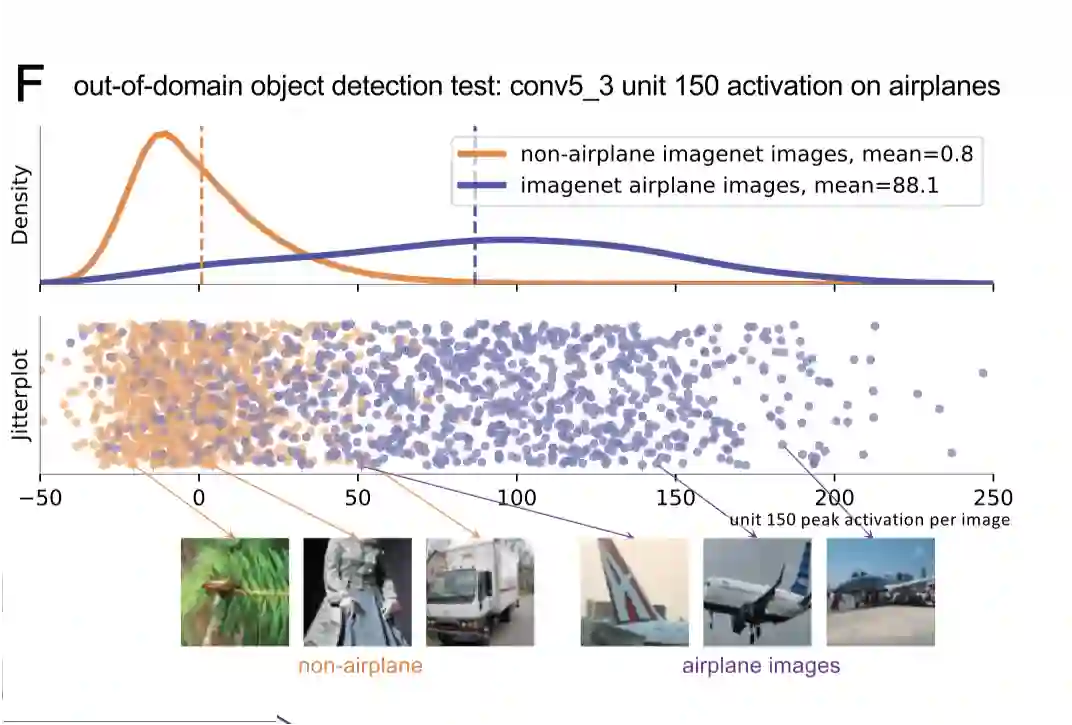

很有趣的是,即使在训练的时候并没有标记,物体检测器依然出现了。下图展示了单元150(对应于物体飞机)在飞机和非飞机样本图像上的活跃度:

很有趣的是,即使在训练的时候并没有标记,物体检测器依然出现了。下图展示了单元150(对应于物体飞机)在飞机和非飞机样本图像上的活跃度:

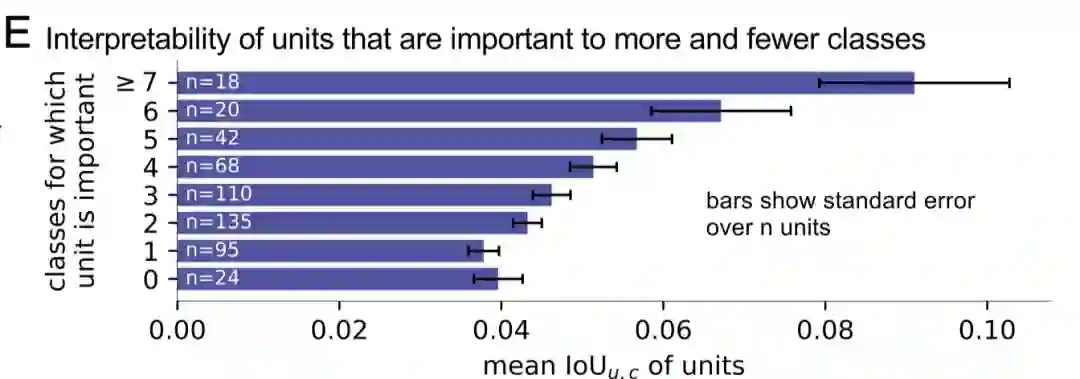

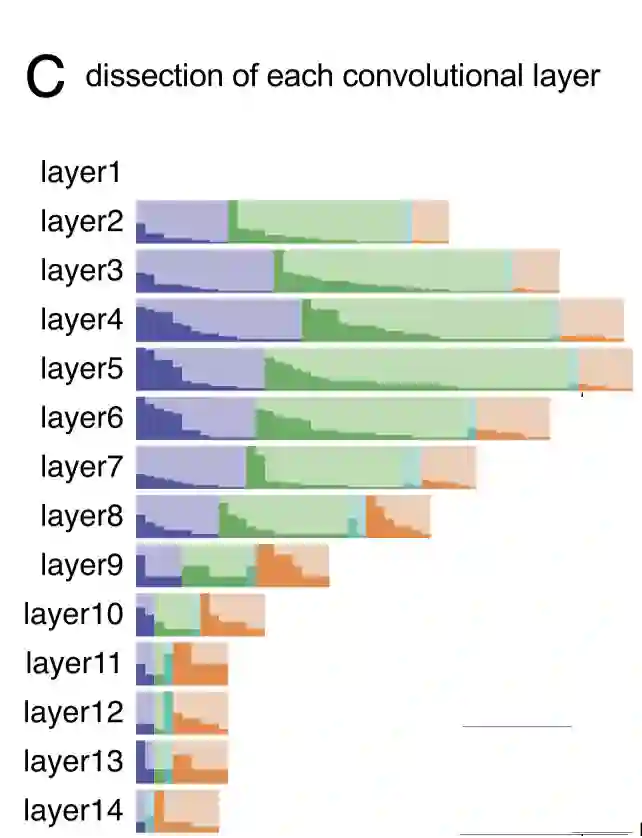

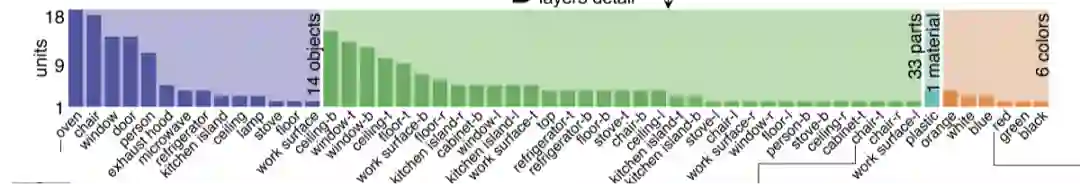

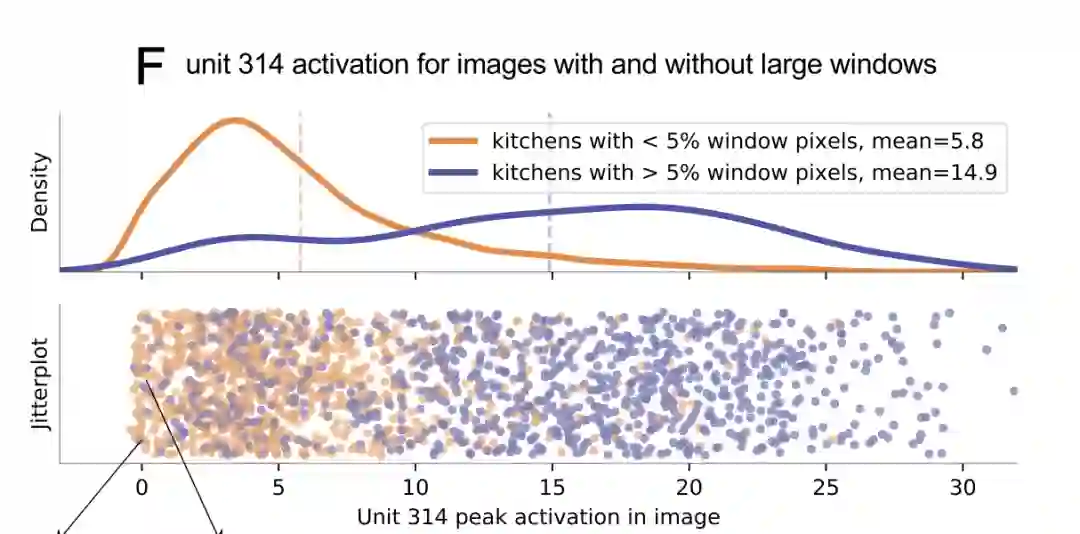

场景分类器中神经元的角色

对抗生成网络中物体检测器的出现

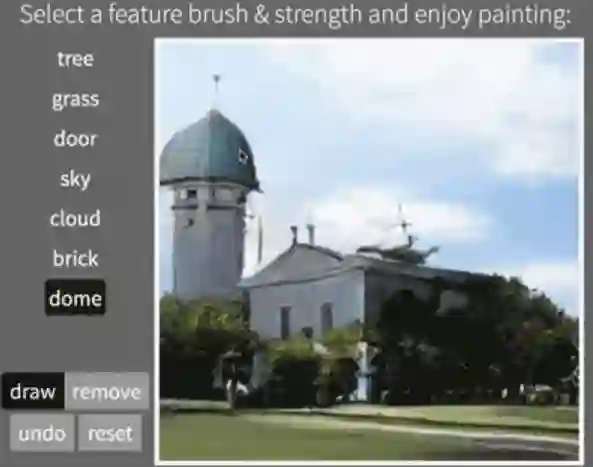

GAN中神经元的角色

将第四层的单元进行了排序,来定义和树最具有关联的单元。

将第四层的单元进行了排序,来定义和树最具有关联的单元。

找到了在第四层中和门最相关的神经单元。

找到了在第四层中和门最相关的神经单元。

值,下图展示了在两个生成图像上的结果:

值,下图展示了在两个生成图像上的结果:

3

实际应用

对分类器的对抗攻击的分析

使用GAN的语义绘画

登录查看更多

相关内容

Arxiv

0+阅读 · 2021年1月30日