神经网络其实和人一样懒惰,喜欢走捷径......

来源:CSDN

以下为译文:

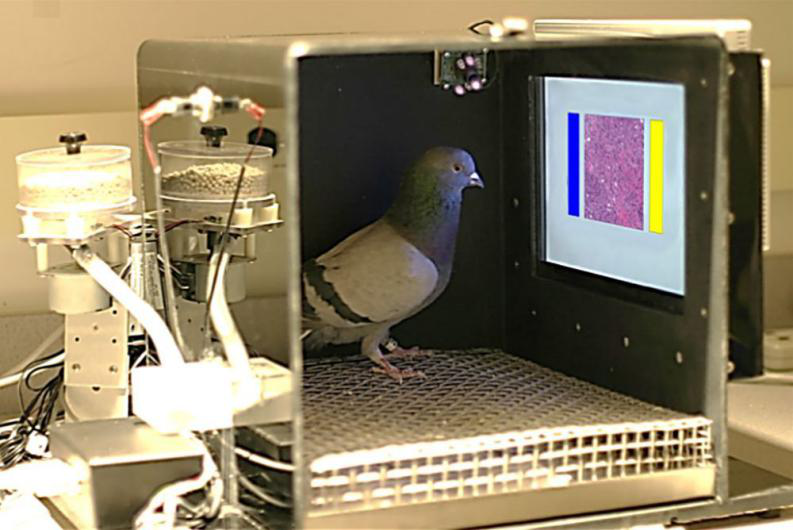

人工智能会很快取代放射科医生吗?最近,研究人员训练了一个深度神经网络对乳腺癌进行分类,其准确度达到了85%。当与其他三种神经网络模型结合使用时,最终的集成方法达到了出色的99%的分类准确度,可以与经过多年训练的放射专家相媲美。

上述关于乳腺癌的分类结果是正确的,但有一点小问题:研究人员没有使用最先进的人工深度神经网络,而是训练“自然”神经网络——更准确地说,是用四只鸽子来诊断乳腺癌。

2018年,加利福尼亚大学的研究员发现鸽子对乳腺组织的显微图像很敏感,还能够准确通过乳腺X光片鉴别良性、恶性乳腺癌肿瘤,经过15天的训练之后,鸽子们对乳腺癌病理切片和医学影像的判断正确率就提升到了85%左右。

然而,鸽子从未被视为医学成像的未来,大公司也没有砸钱建大规模养鸽场:与我们对深度神经网络(DNNs)的期望相比,我们对鸽子并没抱太大期望。

在许多方面,DNN确实没有辜负宣传和人们的希望:它们在整个社会,行业和科学领域的成功都是不可否认的,而且新的突破仍然会在几个月(甚至几周)的时间就能实现。但是,看似脱节的失效案例仍在不断发生着:DNN在识别物体方面达到了超人的性能,但是即使很小的看不见的变化或不同的背景和环境也可能使预测完全偏离。DNN可以为图像生成合理的标题,但是,令人担忧的是,DNN可以在不真正查看该图像的情况下这样做。DNN可以准确识别人脸,但对少数群体的人脸识别错误率却非常高。DNN可以根据简历预测聘用决策,但是算法在选择的过程中却会出现偏见。

如何调和DNN超出人类的表现,同时却可能会犯下荒谬错误之间的偏差呢?我们认为,许多失败案例不是个例,而是和DNN会无意识地遵循“捷径”策略有关。虽然表面上是成功的,但稍微发生些许偏差,这些策略通常会以失败告终。

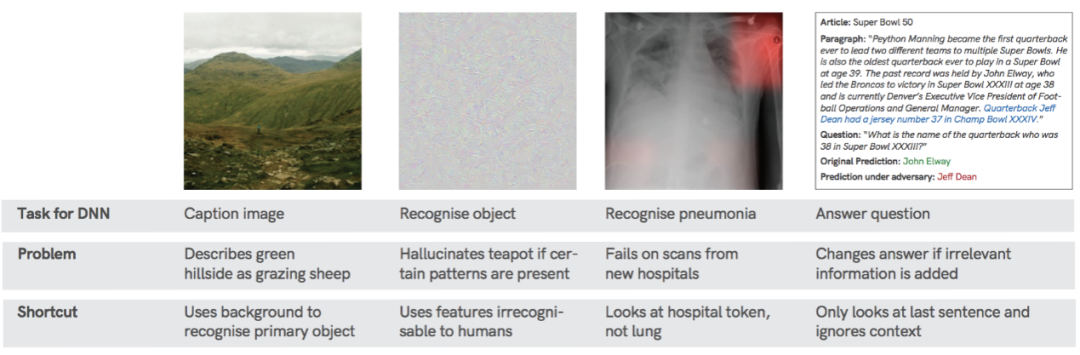

“捷径”是指在标准基准上表现良好,但在更具挑战性的测试条件上表现差的决策规则。“捷径”出现的情况多种多样,在数据集和应用程序领域中无处不在。比如:

从原则上讲,捷径学习并不是一种新现象,它有很多不同的术语名称,例如“协变移位学习 ”、“反因果学习”、“数据集偏差”、“坦克传奇 ”和“聪明汉斯效果”等。 我们在这里讨论捷径学习如何结合深度学习的问题,以及我们可以做些什么来更好地理解和使用捷径学习。

什么是捷径?

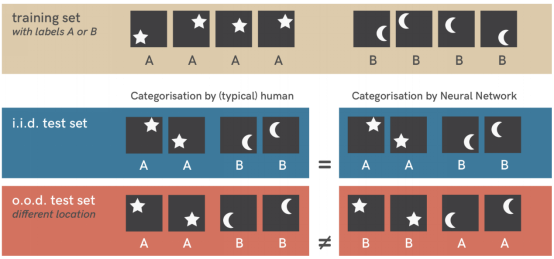

在机器学习中,模型能够学习的解决方案受数据、模型体系结构、优化器和目标函数的约束。然而,这些约束往往会允许不止一个解决方案,通常有很多不同的方法来解决同一个问题。捷径是在典型测试集上表现良好,但在不同情况下失败的解决方案,暴露出与我们的意图不符的现象。

举一个例子,当在简单的星月数据集上训练时(顶行),标准的神经网络(三层,完全连接)可以轻松地对新的类似样本(数学上称为i.i.d.测试集)进行分类。但是,在稍有不同的数据集(o.o.d.测试集,最下面一行)上对其进行测试揭示了一种捷径策略:网络已学会将对象位置与类别相关联。在训练过程中,星星总是显示在图片的右上角或左下角;月亮则显示在左上角或右下角。这种模式仍然存在于来自i.i.d.测试集(中间一行)的样本中,但在o.o.d.测试图像(下排)中不存在,从而暴露了捷径现象。这里最重要的一点是,在训练设置约束下,位置和形状都是有效的解决方案,因此,没有理由期望神经网络更喜欢其中一个。然而,人类具有使用物体形状的强烈直觉。就像这个例子看起来那样,对抗性例子,偏向机器学习模型,缺乏领域通用性和输入略有变化引起的失效等都可以理解为捷径学习现象的实例。

例如,研究人员开发了一种机器分类器,能够从多家医院的X光扫描中成功检测出肺炎,但是对于来自新医院的扫描,它的性能却出人意料地低:该模型意外地学会了以近乎完美的精确度识别特定的医院系统(例如,通过在扫描中检测到医院特定的金属标记,请参见左图)。加上医院的肺炎患病率,它在训练过程中就可以达到相当好的预测,而根本无需了解太多肺炎的知识。分类器没有学习如何“理解”肺炎,而是选择了最简单的解决方案,仅查看标记类型。

深度学习之外的捷径学习

通常,这样的失败案例可以被视为机器学习算法不可信任的原因。然而,生物学学习者也遇到非常相似的失败模式。在牛津大学实验室的一项实验中,研究人员观察到,老鼠可以仅根据细微的色差学习到穿越复杂迷宫的方法,这非常令人惊讶,因为老鼠的视网膜仅具有基本的视觉能力,视力非常差。深入研究这个奇怪的现象,我们会发现原来老鼠欺骗了研究人员:他们在实验中根本没有使用视觉系统,而是仅仅通过迷宫壁上使用的彩色涂料的气味来区分颜色。一旦控制了气味,老鼠们卓越的颜色辨别能力就消失了。

动物通常以一种意想不到的方式解决一个实验范式(即数据集),而未使用人们真正感兴趣的能力,从而迷惑实验者。对人类来说,这凸显了想用比人类现有方式更复杂的方式来解决一项艰巨的挑战是多么的困难。当然,在Marr的实验实现层面,老鼠和人的颜色辨别能力可能存在差异。但是在算法级别上,通常会默认一个假设,即类人的表现意味着类人的策略(或算法)。这种“相同的策略假设”同样存在于深度学习:即使DNN单元与生物神经元不同,但如果DNN成功识别出物体,那么似乎可以很自然地认为它们是像人类一样使用通过物体的形状来识别物体。因此,我们需要区分实验对象在一个数据集的性能表现与获取能力之间的联系,在将“物体识别”或“语言理解”等高级能力赋予机器之前,我们要非常谨慎,因为通常有一个更简单的解释:

可以归因于捷径学习时,切勿使用高级能力进行解释。

捷径学习需要我们改变基准测量的方式

从历史上看,机器学习研究主要由基准驱动,基准测试通过在任务和数据集的固定组合上对算法进行评估,使算法具有可比性。这种模式在很短的时间内就引领了该领域的巨大进步。但这并非没有缺点。一方面,它为研究人员提供了强大的动力,使其可以将精力更多地集中在改进现有基准的新颖算法的开发上,而不是了解他们的算法或基准。然而,这种对理解的忽视,恰恰让是让捷径学习成为深度学习中普遍存在问题的部分原因。

让我们看一个著名的例子:ImageNet 数据集和挑战赛创建于2009年,作为一种新的衡量对象识别进度、算法识别和分类对象能力的方法。由于ImageNet规模巨大,它本身是一个未解决的问题,没人胆敢挑战。它的多样性和规模为当前的深度学习革命铺平了道路。Krizhevsky等人2012年的论文和挑战赛的耀眼成绩证明了具有学习权重的深层神经网络可以用独特的方式处理这种复杂性(而不是当时普遍的手工调整图像分析方法)。在接下来的几年中,ImageNet成为ImageNet基准测试进步和性能提升的推动力,成为计算机视觉进步的代名词。

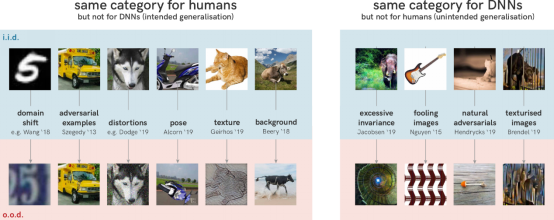

直到最近几年,随着越来越多的DNN失效案例的出现,这种情况才开始慢慢改变。所有这些失效案例背后的一个主要原因是,尽管ImageNet具有规模和多样性,但它并不需要真正的对象识别,从某种意义上说,模型必须正确地识别和分类我们用作标签的前景对象。相反,在许多情况下,对象的背景、纹理或其他对人类不太明显的捷径可以很好地被识别。如果比场景中的主要对象更容易识别背景,网络通常会学习利用这一点进行分类。

这种行为所引起的后果,是神经网络泛化能力的失败。下图左侧是人们期望模型进行泛化的几个方向。不管是手绘的黑白的还是彩色的门牌号,5都是5。同样,在姿态、纹理或背景上的轻微变形或变化也不会影响我们对图像中主要对象的预测。相比之下,DNN很容易被欺骗。有趣的是,这并不意味着DNN完全不能泛化:事实上,在对人类几乎没有意义的方向上,它们还是可以很好地泛化。下图的右侧显示了一些例子,从一些可理解的(置乱图像以仅保留其纹理)到完全不可理解。

导致捷径学习和随后的泛化失效的关键问题是我们对任务的理解与它实际上激发学习的模型之间的差异。我们如何减轻这个问题并提供对捷径学习的洞察力?当前大多数基准测试的主要缺点是,它们会测试训练集中相同数据分布的图像(iid测试)。这种类型的评估仅需要一种较弱的泛化形式。但是,我们需要强大的归纳能力,这些能力大致与我们的直觉相吻合。为了测试这些,我们需要良好的分布外测试(ood测试),这些测试应具有明显的分布变化,明确定义的预期解决方案,并提供模型学习捷径的节点。

但还不止于此:当模型变得越来越好时,它们会学习利用微妙的捷径,因此我们预测,基准测试也会越来越强。这种“滚动基准”可以确保我们在模型开发过程中不会失去对最初目标的跟踪,而会不断地将精力重新集中在解决我们真正关心的潜在问题上,同时加深我们对建模管道与模型之间相互作用的理解。

跨过捷径实现理解,该怎么做?

科学的目标就是理解。尽管深度学习作为一门工程学科在过去几年中取得了长足的进步,但深度理解作为一门科学学科,在理解控制机器学习如何从数据中提取模式的原理和局限性方面仍非常落后。更加深入地理解捷径学习不仅关乎当前机器学习的应用,未来还可能有助于跨学科研究,如与经济学(通过奖励意外的“捷径”行为来设计不会危及长期成功的管理激励措施)、法律(创建没有“漏洞”捷径机会的法律)交叉融合的机会。但是,必须指出,我们可能永远不会完全解决捷径学习。模型始终以减少的信息为基础来做出决策,因此泛化失败不可避免:受捷径学习影响而失败将会是常态,而不是意外。为了深入理解捷径学习,或减轻它的影响,我们有五个建议:

(1)连接点:捷径学习无处不在

捷径学习似乎是生物学和人工学习系统的普遍特征。深度学习中的许多问题都与捷径学习有关——模型利用数据集捷径机会,仅选择一些预测特征而不是仔细考虑所有可用证据,因此因各种原因失败。受影响区域之间的“连接点”很可能会促进发展,并且在各个应用场景中产生极有价值的影响。

(2)认真解读结果

发现捷径通常意味着,一个看似复杂的数据集可以用简单的方案解决。我们认为,在将诸如“对象识别”或“语言理解”之类的高级功能归因于机器之前,我们需要格外小心,因为通常会有更简单的解释。

(3)测试分布外的泛化表现

评估iid测试数据的模型性能(就像当前大多数基准测试一样)不足以区分预期的和意外的(捷径)解决方案。因此,分布外的测试是必须要做的。

(4)了解是什么让解决方案易于学习

DNN总是学习最简单的问题解决方案,但是要了解哪种解决方案更简单(从而容易学习),则需要弄清结构(体系结构)、经验(训练数据)、目标(损失函数)和学习(优化)的影响,以及对这些因素之间相互作用的透彻理解。

(5)首先弄清楚是否真的要解决这个问题

捷径的存在意味着,无论任务是否得到充分证实,DNN都会找到解决方案。例如,系统可能试图根据敏感的人口统计学(例如肤色或种族)或仅根据外表,用捷径来评估信用分数。这很令人担忧,因为当将机器学习用于不明确或有害的任务时,可能会强化错误的假设和有问题的关联。捷径方式可以使此类可疑任务看起来完美可解决。但是,DNN具有高性能处理任务或基准的能力永远无法证明任务的存在或潜在假设。因此,在评估一项任务是否可以解决时,我们首先需要问:是否真的要解决这个问题?如果答案是yes,、应该用AI来解决吗?

捷径学习是当前ML模型与人类智能之间最具标志性的差异。但具有讽刺意味的是,正是这种对“作弊”的偏爱,使神经网络看起来几乎和人类又相像了几分:谁还没有过在考试前偷懒背材料,而不是花时间去真正理解的经历?谁从来没有试图在一项法规中寻找漏洞,而不是坚持法律的精神?最后,神经网络也许和(懒惰的)人类并没有什么不同……

本观点基于以下论文:

Geirhos,R.,Jacobsen,JH,Michaelis,C.,Zemel,R.,Brendel,W.,Bethge,M.&Wichmann,FA(2020)。深度神经网络中的快捷学习。arXiv预印本arXiv:2004.07780。

作者简介

Dr.Jörn-HenrikJacobsen,图宾根大学博士后,在阿姆斯特丹大学获得博士学位,研究广泛涉猎学习有用的含义和世界的通用表示形式,特别关注分布外的概括,无监督表示学习,稳定性保证和算法偏差。

Robert Geirhos,德国马克斯·普朗克国际智能系统研究学院的博士,获得蒂宾根大学计算机科学专业硕士学位,专注于人类和计算机视觉研究。

Claudio Michaelis,国际马克斯·普朗克智能系统研究学院博士,获康斯坦茨大学硕士学位,兴趣领域为理解人工神经网络。

原文链接:

https://thegradient.pub/shortcuts-neural-networks-love-to-cheat/