我们正站在神经网络的十字路口

但从个人角度,我还是喜欢这样安静的 AI 界,我们离强人工智能还很远,在深度学习的理论研究上还处于婴儿阶段,我希望无论是身处其中的研究人员,还是满怀期待的观众都能认清这个现实。

更多干货内容请关注微信公众号“AI 前线”,(ID:ai-front)

距离 2012 年 AlexNet 提出引起深度学习的火热已经过去了六年。在这六年里,该领域取得的成果有目共睹:

在架构上,ResNet、Inception、DenseNet 等极大拓展了深度学习的特征提取能力;

在提高收敛速度上,Batch Normalization、Group Normalization,还有最近的 Switchable Normalization 的提出,加快了神经网络的收敛速度;

在网络泛化上,Dropout 的提出让我们在加噪声和设计 loss 函数惩罚项之外又多了个选择;

在强化学习领域,Deep Q Learning 和 AlphaGo 为我们展现了人工智能超越人类的可能;

在应用落地上,计算机视觉和自然语言处理领域诞生了成百上千的创业公司;

在更大的方向上,GAN 的诞生,使其成为 CNN 以后,神经网络领域最有意思的一个分支,当然,与此同时我们还放出了对抗样本这个“幽灵”。

但时至今日,我们对“智能”的定义依然模糊。 有人说,像人一样思考的就是智能。但是,人究竟是怎样思考的,我们至今也没有准确的答案。

曾经有一段时间,我非常着迷于“意识”这个东西,按照我当时天真的想法,通过生物神经科学领域对意识衡量的启发,来建立一个对人工神经网络“意识”的衡量机制,如果我们可以写出“意识”的损失函数,就能确定我们的模型有没有真的像人一样在思考。很显然,当时的我完全是一个生物神经科学方面的白痴(现在也是)。

后来,通过粗略浏览几篇生物神经领域的论文,并跟几位认知神经学方面的博士进行了相关交流,我发现一个很有意思的现象:生物学上对神经科学的研究几乎都是基于行为的。比如,前段时间有篇很火的 RNA 跟记忆相关的研究,就是观察海兔对电击的反应来论证记忆有可能是存储在 RNA 中的(一般理论认为,记忆是分布存储于神经元的链接中的)。这儿我们不掺和记忆的存储的问题,尽管这个问题非常重要,无论是对于生物神经学还是人工神经网络。

我当时在思考的是,智能的行为跟“智能”是如何映射的?如果一个智能体行为是智能的,是否可以说它本身就是智能的?按照当前人们对人工智能的要求,答案显然是“不可以”。 比如 AlphaGo 在棋类游戏上独孤求败,但是没人会觉得他能像人一样思考所有的事情。我们在通过行为去研究智能的时候,将会不可避免地陷入繁复的细节和对智能认知的片面中,因为“智能的行为”只是智能的一个表征,意识也是。

目前,在很多领域都有属于自己的“大统一理论”: 在物理学领域,弦理论可能是最有野心、也是最有希望的大统一理论;在数学领域,朗兰兹纲领联系了基础数学的数论、几何和表示论,被看作是数学的大统一理论;而在神经科学领域也有这样的理论,预测性编码(predictive coding)是我最感兴趣的一种。

预测性编码的基本假设早在 19 世纪中期就由德国物理学家、心理学家 Hermann von Helmholtz,以及哲学家 Immanuel Kant 提出。

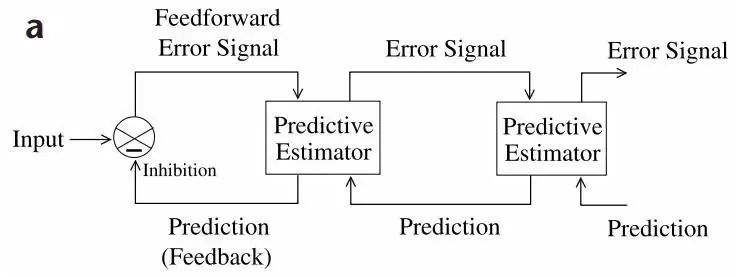

1999 年,Rao RP 在他的论文《Predictive codingin the visual cortex: a functional interpretation of some extra-classicalreceptive-field effects》中揭示了视觉皮层使用的多层次、预测性的框架:初级视觉皮层产生对图像的小尺度特征预测,利用预测信息完善和匹配进入的视网膜的信息,当皮层感知到偏差时,要么更新皮层神经的连接使得偏差更小,要么将偏差看作误差不予理会。如果预测偏差过大,就把信息传给次级视觉皮层,进行同样的预测匹配,直到最高层。

可以看出,这个框架跟现在我们时常搭建的神经网络一样具有层级结构。

预测性编码的分级网络

美国工程院院士、神经学家 Jeff Hawkins 曾经在他的著作《On Intelligence》中提到类似的框架,并在 2005 年创立了 Numenta 公司,致力于实现框架。他们发布了 HierarchicalTemporal Memory 白皮书,每一个人都可以根据框架结构去实现自己的算法。然而 Numenta 和 HTM 至今仍处于不温不火的状态中,倒是联合创始人之一 Dileep George 出走以后创建的 Vicarious 去年在《Science》搞了个皮层网络的大新闻。

《On Intelligence》中提出的几个神经网络相关的问题,我们至今也没有解决: 人脑中存在大量的反馈链接(feedback connections)是干嘛用的?人工神经网络如何才能像大脑一样学习 Cross-Media 的数据,从而成为一个万用机器?大脑皮层里大量的横向连接如何在现代神经计算架构中体现?

我们时常忽略一个很重要的问题:现在的数据集是否能够支持强人工智能的诞生?ImageNet 上的数据量虽然大,但是相对于我们从婴儿时期眼睛不断接收的信息来说还是太少了,而且有个非常致命的问题,我们人类即使在观察一张静态的图片的时候,由于“眼跳”机制的存在,每时每刻进入我们大脑的信息其实都是“序列”化的,只是我们的大脑能够在这个序列中把这段信息整合成当前这张静态的图片。数据集是一个神经网络的灵魂,那么,在数据集上的不完善是否意味着我们在探索智能的整个方向上都走错了?

从人本身来看,无论是眼睛(视觉)、耳朵(听觉)、鼻子(嗅觉)、皮肤(触觉)还是舌头(味觉),这些身体传感器接收的信息都是序列化的,单一的数据甚至无法引起我们的注意:这儿可以联想下闭眼用手摩挲物体不断建立认知或者耳朵仔细在一段噪声中寻找自己熟悉的旋律的过程。我们从世界接收的信息本身就是序列化的,这也是我对现代传感器数据(手机传感器、雷达数据等)非常感兴趣并一直在这个领域研究的原因之一。

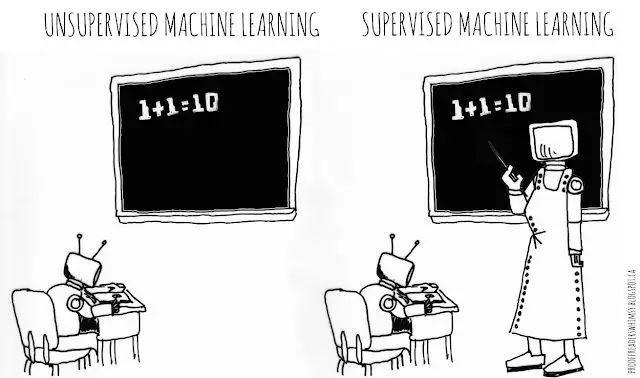

我们从婴儿时期开始,人生中贯穿了两个学习的过程,即无监督学习和有监督学习:

无监督学习。我们用身体的“传感器”观察着这个世界,发现这个世界的模式,这个世界显然是结构化的,可学习的(如果是无规律的噪声,显然是不可学习的):音乐是音符组成的,房子是砖块累积而成的,单词是字母的序列,句子又是单词的序列,而我们的思想,如果想传授出去,很多时候需要句子序列的组织,我们在日复一日的无监督学习里发现了这个世界的模式,并成为这个模式的一部分,将信息加工传递出去。

有监督学习。父母会在我们的婴儿时期,就在特定的场景反复培训我们重复对应的单词,老师会教我们抽象的符号、高级的语言表达和艺术的加工,这些都是人类几千年来知识不断抽象化的积淀,我们可以不用再去花大量时间无监督地“领悟”其中的模式,人类也通过这种模式不断超越当前的时代。

我们现在正在研究一种新的神经框架,不同于现代神经网络单一的前馈 + 反向传播的训练方式, 在这个新的网络里:

时间流数据作为输入;

每一层都存在反馈链接作为当前层输入的预测进行修正,网络结构应该是处处一样的,即,不断地整合低层输入;

预测即根据现有信息自联想产生预测,期待低层传入信息跟预测“重合”,如果预测出现偏差就向更高层传递,若无偏差,那么当前层即可解决预测问题;

存在联合区域,用来整合不同感官或者叫传感器间的“语义”关联;

存在两种训练方式,时间上连续发生的归位“一组”的无监督学习,或者监督学习;

学习的过程是由高层向底层传递的过程;

注意力机制由底层传来的“预测错误”,和高层的直接干预形成;底层网络能够被高层主动激活,高层网络可以受底层网络影响被动激活;

引入类似 Hinton 的 capsule 结构来模拟皮层中 microcolumn。

让我们用一个例子来通俗地解释一下这个新型网络的工作方式: 我正在放学回家的路上。我对这条路很熟悉。我经常边走边思考问题。大多数时候,我甚至没有意识到自己在走路、在呼吸。因为这个时候,我大脑皮层的低层神经网络正在不断预测当前情况,而高层的神经网络正在进行其他问题的思考。但是,当我突然听到有人叫我的名字,或者踩到路上的一个小坑,或者突然感到呼吸不畅时,我当前的想法就会被打断。

这意味着低层神经网络预测出现偏差,不能处理当前的情况。在这种情况下,低层网络只能将信息传递给上层神经网络进行处理,高层可以传输到更高层,直到当前情况得到解决。

当然,我们所有人都可以通过这个框架去验证生活中的情形,会有意想不到的乐趣。比如人群中的一个美女或者帅哥是如何突然吸引我们的注意力让我们精神一振的……

有人会对“学习的过程是高层向底层传递的过程”感到迷惑,这儿可以尝试联想我们在计算机中录入字符的学习。刚开始的时候,我们需要视觉 + 触觉 + 运动控制同时进行来慢慢地打字录入字符,我们甚至需要努力搜索回忆某个字母在键盘的哪个区域(我就在小时候被我的父亲逼着背过五笔输入法的偏旁部首在每个按键上分布),这儿显然我们需要高层神经网络的参与才能进行。到了后期,我们的底层神经网络预测越来越准确,甚至我们不需要刻意地注意打字,照样可以边思考边打字,高层脑区联想的句子会自动转化成肌肉信号。

这个框架可以解释很多问题,不仅是日常的行为,甚至还包括人类的自闭症等病症,相对于拥有普通神经系统的人,他们有被频繁惊奇的倾向,为什么会有惊奇的倾向,相信读到这儿的你会有自己的总结。

这个新架构也是目前 SecID 无感行为认证的未来主要研究方向之一, 原谅我不能把结构图给出以详细阐述技术细节。项目进展顺利的话,相信不久以后,大家就能看到我们的论文。

SecID 认为未来世界是传感器的世界,并早就为此布局:

生物特征易于被窃取、仿造和破解,但是基于传感器的行为特征不会,我们正在利用神经网络分析行为特征并作为用户的唯一 ID;

层级预测框架天生就适应自动驾驶、天气预报、电网分布预测等现实需求;

受到人类本身“传感器”(眼睛、鼻子、耳朵等器官)的限制,未来的多传感器的数据分析必然需要 AI 的介入,一个比人类看得更远、听得更细、灵敏度更高的 AI 能对我们的生活带来非常巨大的改变;

在这个框架中引入关系推理和符号推理同样是我们的目标之一,这也是通向强人工智能的必由之路。

以上就是我们对于现代人工神经网络方向上的一些见解和应对。

本来还想写一部分神经网络的数学理论问题,这也是我的博士方向,但是这个方向上现在的研究才刚刚起步。在理论上,我们需要研究的东西太多了:神经网络为什么能够工作?为什么不会过拟合?神经网络的 loss surface 有哪些特性,可以用什么方法去研究?神经网络的鲁棒性问题如何解决?神经网络的结构为什么是这个样子不是那个样子的,结构的选择上应该遵循什么标准?神经网络的泛化问题?高度非凸的模型如何优化?

这些问题都有待解决,我们对神经网络的认知大概也就比“一无所知”好了一点。希望我们以后也能在这个方向上给出自己的成果。

写完发现我取的题目的名字太大了,类皮层的结构和神经网络理论是我个人最喜欢研究的两个领域。除了这两个领域,神经网络中现在还有太多未知的东西,在当前神经网络的十字路口,每条路都值得我们去探索。

现在还不存在伦理或者“人工智能造反”的禁区,希望每一个研究者都能在自己的方向上坚定踏实地走下去。Baseline 是刷不到头的,多思考才有收获。

无论 AI 是不是风口,希望身处其中的每个人都可以记得最初对于人工神经网络的一腔热情,并保持下去。我想用希尔伯特退休时演讲的六个单词结束这篇文章,Wir müssen wissen, wir werden wissen(我们必须知道,我们必将知道)。

参考:

[1] RNA from Trained Aplysia CanInduce an Epigenetic Engram for Long-Term Sensitization in Untrained Aplysia

[2] https://neu-reality.com/2018/04/02/autism-prediction/

[3] Predictive coding in the visualcortex: a functional interpretation of some extra-classical receptive-fieldeffects

[4] On Intelligence, [美]Jeff Hawkins

[5] Temporal Memory Algorithms

[6] Dynamic Routing BetweenCapsules

如果你喜欢这篇文章,或希望看到更多类似优质报道,记得给我留言和点赞哦!