医疗中的自动机器学习和可解释性

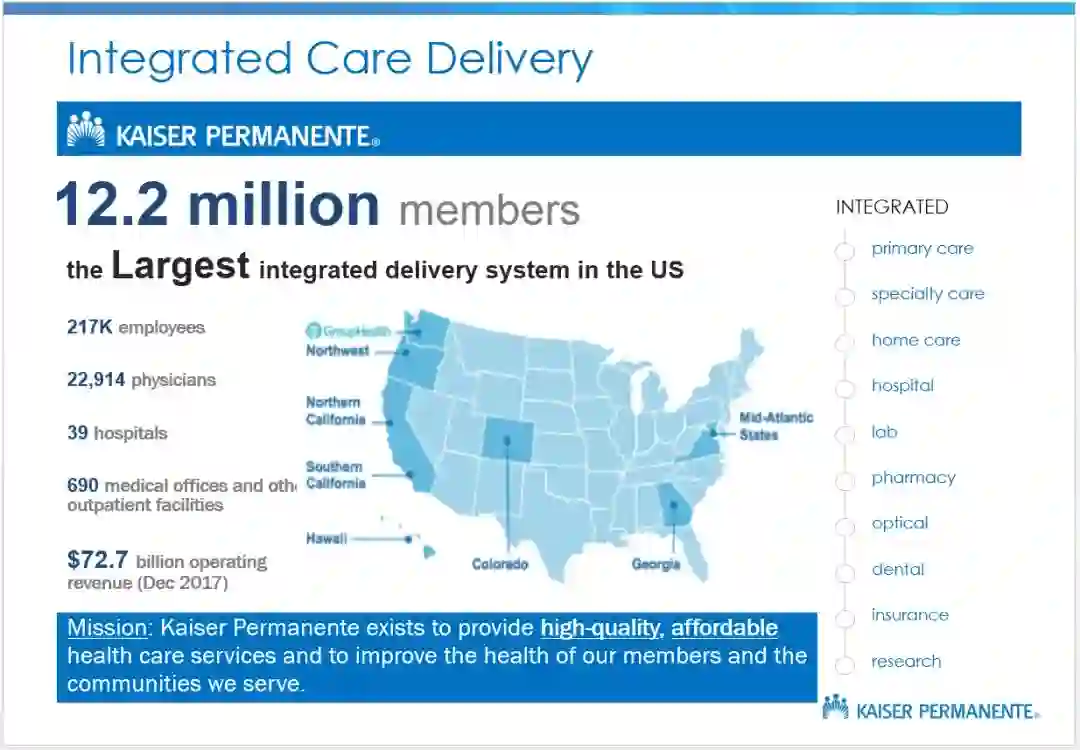

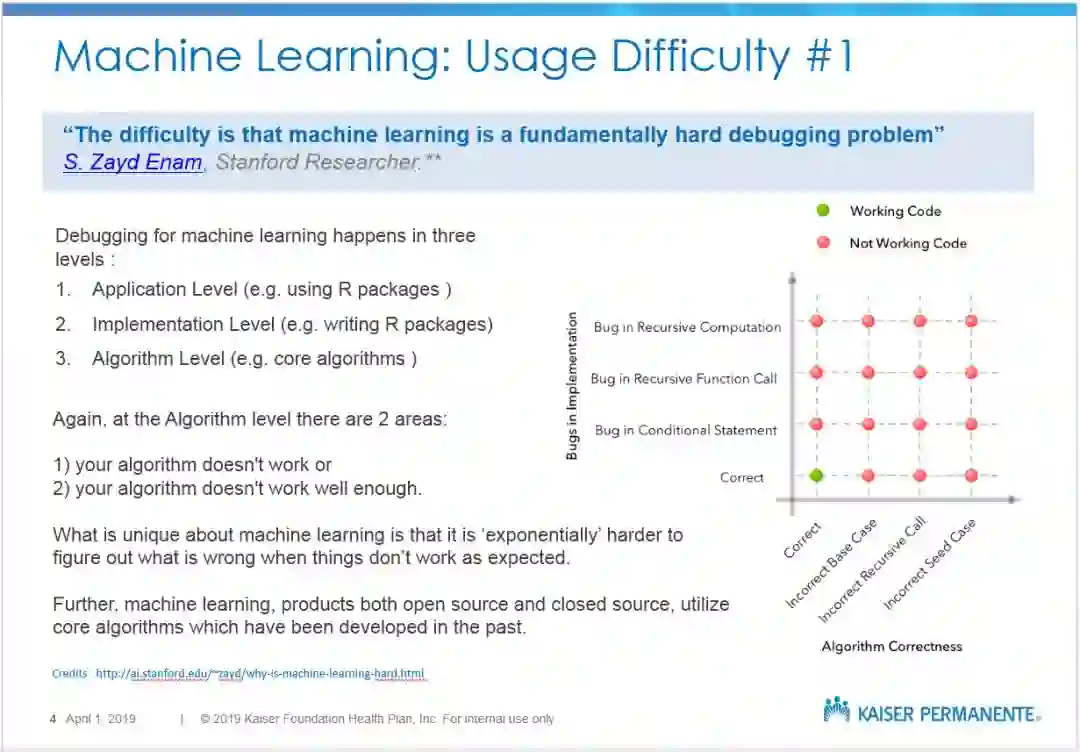

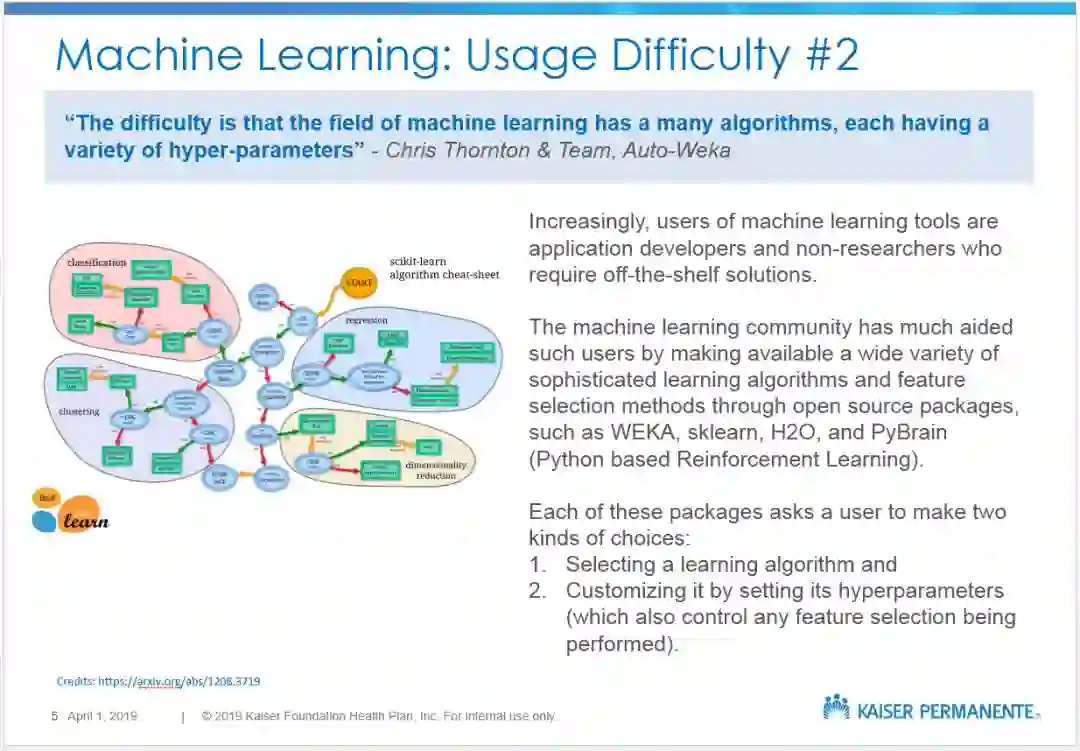

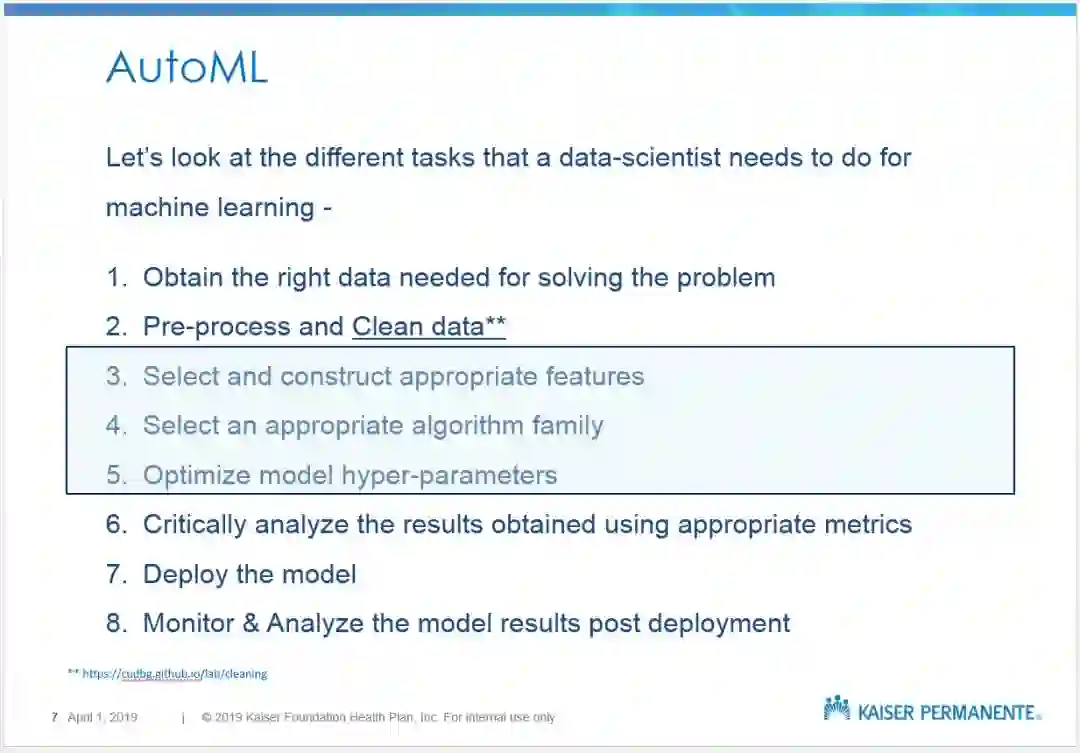

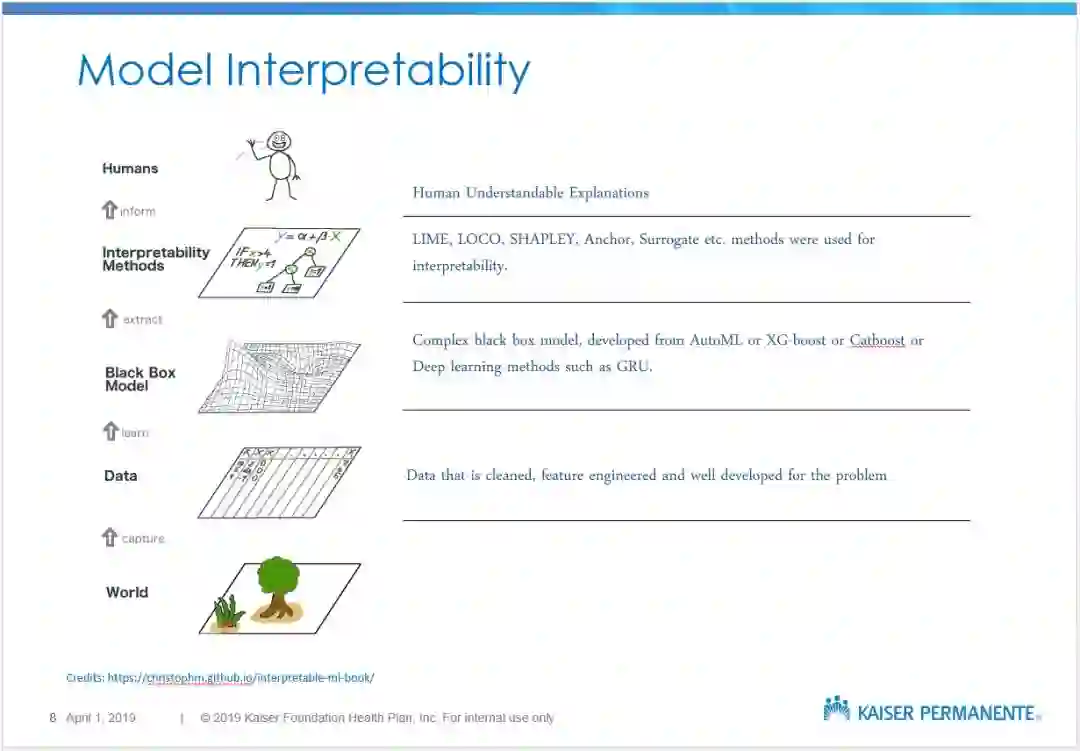

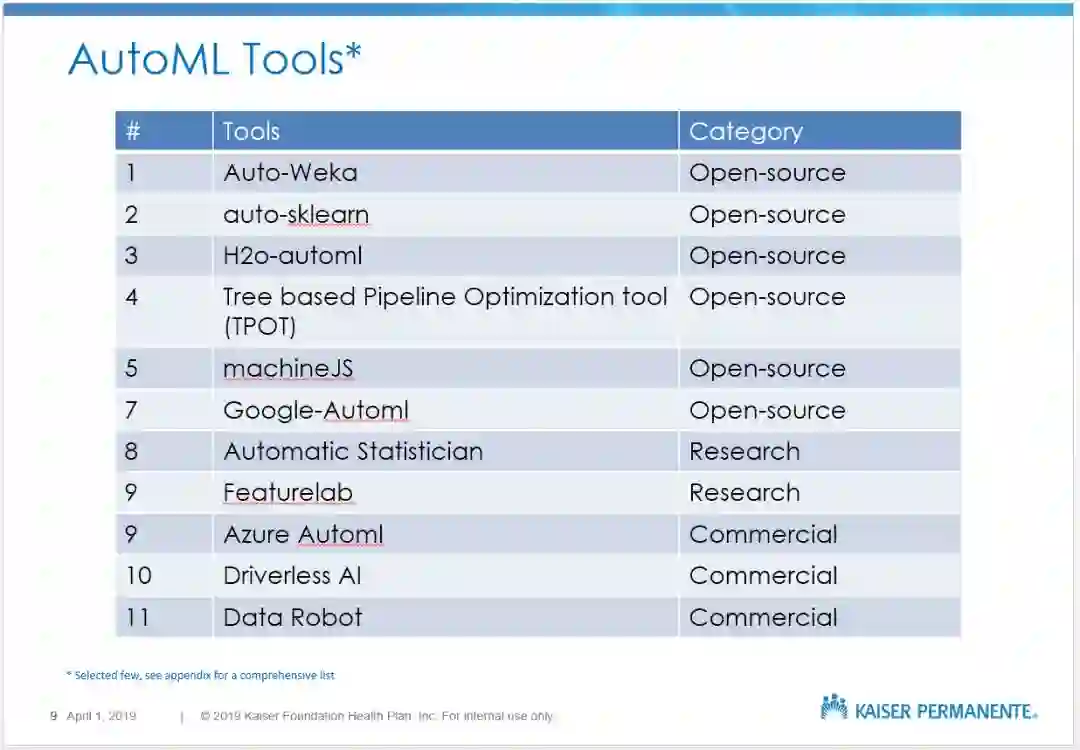

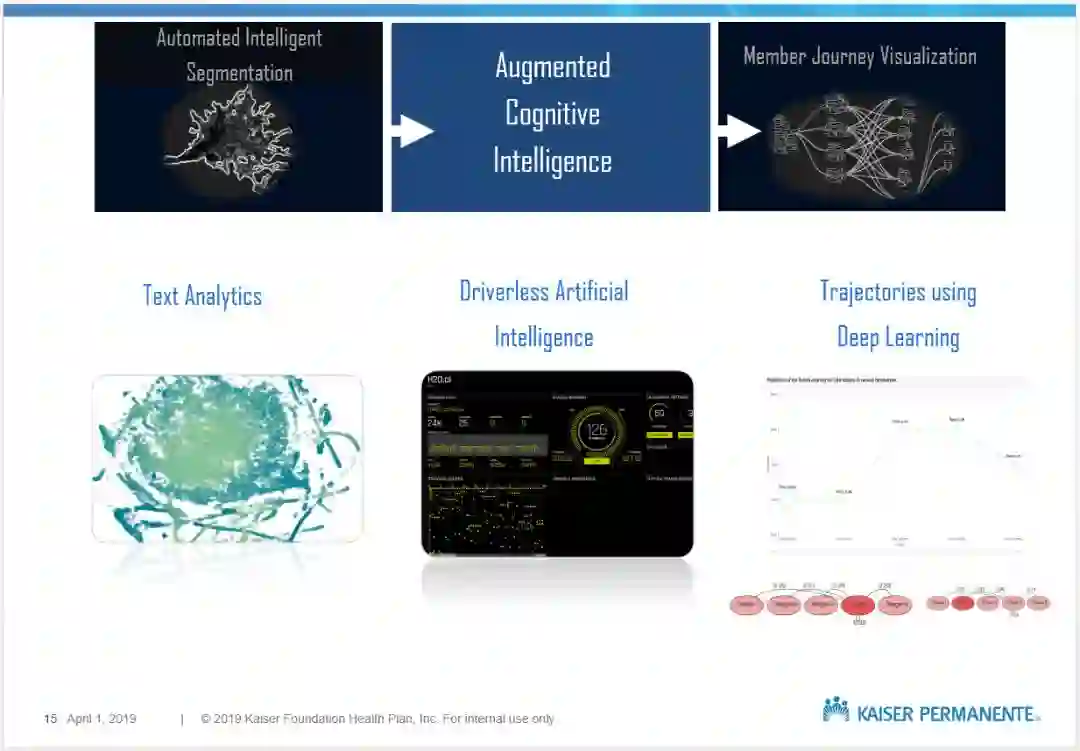

医疗保健行业需要精确和高度可解释的模型。根据医疗保健的应用领域(临床和操作),这些模型可以从预测到分割和聚类到分类和回归,包括自然语言处理(NLP)和图像处理等领域。然而,数据往往会受到信息缺失和值错误的困扰,因此数据准备和建立一个具有可解释性的模型都是一项耗费时间的任务。

作者 | Taposh DuttaRoy、Sabrina Dahlren

编译 | Xiaowen

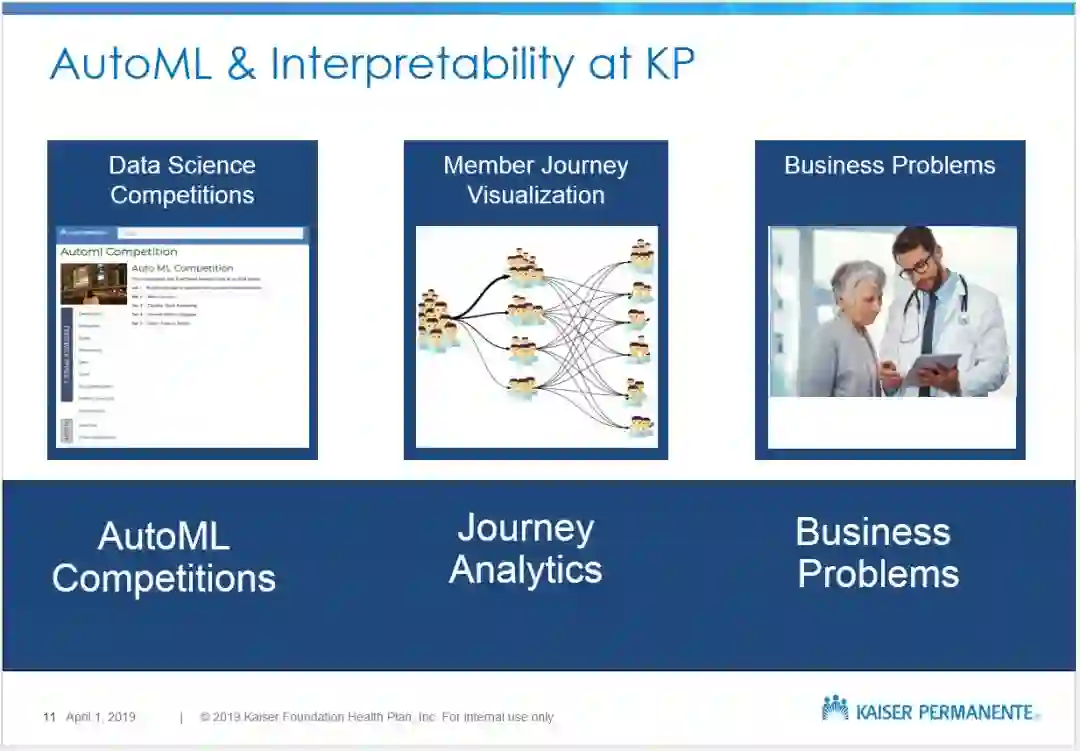

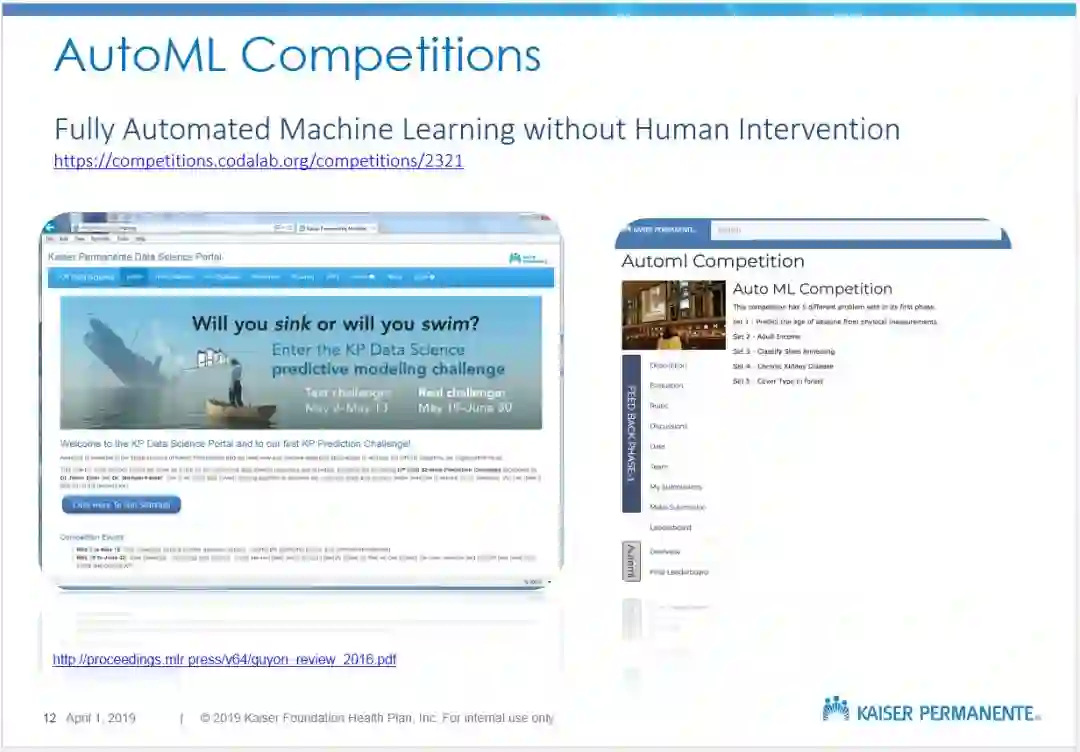

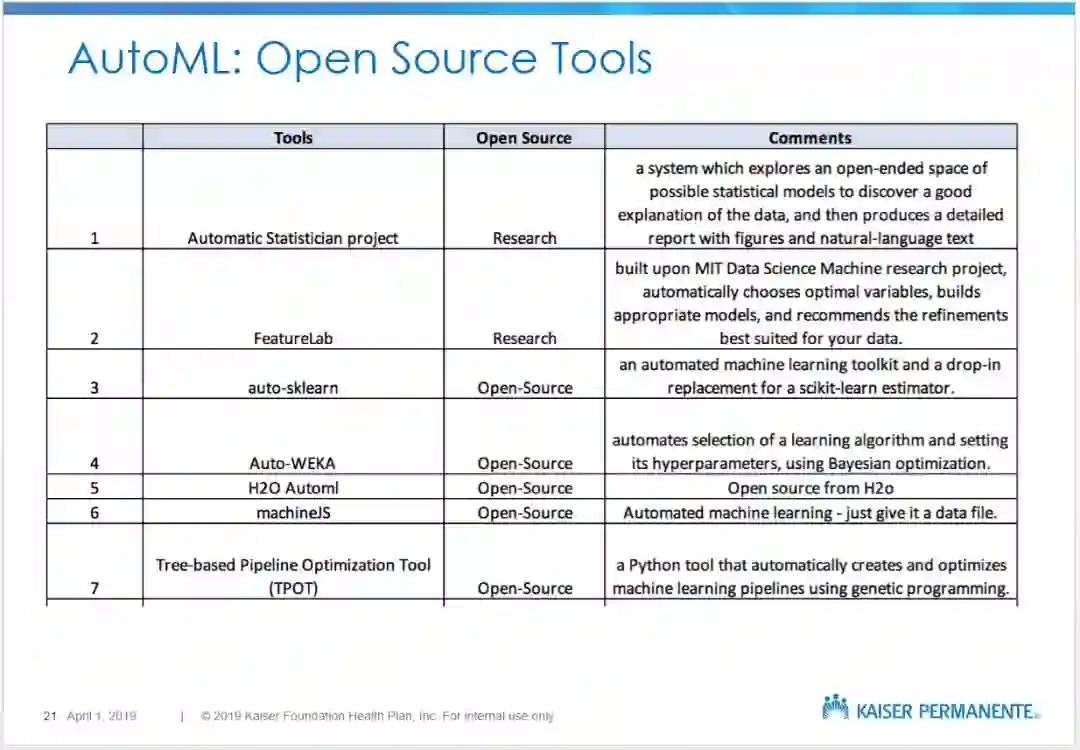

Taposh DuttaRoy和Sabrina Dahlgren讨论AutoML和可解释性的工具和策略,并解释Kaiser Permanente公司如何使用它们来改进开发和部署高度可解释模型。

1

作者介绍

Taposh DuttaRoy

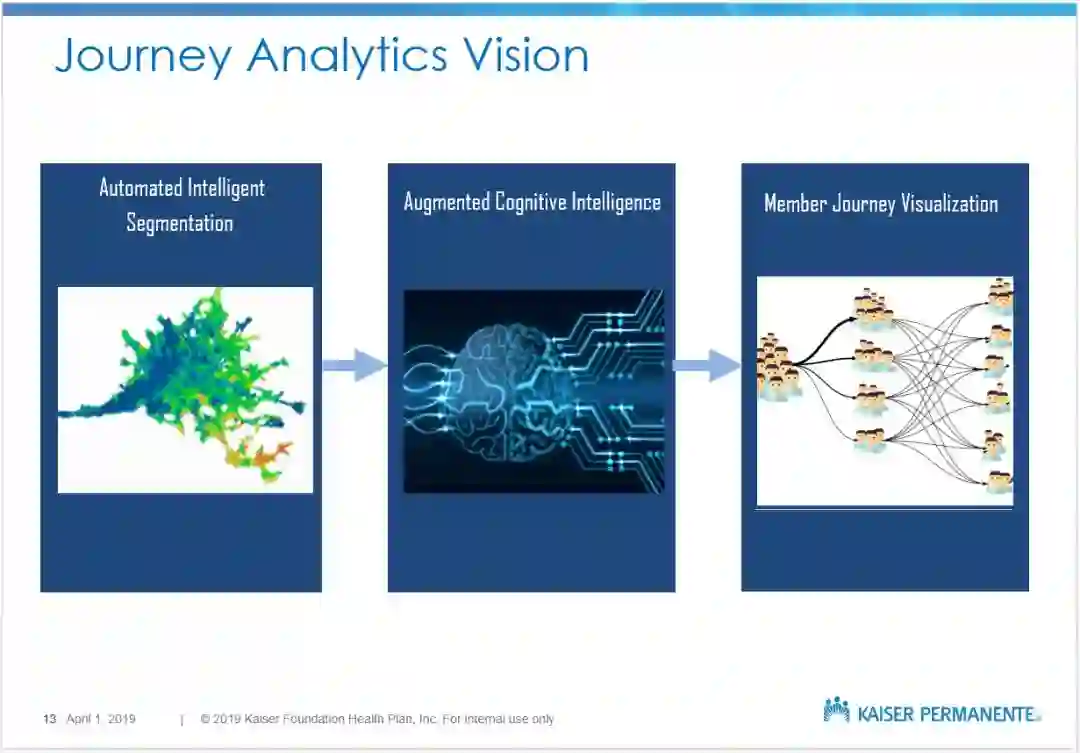

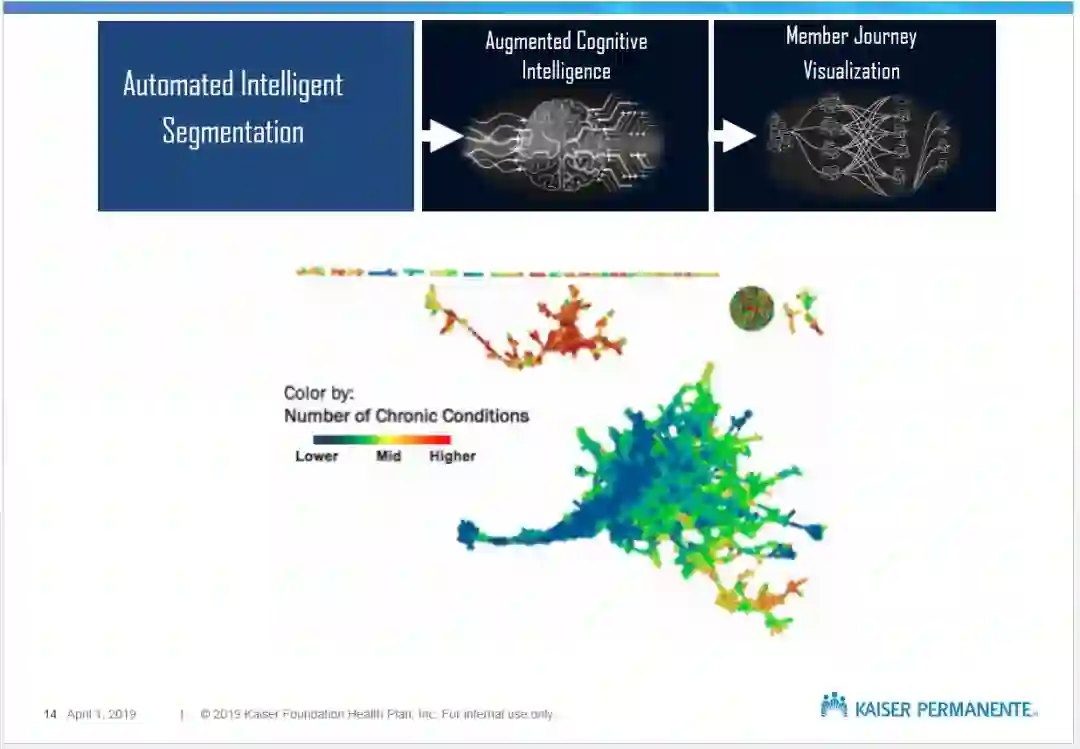

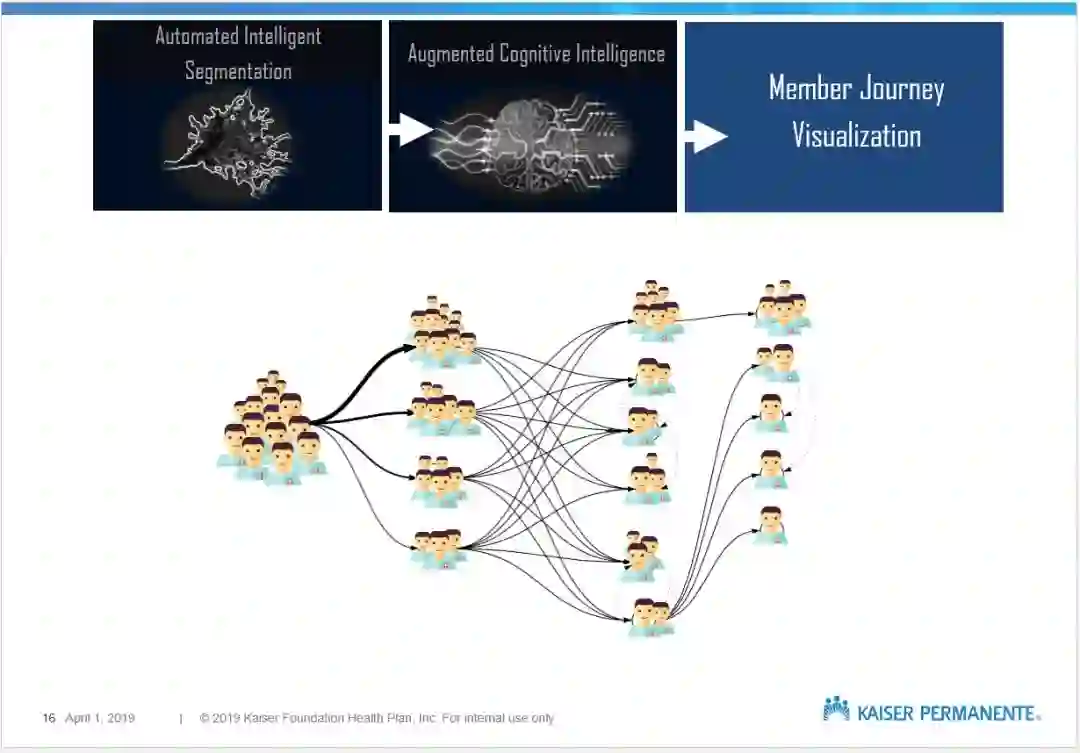

Taposh DuttaRoy 领导 Kaiser Permanente 决策支持小组内的创新团队。他的工作重点是旅程分析,深度学习,数据科学架构和战略。Taposh是一个以消费者为中心的机器学习和数据科学极客,拥有独特的产品、技术和战略咨询、数据科学和创业经验的组合。

Sabrina Dahlgren

Sabrina Dahlren 是 Kaiser Permanente 公司负责战略分析的主管。她的专长从统计和经济学到项目管理和计算机科学。

Slides 分享

2

【Slides便捷下载】

请关注专知公众号(点击上方蓝色专知关注)

后台回复“医疗自动机器学习” 就可以获取《AutoML and Interpretablity in Healthcare》的下载链接~

-END-

专 · 知

专知《深度学习:算法到实战》课程全部完成!520+位同学在学习,现在报名,限时优惠!网易云课堂人工智能畅销榜首位!

欢迎微信扫一扫加入专知人工智能知识星球群,获取最新AI专业干货知识教程视频资料和与专家交流咨询!

请加专知小助手微信(扫一扫如下二维码添加),加入专知人工智能主题群,咨询《深度学习:算法到实战》课程,咨询技术商务合作~

请PC登录www.zhuanzhi.ai或者点击阅读原文,注册登录专知,获取更多AI知识资料!

点击“阅读原文”,了解报名专知《深度学习:算法到实战》课程