知识图谱在可解释人工智能中的作用,附81页ppt

导读

可解释性人工智能是AI领域当下最火的话题之一,其在许多AI产业领域,比如金融、医疗健康等作用至关重要。本文详解了可解释性人工智能的动机、定义、评估,以及知识图谱在可解释性人工智能中的作用。

编译 | Xiaowen

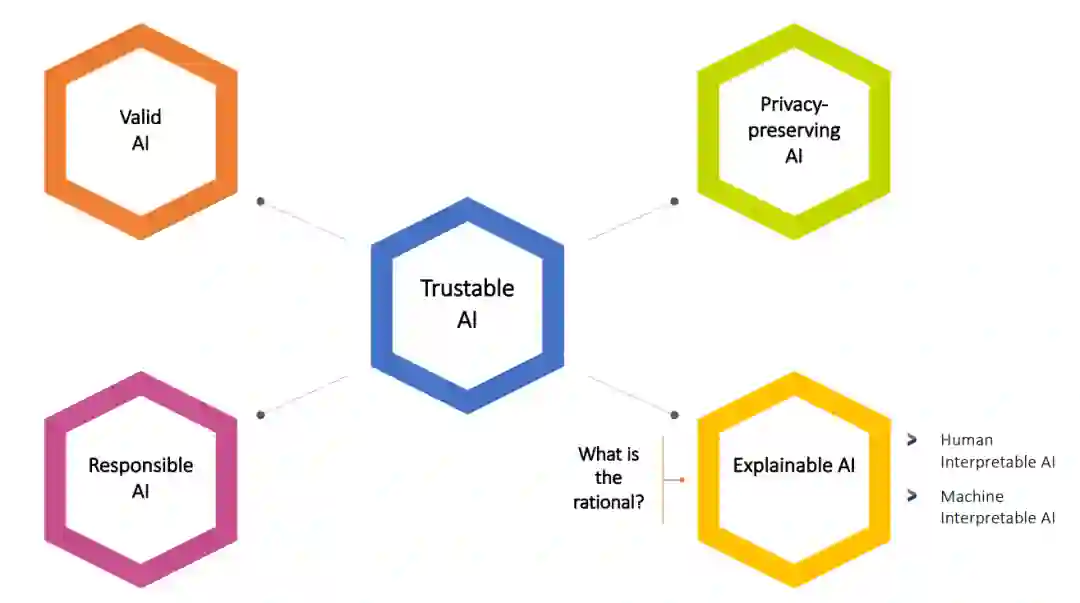

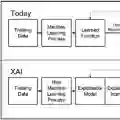

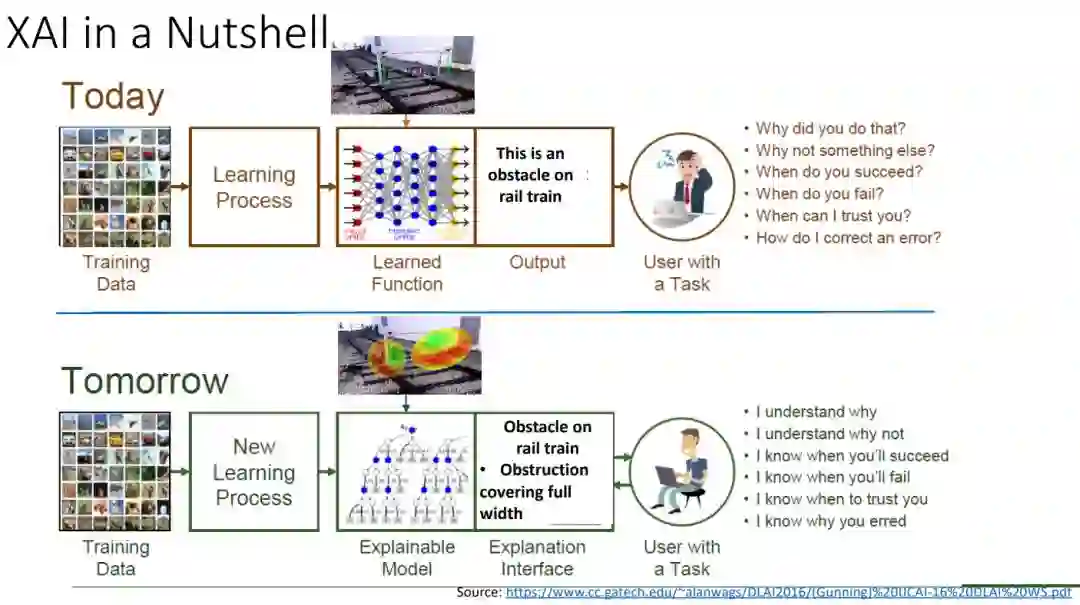

可解释人工智能的目标是创建一套能够产生更多解释模型的技术,同时保持高水平的搜索、学习、规划、推理性能:优化、准确、精确;以及使人类用户能够理解、适当地信任和有效地管理AI系统中出现的泛型。

目录

-

人工智能中的解释 -

动机 -

定义 -

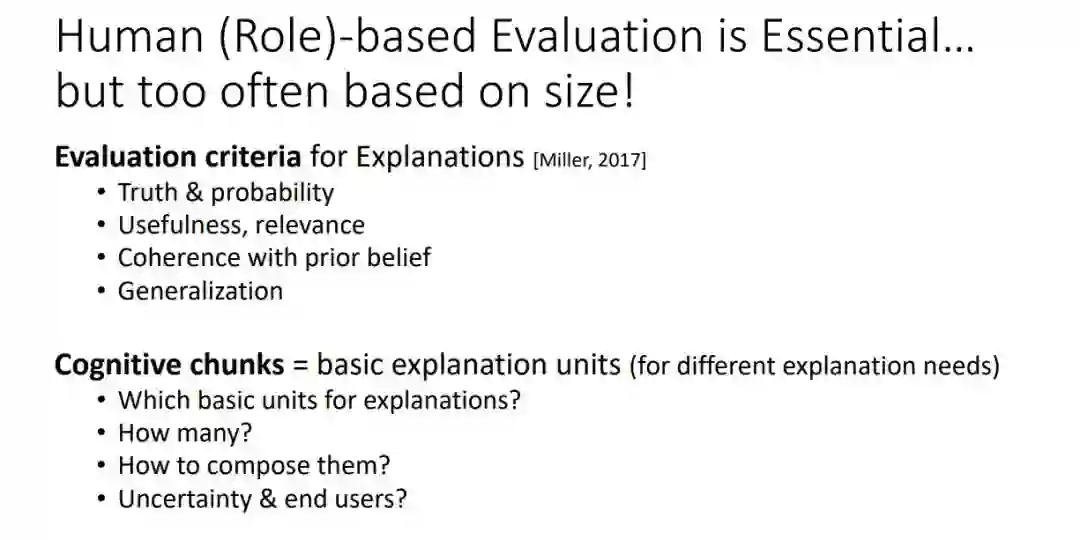

评估(以及人类在可解释性人工智能中的角色) -

人类作用 -

不同AI领域的解释性 -

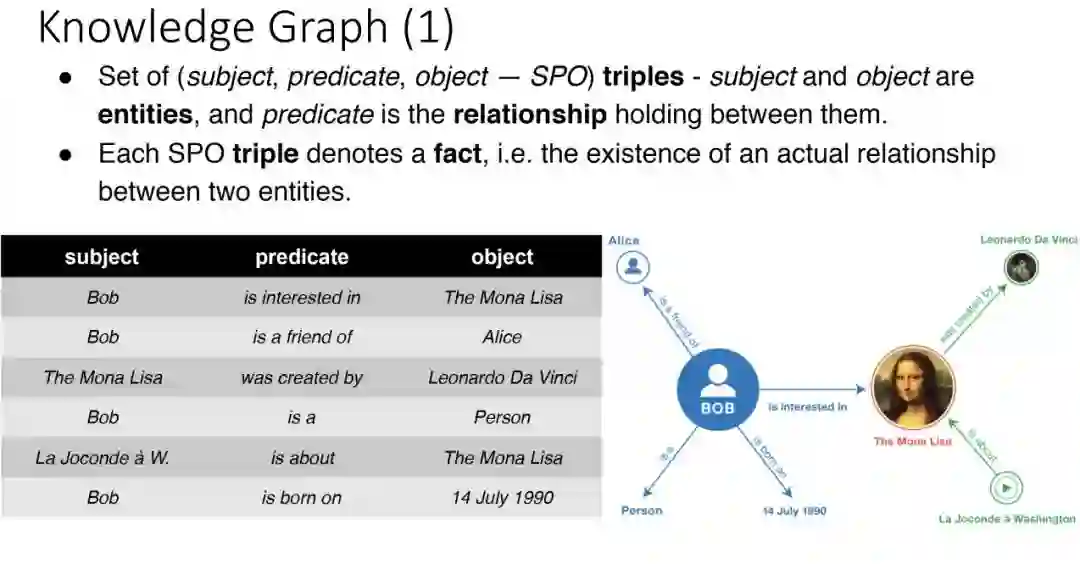

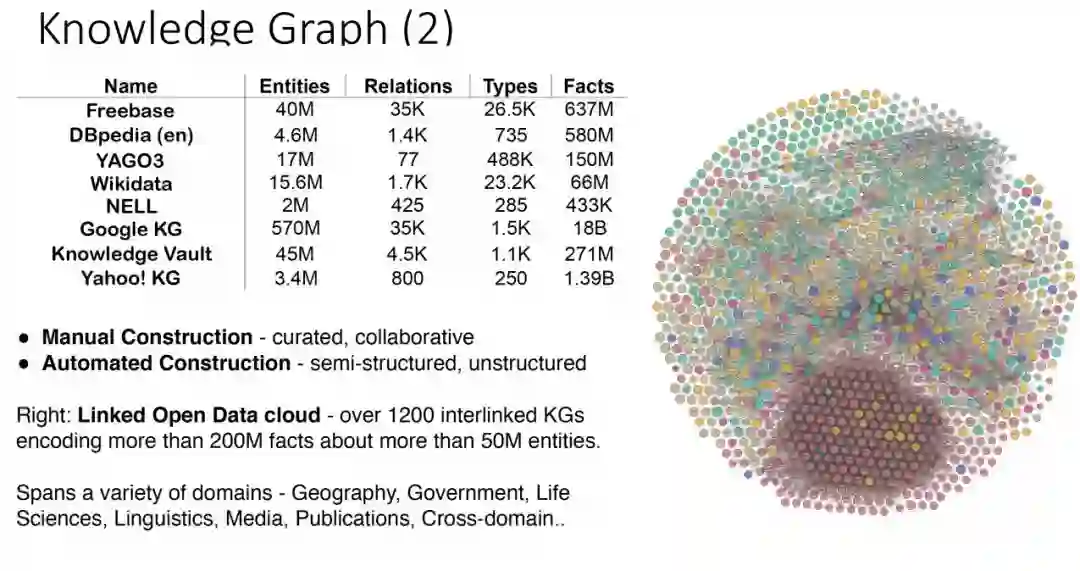

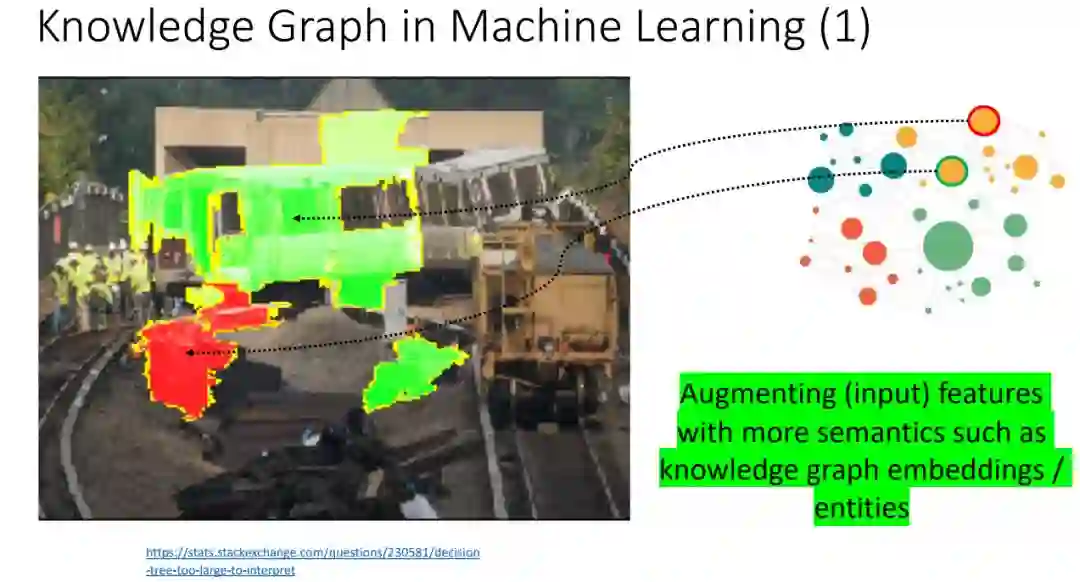

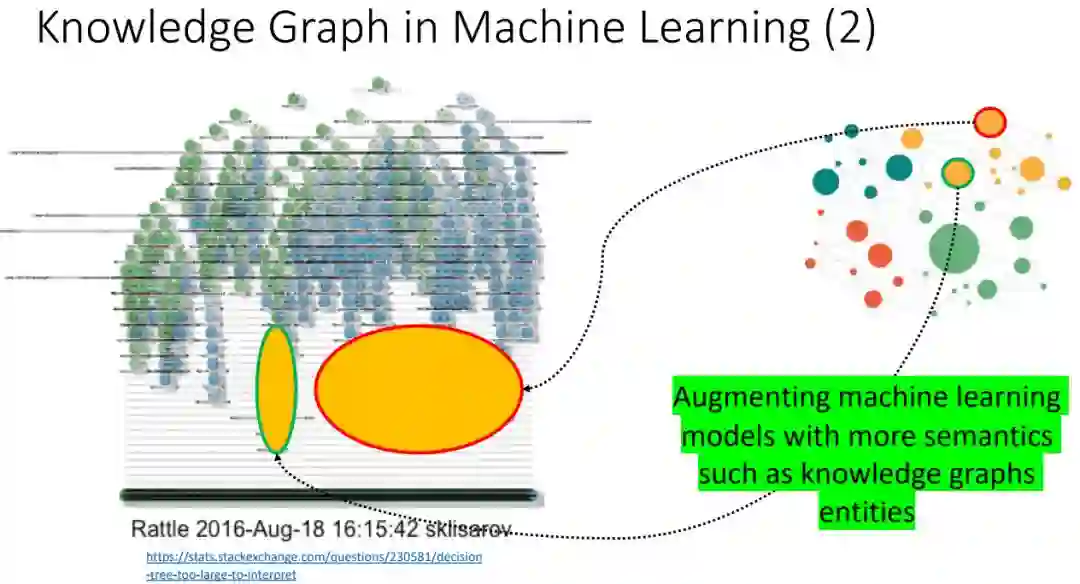

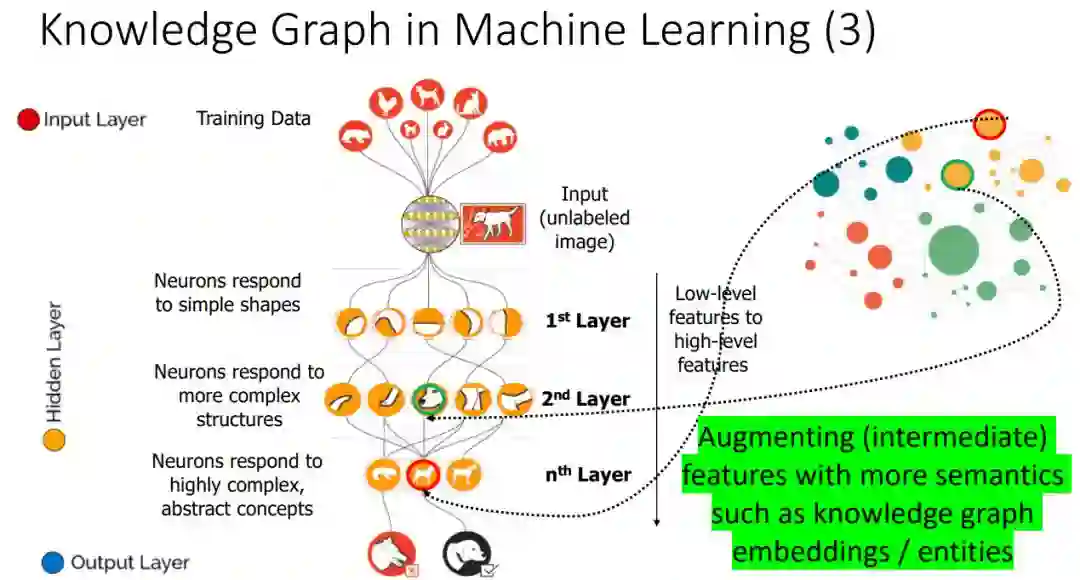

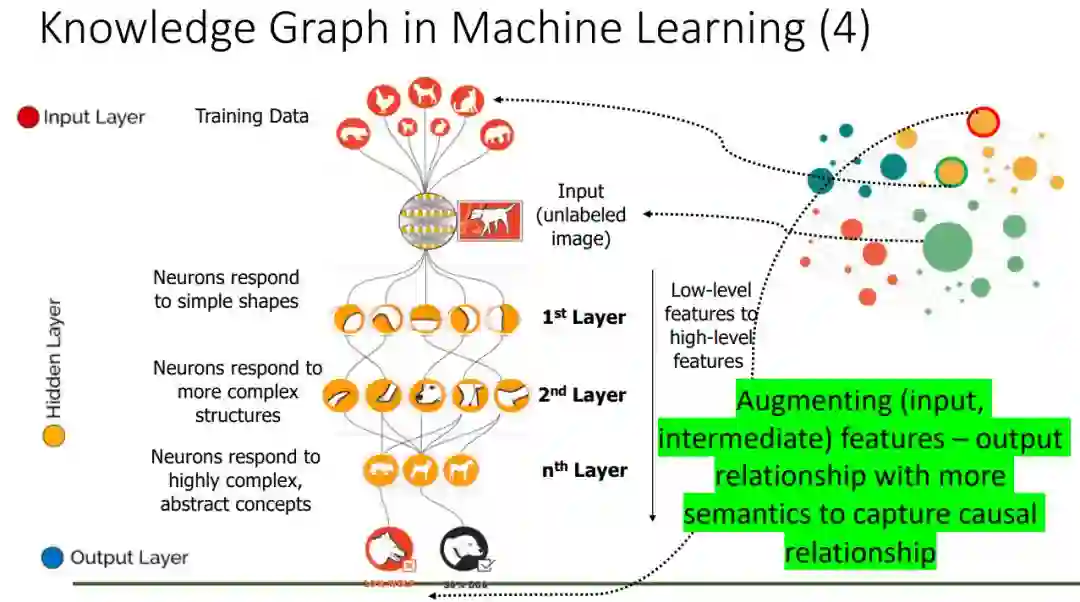

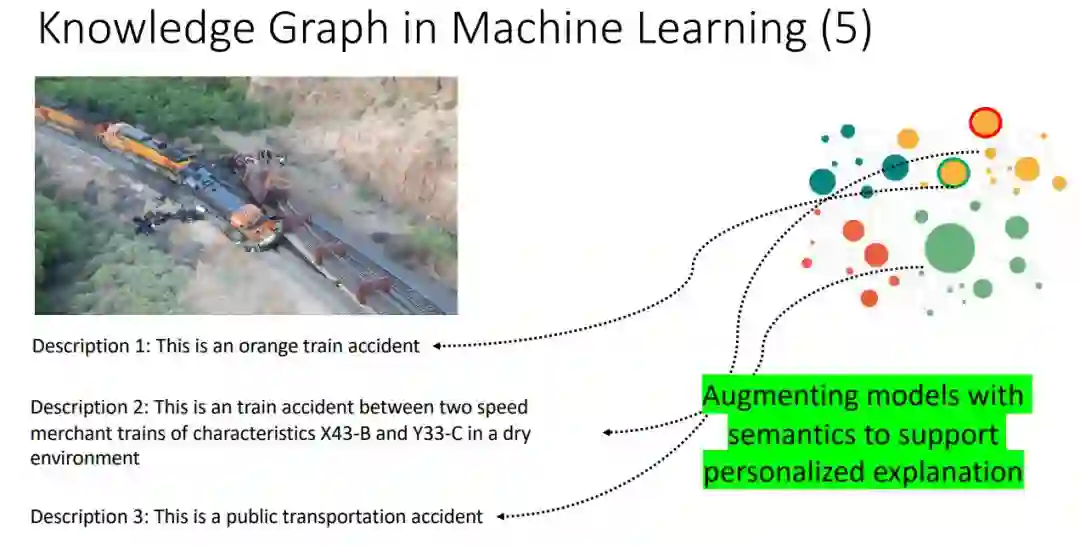

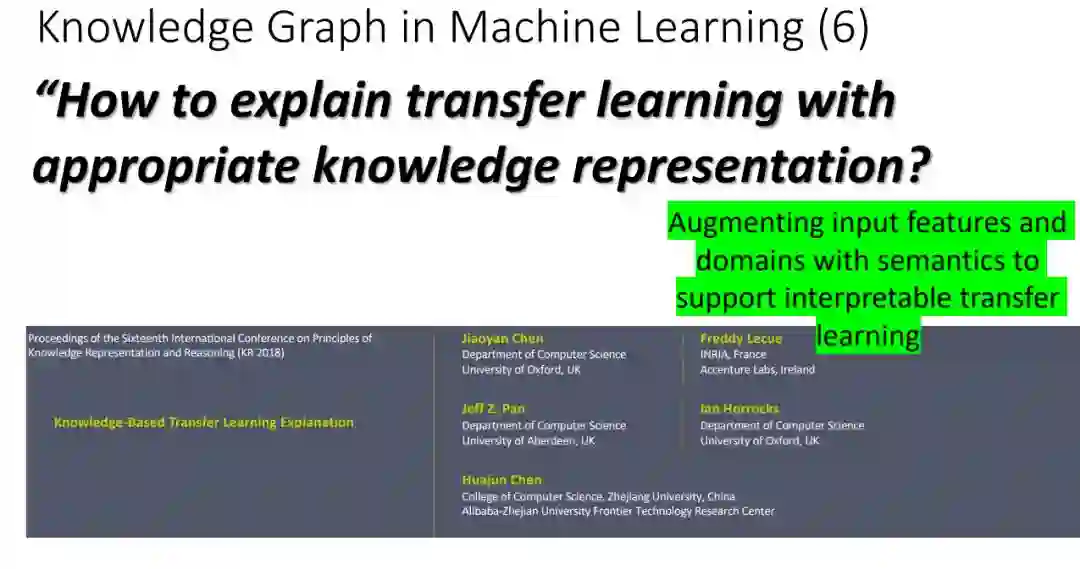

知识图谱在可解释性机器学习中的角色和作用 -

利用知识图谱在机器学习中的可解释性人工智能工业应用 -

结论

完整PPT下载:

请关注专知公众号(点击上方蓝色专知关注)

后台回复“KGinXAI” 就可以获取本文完整PPT下载链接~

完整PPT下载:

请关注专知公众号(点击上方蓝色专知关注)

后台回复“KGinXAI” 就可以获取本文完整PPT下载链接~

登录查看更多

相关内容

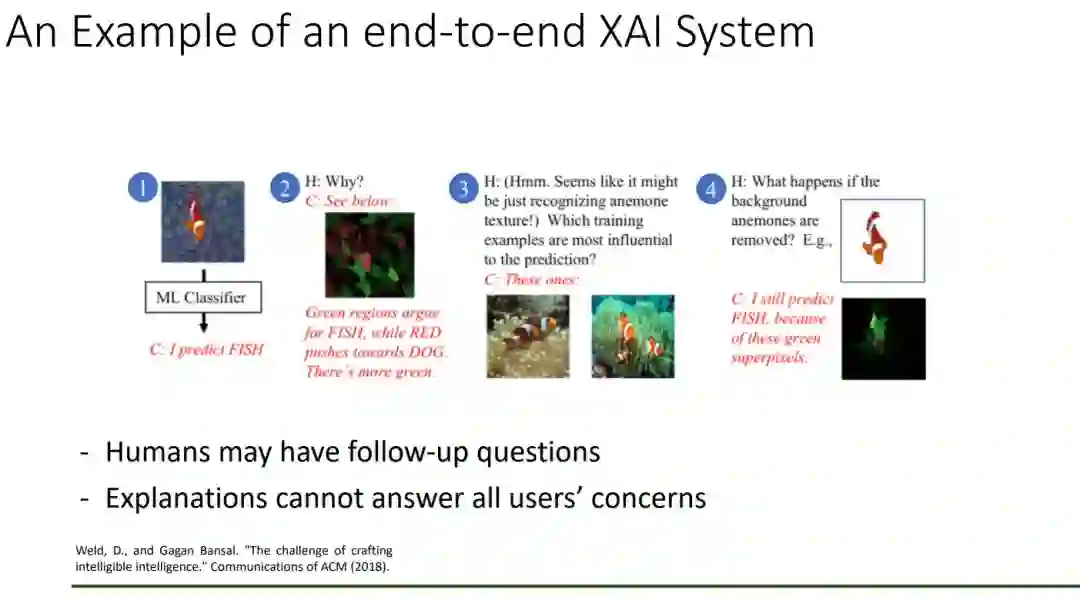

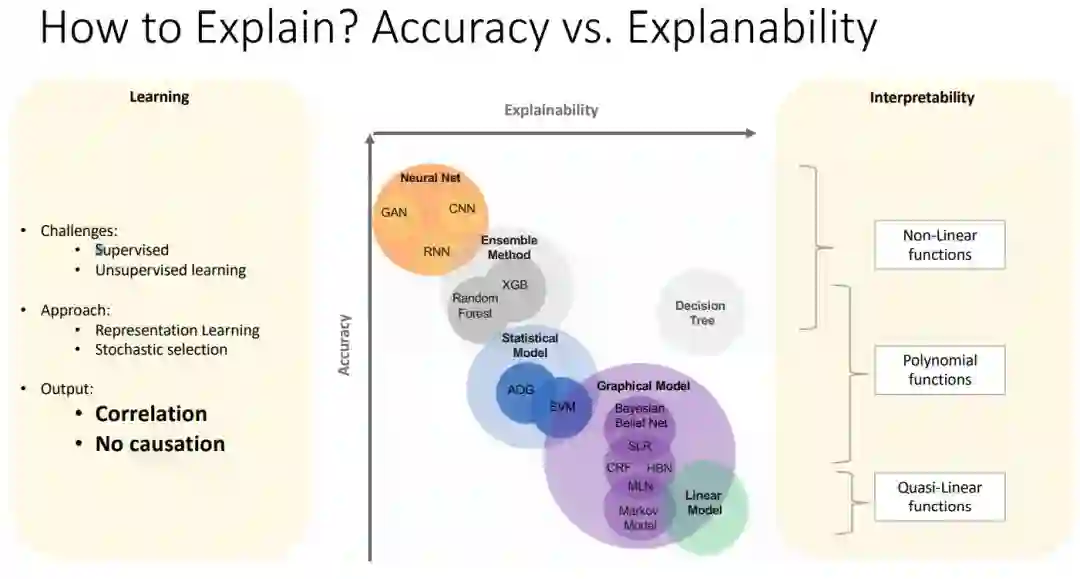

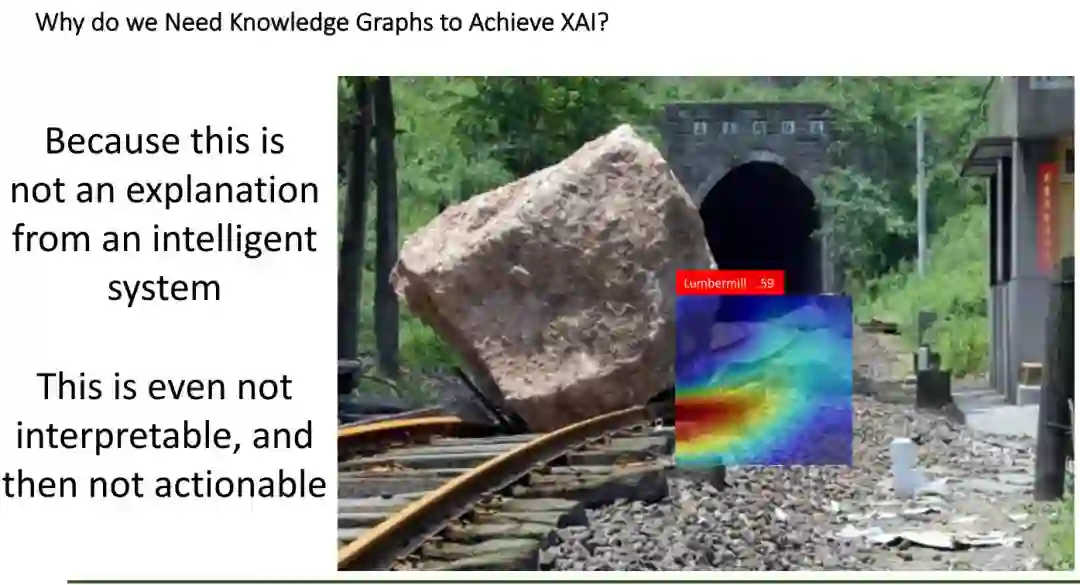

一个可以解释的AI(Explainable AI, 简称XAI)或透明的AI(Transparent AI),其行为可以被人类容易理解。它与机器学习中“ 黑匣子 ” 的概念形成鲜明对比,这意味着复杂算法运作的“可解释性”,即使他们的设计者也无法解释人工智能为什么会做出具体决定。 XAI可用于实现社会解释的权利。有些人声称透明度很少是免费提供的,并且在人工智能的“智能”和透明度之间经常存在权衡; 随着AI系统内部复杂性的增加,这些权衡预计会变得更大。解释AI决策的技术挑战有时被称为可解释性问题。另一个考虑因素是信息(信息过载),因此,完全透明可能并不总是可行或甚至不需要。提供的信息量应根据利益相关者与智能系统的交互情况而有所不同。

https://www.darpa.mil/program/explainable-artificial-intelligence