麻省理工研究:深度图像分类器,居然还会过度解读

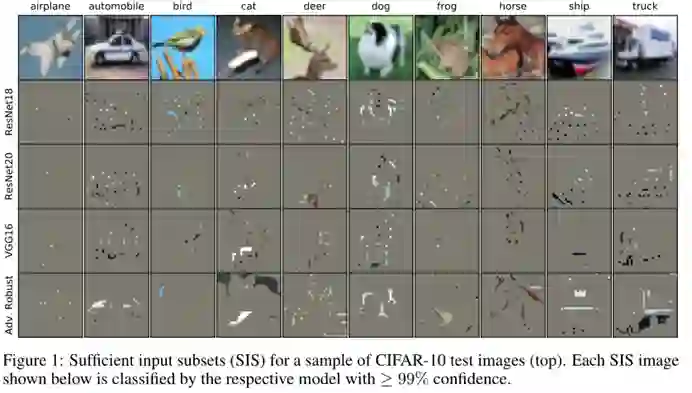

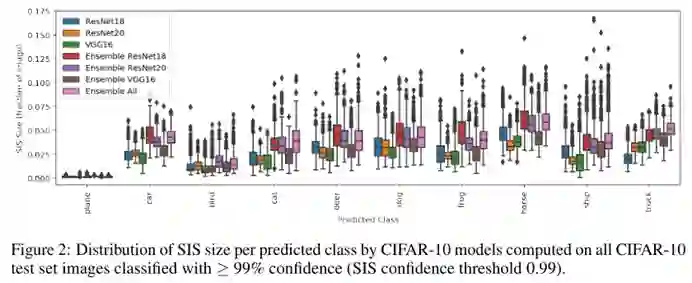

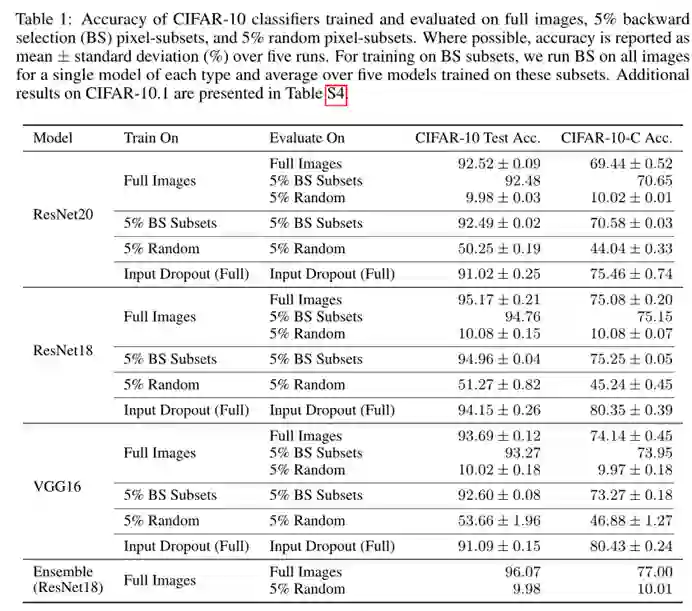

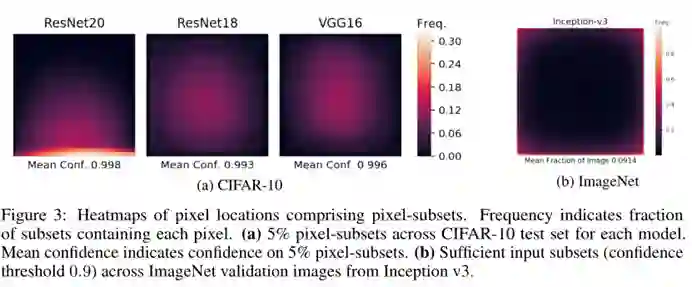

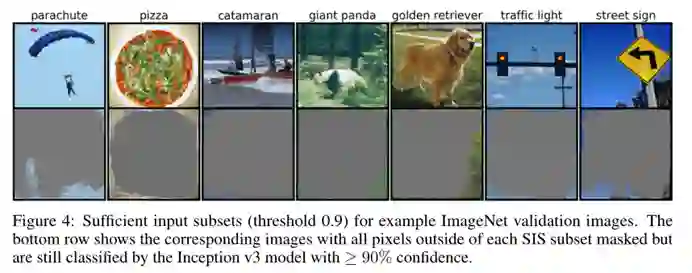

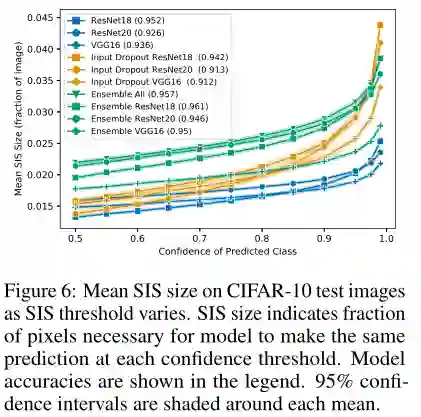

结果显示,集成测试一致地增加了预期的测试准确性,与此同时也增加了 SIS 的大小,因此削弱了过度解释的损害。

关于【数据实战派】

热门视频推荐

更多精彩视频,欢迎关注学术头条视频号

winter

【学术头条】持续招募中,期待有志之士的加入

登录查看更多

相关内容

Arxiv

1+阅读 · 2022年4月15日