编辑:小咸鱼 好困

【新智元导读】近日,来自斯坦福大学和英伟达的研究人员提出了一种新的方法,大幅提升了3D合成任务的计算效率和图像质量,不仅将渲染速度提高了7倍多,而且还将使用的内存降低到16分之一以内。

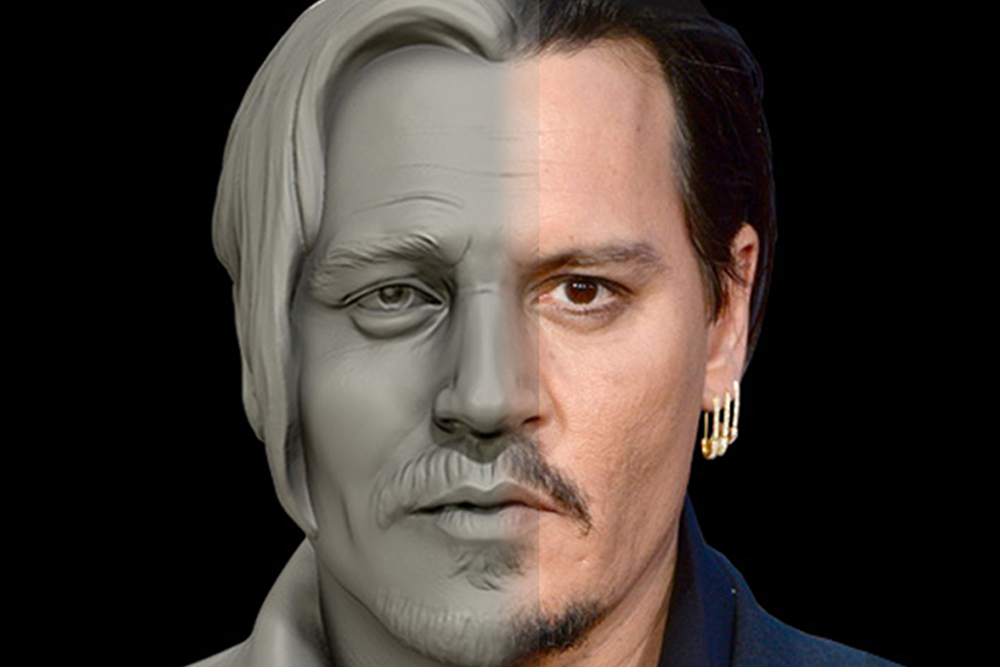

看一张平面的照片,还原一张3D人脸,对人来说好像不是那么难。

这是因为人的大脑已经做了很多的「脑补」,把单一视角看不到的信息都尽量补全了。

然而,让AI仅用单一视角的2D照片集合,无监督地生成高质量的多视角图像和3D形状,可真是要把它难倒了。

现有的3D GAN要么是计算量太高,要么近似的时候做不到3D一致性。而前者限制了生成图像的质量和分辨率,后者则对多视图一致性和形状质量有不利影响。

近日,来自斯坦福大学和英伟达的研究人员提出了一种全新的方法,在没有过度依赖近似值的情况下,改善了3D GAN的计算效率和图像质量。

https://arxiv.org/pdf/2112.07945.pdf

为此,作者引入了一个富有表现力的显式-隐式混合网络架构,不仅可以实时合成高分辨率的多视图一致性图像,还可以产生高质量的三维几何图形。

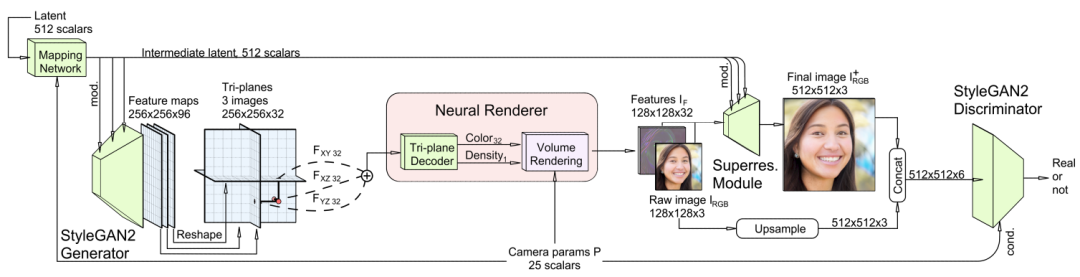

通过解耦特征生成和神经渲染,论文的框架能够利用SOTA的二维CNN生成器,如StyleGAN2,并继承其高效性和表现力。

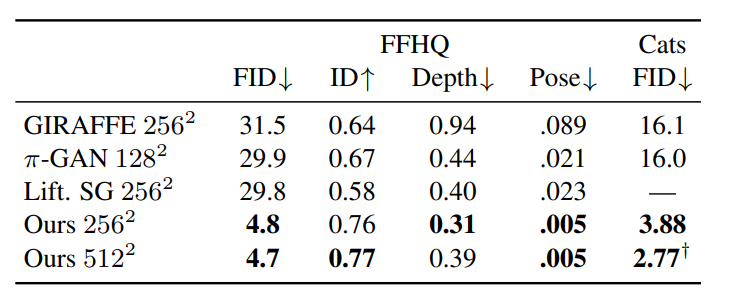

实验结果表明,论文提出的3D GAN在FFHQ和AFHQ Cats数据集上实现了SOTA的3D感知合成效果。

值得一提的是,文中的方法直接从2D图像的集合中进行训练,而不需要目标特定的形状先验、三维扫描信息或多视图监督信息。

使用FFHQ和AFHQv2 Cats训练的模型的合成示例

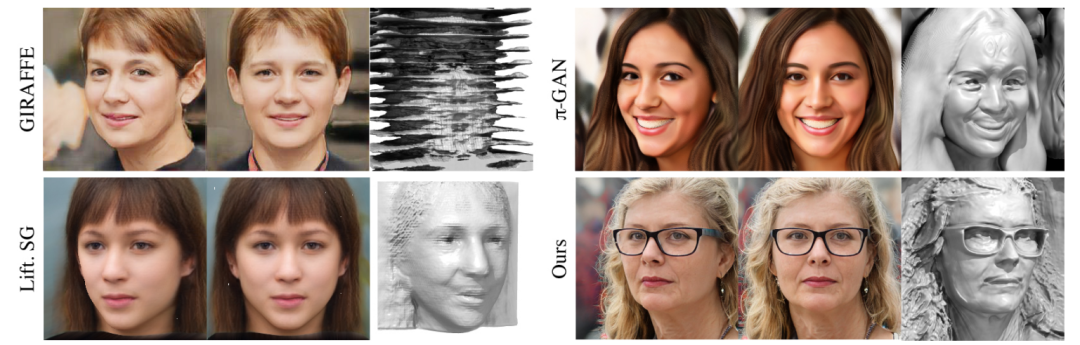

在场景合成的定性实验中,论文中的3D GAN采用的方法既能产生高质量、多视图一致的渲染,又能产生详细的3D几何图形。

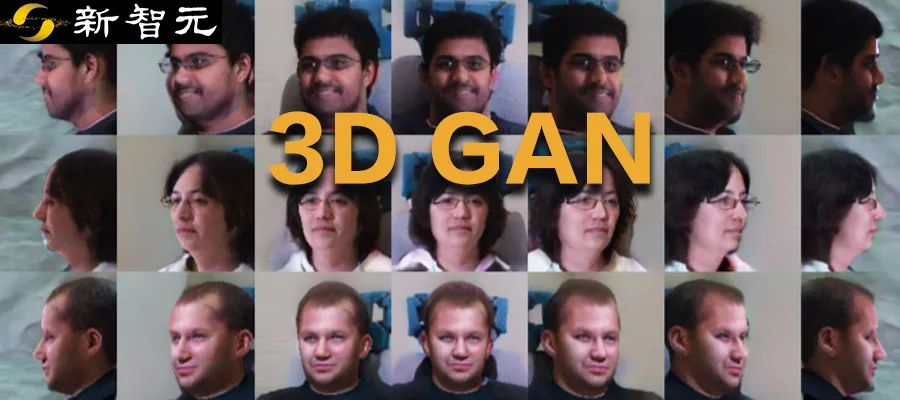

GIRAFFE,pi-GAN,Lifting StyleGAN和3D GAN产生的3D人脸效果

在渲染彩色视频时,3D GAN是通过沿着路径移动摄像机,同时固定控制场景的隐码实现的。

在渲染人物的表面时,3D GAN通过提取三维表征的密度场与等值面得到相关信息。

3D GAN框架包括几个部分:基于StyleGAN2的特征生成器和映射网络、具有轻量级特征解码器的三平面3D表示模块、神经体积渲染器、超分辨率模块和具有dual discrimination的StyleGAN2鉴别器。

这种架构将特征生成和神经渲染分离开来,并且可以使用强大的StyleGAN2生成器进行三维场景概括,十分优雅。

此外,轻量级3D三平面表示在实现高质量的3D视图实时合成方面,既能保证合成3D视图的表现力又能做到十分高效。

3D GAN框架中有一个设计非常巧妙的模块:轻量级3D三平面表示。

根据前人的工作,用神经渲染来训练GAN的成本极高。

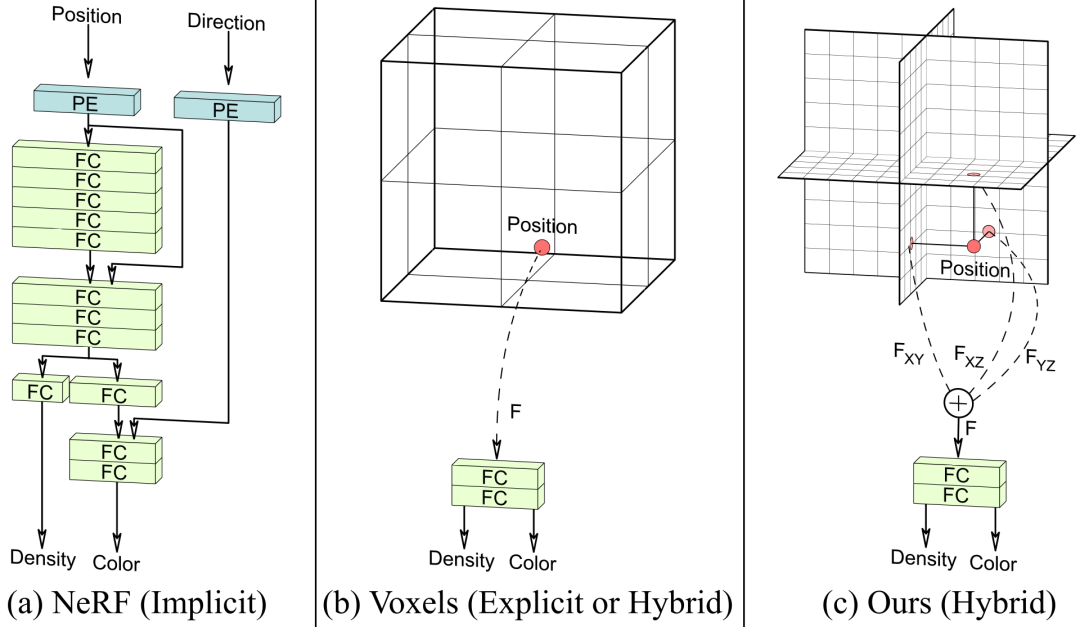

因此作者采用了一种混合的显式-隐式三维表征,从而尽可能提高神经渲染的效率。

通过结合一个显式骨干,可以产生在三个正交平面上排列的特征,以及一个小型的隐式解码器。

与典型的多层感知器表征方法相比,3D三平面表示方法在速度上提高了7倍以上,而使用的内存却不到16分之一。

如上图a所示,神经隐性表征(NeRF)使用带有位置编码(PE)的全连接层(FC)来表示一个场景,但其查询速度很慢。

上图b中的显式体素化网格(Voxels)使用小型隐式解码器的混合变体,虽然查询速度快,但随着分辨率的提高,其获得的细节也会变少。

而该论文中提出的显式-隐式混合三平面表征方法不仅速度快,而且可以随着分辨率的增加而有效地扩展,在同等容量下可以获得更多细节。

在下图中,左图为完全隐式的Mip-NeRF表示、中间为密集体素网格(Voxels),而3D GAN采用三平面表示。

该论文将3D GAN与三种最先进的三维图像合成方法(π-GAN,GIRAFFE,和Lifting StyleGAN)进行了比较。

在两个数据集上,3D GAN在FID、ID、深度精度和姿态精度指标上,实现了SOTA的性能。

在FFHQ数据集上使用FID、ID、深度精度和姿态精度进行定量评估,在AFHQ Cats使用FID进行评估,128,256,512代表训练和评估的图像分辨率

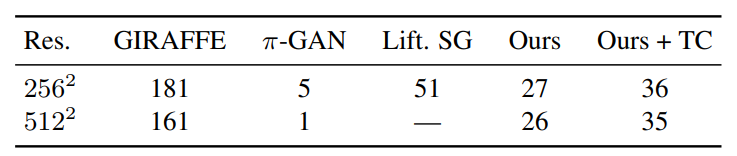

研究人员还比较了这几种方法在单个英伟达RTX 3090图形处理器上的推理渲染速度。

当然,虽然3D GAN比Lifting StyleGAN和GIRAFFE计算成本更高,但是其在图像质量、几何质量和视图一致性上,有非常重大的改进。

其中,3D GAN有使用和没使用三平面缓存(TC)方法的两种变体。实验在单个RTX 3090图形处理器上运行。

在未来,富有真实感的3D感知图像合成可以实现3D模型的快速制作、更可控的图像合成等等应用。

再进一步,如果能实现以实时帧率进行场景合成和渲染,那就会为许多令人兴奋的互动应用打开大门。

参考资料:

https://matthew-a-chan.github.io/EG3D/

https://arxiv.org/abs/2112.07945

![]()