从 Word Embedding 到 Bert:一起肢解 Bert!

从 Word Embedding 到 Bert

一起肢解 Bert!

Chat 简介:

在 NLP 中,Bert 最近很火,是 NLP 重大进展的集大成者,是最近最火爆的 AI 进展之一。最新的 Google Bert 模型中我们有这样的疑问:

1. 什么是 Bert,这个模型是怎么来的;

2. 刷新了很多 NLP 的任务的最好性能,有些任务还被刷爆了,Bert 值得这么高的评价吗;

3. 它有重大的理论或者模型创新吗。

这篇 Chat 中除了得到以上疑问的答案,您可以得到:

1. 从图像预训练为例,解释预训练的过程和意义;

2. Word Embedding 的发展历程;

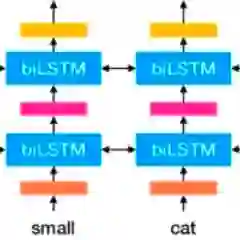

3. “Embedding from Language Models”ELMO 模型讲解;

4. “Generative Pre-Training”GPT 模型讲解;

5. Bert 的诞生和“肢解”(ELMO 和 GPT 的优势集成)。

作者简介:

武博士,人工智能方向博士,中国移动集团IT架构师。 科研方向:自然语言处理、计算机视觉、强化学习。 已经发表SCI文章3篇。 CSDN专栏文章60篇。(机器学习专栏、深度学习专栏、强化学习专栏)

长按扫码报名

登录查看更多

相关内容

Arxiv

3+阅读 · 2019年2月11日