【学界】CVPR2019:好的模型,迁移学习效果就更好吗?Google Brain最新结论

来源:极市平台

特征工程的下一步可能是如何直接操控特征(同域或不同域),而不仅仅是特征选择或特征过滤。——David9

相信很多初学迁移学习的朋友心里一直有个疑问:迁移学习的模型真的对新应用效果也好吗?更好的迁移模型,在其他应用上表现效果也更好吗?

根据Google Brain在CVPR 2019的研究总结,今天David偷懒一次,只说结论:

答案很大程度上是肯定的!Google Brain的大量实验证明,无论是把神经网络倒数第二层直接拿出来做预测,还是把预训练模型对新应用进行“二次训练”,好的imagenet预训练模型普遍有更好的迁移学习效果:

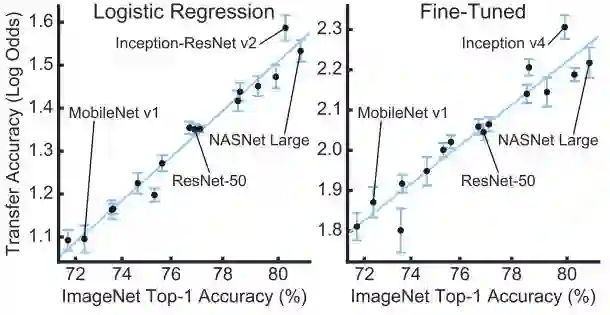

如上,左图是直接把网络倒数第二层特征直接拿出来进行迁移学习(使用Logistic Regression),右图是在新应用上find-tuned的迁移学习表现。可以注意到,只要是模型本来表现就好(横左标),迁移的效果就更好(纵坐标)。从性能最差的MobileNet到性能最好的Inception-ResNet无一例外。

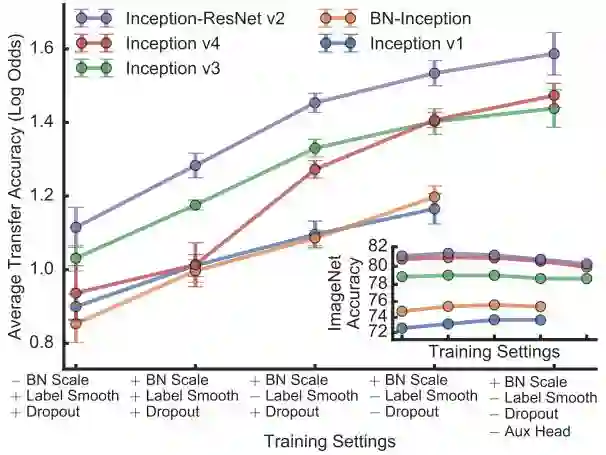

但是,迁移学习并不是就无敌了。文章指出,在迁移学习中一定要慎用正则化,正则方法如 (Dropout, Label Smooth) 用得越少,直接把倒数第二层特征迁移后,效果就越好:

上图从左到右顺着横坐标,是在模型中去掉一些正则化方法的迁移效果,其中“+”号是模型中使用的方法,“-”号是模型中未使用的方法。因为BN(batch norm)不是正则化方法,不会影响迁移学习效果。Dropout就是一种后期的正则化处理,这种操作是对迁移学习有影响的。

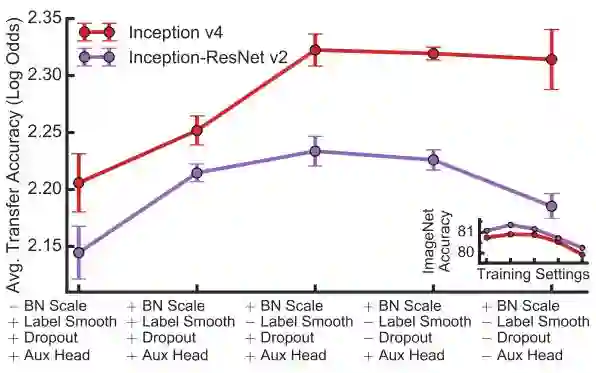

而如果你一定要使用正则化方法,并且要对模型做迁移,建议还是需要(用新数据)fine-tune一下迁移模型,这样对迁移效果影响较小:

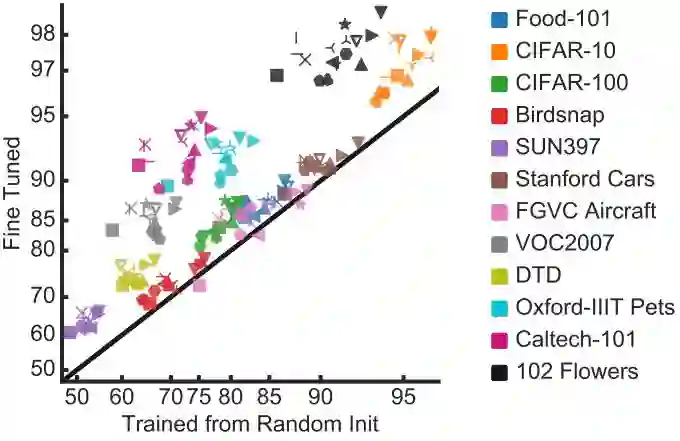

另外,并不是所有迁移学习都能达到显著效果:

文章指出,对于find-grained分类数据集(大类中含小类,小类中还能分类),如果数据量小的话,迁移学习确实有用,而如果数据量非常大,从头开始训练和迁移学习最后的效果差别不大。如上图,每个点是模型在一个数据集上迁移学习和从头训练的准确率。

参考文献:

Do Better ImageNet Models Transfer Better?

https://arxiv.org/abs/1805.08974

http://www.cs.umd.edu/~djacobs/CMSC733/FineGrainedClassification.pdf

原文:

http://nooverfit.com/wp/cvpr2019%e5%a5%bd%e7%9a%84%e6%a8%a1%e5%9e%8b%ef%bc%8c%e8%bf%81%e7%a7%bb%e5%ad%a6%e4%b9%a0%e6%95%88%e6%9e%9c%e5%b0%b1%e6%9b%b4%e5%a5%bd%e5%90%97%ef%bc%9fgoogle-brain%e6%9c%80%e6%96%b0%e7%bb%93/?from=timeline&isappinstalled=0

☞ OpenPV平台发布在线的ParallelEye视觉任务挑战赛

☞【学界】OpenPV:中科院研究人员建立开源的平行视觉研究平台

☞【学界】ParallelEye:面向交通视觉研究构建的大规模虚拟图像集

☞【CFP】Virtual Images for Visual Artificial Intelligence

☞【最详尽的GAN介绍】王飞跃等:生成式对抗网络 GAN 的研究进展与展望

☞【智能自动化学科前沿讲习班第1期】王飞跃教授:生成式对抗网络GAN的研究进展与展望

☞【智能自动化学科前沿讲习班第1期】王坤峰副研究员:GAN与平行视觉

☞【重磅】平行将成为一种常态:从SimGAN获得CVPR 2017最佳论文奖说起

☞【学界】Ian Goodfellow等人提出对抗重编程,让神经网络执行其他任务

☞【学界】六种GAN评估指标的综合评估实验,迈向定量评估GAN的重要一步

☞【资源】T2T:利用StackGAN和ProGAN从文本生成人脸

☞【学界】 CVPR 2018最佳论文作者亲笔解读:研究视觉任务关联性的Taskonomy

☞【业界】英特尔OpenVINO™工具包为创新智能视觉提供更多可能

☞【学界】ECCV 2018: 对抗深度学习: 鱼 (模型准确性) 与熊掌 (模型鲁棒性) 能否兼得