BAT机器学习面试1000题(771~775题)

BAT机器学习面试1000题(771~775题)

771题

"过拟合是有监督学习的挑战,而不是无监督学习"以上说法是否正确:

A、对

B、错

点击下方空白区域查看答案

▼

772题

下列表述中,在k-fold交叉验证中关于选择K说法正确的是:

A、较大的K并不总是好的,选择较大的K可能需要较长的时间来评估你的结果

B、相对于期望误差来说,选择较大的K会导致低偏差(因为训练folds会变得与整个数据集相似)

C、在交叉验证中通过最小化方差法来选择K值

D、以上都正确

点击下方空白区域查看答案

▼

773题

一个回归模型存在多重共线问题。在不损失过多信息的情况下,下列哪个操作不可取

A、移除共线的两个变量

B、移除共线的两个变量其中一个

C、我们可以计算方差膨胀因子(variance inflation factor)来检查存在的多重共线性并采取相应的措施

D、移除相关变量可能会导致信息的丢失,为了保留这些变量,我们可以使用岭回归(ridge)或lasso等回归方法对模型进行惩罚

点击下方空白区域查看答案

▼

774题

评估模型之后,得出模型存在偏差,下列哪种方法可能解决这一问题:

A、减少模型中特征的数量

B、向模型中增加更多的特征

C、增加更多的数据

D、B 和 C

E、以上全是

点击下方空白区域查看答案

▼

775题

在决策树中,用作分裂节点的information gain说法不正确的是

A、较小不纯度的节点需要更多的信息来区分总体

B、信息增益可以使用熵得到

C、信息增益更加倾向于选择有较多取值的属性

点击下方空白区域查看答案

▼

题目来源:七月在线官网(https://www.julyedu.com/)——面试题库——笔试练习——机器学习

100本纸质西瓜书免费包邮送

加送售价199元的《数据挖掘》课程

长按识别下方海报二维码领取

👇

今日学习推荐

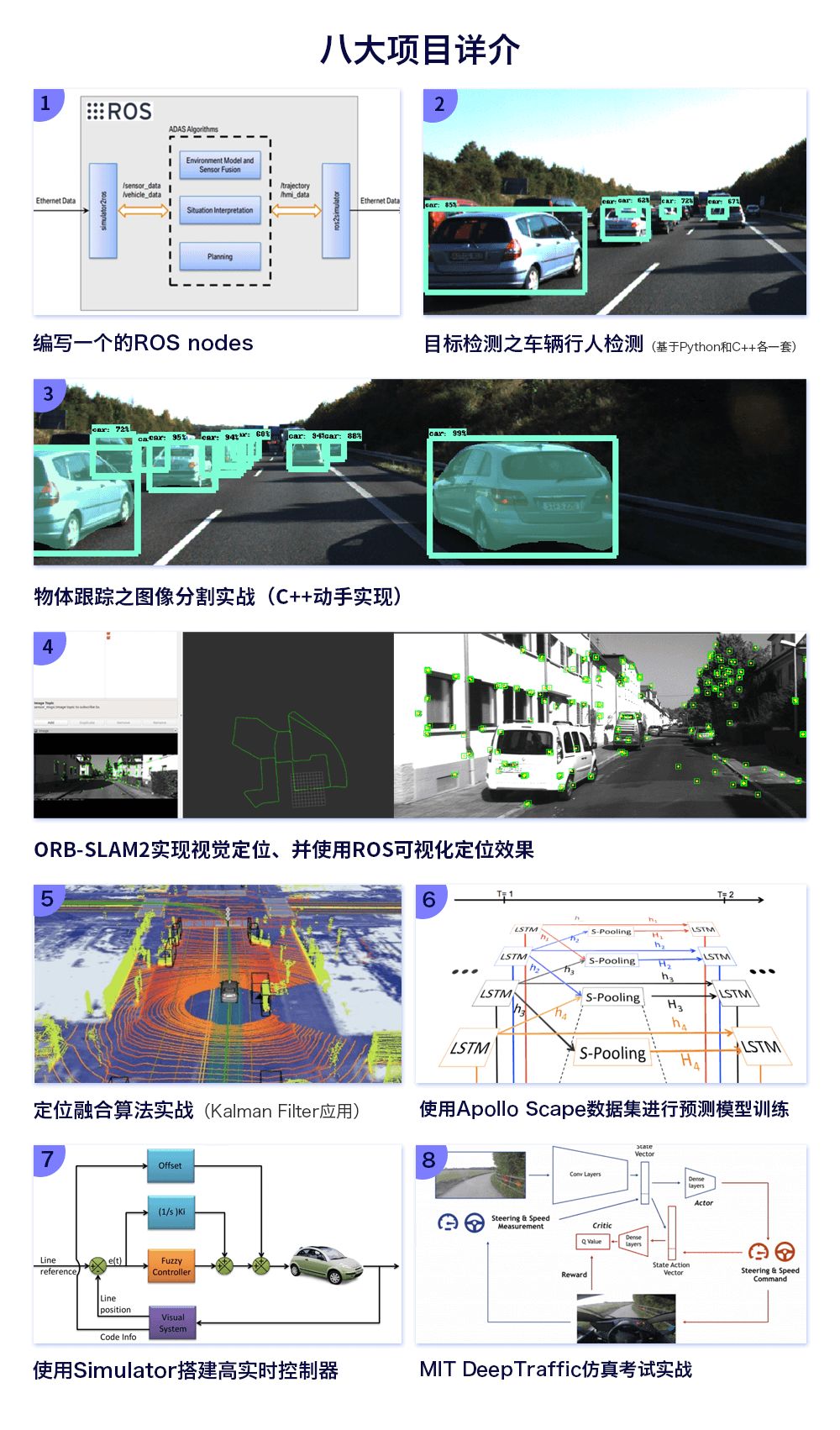

【无人驾驶实战班】

火热报名中

2019年2月23日开课

首次全面公开L4级别的全自动驾驶技术

从零搭建L4级自动驾驶系统

BAT一线讲师 核心算法讲解 八大实战项目

有意的亲们可以行动起来喽

两人及两人以上组团立减100元

咨询/报名/组团可添加微信客服

julyedukefu_02

👇

长按识别二维码

如果不想错过喜欢的内容

可以顺手打个"星标”哦

操作只需要四步

简单快捷,马上学起来

更多资讯

请戳一戳

往期推荐

GitHub标星10k,从零开始的深度学习实用教程 | PyTorch官方推荐

AI今年最大进展就是毫无进展?2019年AutoML、GAN将扛大旗

点击 “ 阅读原文 ”,进入主会场