也谈谈Atiyah关于黎曼猜想的证明

来源:潇轩社

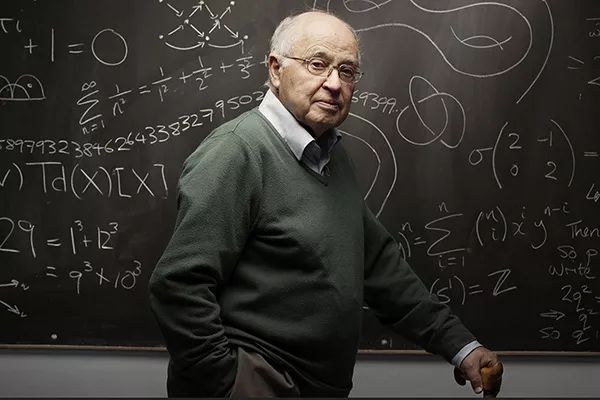

作者:叶扬波 著名数学家,美国爱荷华大学教授。作为数论学家,他在中国大陆出版有《迹公式与模形式》等专著。以下是他谈Atiyah关于黎曼猜想的证明的文章,观点专业而且独到,转载此文,希望大家能根据此文看到Atiyah证明黎曼猜想的基本思想与价值。

这几天大家都非常关心Atiyah证明黎曼猜想的事情。作为一名数论工作者,我自然也非常关心,而且反复阅读了Atiyah的两篇论文。现在所有的人都在说他的证明不对,我想要进一步弄清楚(1)他是用什么思路什么方法来研究黎曼猜想的,(2)他的所谓证明是否严格,(3)即使他的证明是错的,他的思路方法是否有可取之处。现在谈谈我的看法,以补充大家的热议。

问题(2)最容易回答,老先生的文章的确有许多漏洞。比如最关键的Todd函数T(s)他说在任意凸区域内是多项式,我觉得他应该说T(s)在凸区域内是局部多项式。他又说T(s)把直线Im(s)=1/2映射到自己,可是又说T(s)在这条直线上的极限为137.035999... 他说T(s)在这条直线上是单调增,可是他明明刚说过T(s)在凸区域1/4<Re(s)<3/4, |Im(s)|<a上是(局部)多项式。这样的逻辑混乱使得这个Todd函数是否存在都令人怀疑,尤其是T(s)的定义也是给的不明不白的。

更加致命的错误可能是用T(s)来证明黎曼猜想。老先生用T(s)和黎曼zeta函数

zeta(s)=1/1^s+1/2^s+1/3^s+...

作了一个复合函数,宣称该复合函数恒等于零,用这个矛盾推出了黎曼猜想成立。可是这个证明过程中没有用到zeta(s)的任何性质与定义,也就是说你可以把zeta(s)换成任何其他函数也能证明出来类似的定理。这就有点天方夜谭了。

Atiyah的证明是建立在实数域R上的von Neumann冯·卡门代数A和有理数域Q上的Hirzebruch代数A(Q)上的。这两个代数超级巨大,比如A是2x2复矩阵代数与自身的无穷张量积的弱闭包。2x2复矩阵有两个映射到复数域C,为矩阵映到其两个特征值。老爷子把这两个映射扩充到A的中心C(A)上,用这两个映射一来一回定义T(s)。可是矩阵代数的中心不是都由相同对角元素的对角矩阵组成的吗?这两个特征值是一样的对不对?就算两个特征值不一样,你凭什么说哪个是第一个哪个是第二个?尤其是还要来一个无穷张量积,全裹和到一块儿去了,这样定义出来的T(s)令人费解。

回到问题(1),大家已经看出来了,Atiyah的理论是建立在巨大无比的两个代数结构上的。这两个巨大的代数一个在R上,一个在Q上,它们之间的关系包含了所有的数论信息。而以这两个代数中的元素作为线性算子,它们的特征值为所谓的证明提供了核心的基础框架。不管证明对不对,上面这几句话概括了Atiyah的思路与方法。

那么问题(3)来了,到底Atiyah的思路与方法有没有可取之处?

近年来数论界对黎曼猜想的研究,公认的一个进展是发现黎曼zeta函数的非平凡零点与重原子能级有同样的统计分布。重原子能级是量子力学中Hamiltonian算子的特征值。这个发现一度被认为是自黎曼猜想之后人类对黎曼zeta函数的第二个重大发现。但是几年之后一位学者在德国的一家图书馆翻阅黎曼数学手稿,赫然发现黎曼在计算黎曼zeta函数零点的手稿的纸背,写有大量关于原子能级的计算。这一下真相大白,原来黎曼早就意识到了非平凡零点与重原子能级之间的可能联系。

从此数论学家们的目标就是要找到这样一个算子,使得它的特征值是黎曼zeta函数的非平凡零点。然后通过研究这个算子,就像对称算子特征值均为实数一样,证明所有非平凡零点的实部均为1/2,从而证明黎曼猜想。而这个思路在有限域上的函数域上已经被证明了。

从这个意义下来说,Atiyah的思路是对的。算子有了,特征值也出现了。是不是他用的von Neumann算子代数和Hirzebruch算子代数真的包含了大家梦寐以求可以用来证明黎曼猜想的那个算子,或者可以在其之上构建出一个,我想这未来的几年一定会研究辈出。大家翘首以待吧,或者最好亲身加入这个研究的行列。这条路如果最终能够走通,Atiyah的文章就是有历史意义的了。

未来智能实验室是人工智能学家与科学院相关机构联合成立的人工智能,互联网和脑科学交叉研究机构。

未来智能实验室的主要工作包括:建立AI智能系统智商评测体系,开展世界人工智能智商评测;开展互联网(城市)云脑研究计划,构建互联网(城市)云脑技术和企业图谱,为提升企业,行业与城市的智能水平服务。

如果您对实验室的研究感兴趣,欢迎加入未来智能实验室线上平台。扫描以下二维码或点击本文左下角“阅读原文”