李飞飞等人论文登上Nature子刊:人工智能为ICU病人带来福音

选自 Nature Digital Medicine

机器之心编译

参与:路雪、王淑婷

重症监护病房 ICU 是病人和医生争取生命的战场,在美国每年约有 1% 的 GDP 被花费在 ICU 病房里。患者移动可大大降低 ICU 后综合征和长期功能障碍的风险,但相关的具体研究还很匮乏。近日,Serena Yeung、李飞飞等人的论文被自然子刊《Nature Digital Medicine》收录,该研究利用算法估计 ICU 病人移动活动的类型、频率和持续时间,有助于了解移动性干预对重症病人的具体作用,从而有可能降低 ICU 后综合征的风险。

这篇论文的海报

摘要

早期频繁的患者移动大大降低了 ICU 后综合征(post-intensive care syndrome)和长期功能障碍的风险。来自斯坦福大学的研究者开发和测试了计算机视觉算法来检测成人 ICU 病房中的患者移动活动。移动活动被定义为将患者移上或移下床、移上椅子或移下椅子。研究者从 Intermountain LDS 医院的 ICU 病房中收集了一组具备隐私安全性的深度视频图像,包含 563 个移动活动实例和 98,801 帧视频数据,这些数据来自 7 个安装在病房墙上的深度传感器。总的来说,67% 的移动活动实例用于训练算法来检测移动活动的发生时间和持续时长以及参与每次移动的医护人员数量。剩下的 33% 实例用来评估算法性能。检测移动活动的算法在四种活动中达到了 89.2% 的平均特异性(specificity)、87.2% 的敏感度(sensitivity)。量化移动活动中医护人员数量的算法达到了 68.8% 的平均准确率。

引言

长期高强度护理的幸存者经常患有 ICU 后综合征,其特征是长期的认知和身体障碍,导致功能状态显著下降。移动重症患者可以缩短脱离呼吸机的时间、减少精神错乱、防止肌肉萎缩和身体功能障碍(ICU 获得性虚弱)。这一点很重要,因为这些都是可以预防的伤害,会影响病人整体的生存、独立展开生活的能力以及和健康相关的生活质量。虽然早期研究表明,移动性干预有利于特定的患者群体,但还需要更详细的研究来确定移动性活动的类型、频率和持续时间的变化对不同患者群体的影响。然而,目前此类研究的范围很有限,因为早期移动协议的实施需要克服大量组织和文化障碍,而且其成功历来难以衡量。

当前监测病人移动性的做法包括直接观察和挖掘电子健康记录(EHR),来记录移动性事件。这些方法费时费力,且容易导致不准确的记录,并且在病人护理和报告之间存在明显的时间差。计算机视觉技术(CVT)提供了一个替代方法:从临床环境中被动地捕捉数据,然后应用机器学习算法来自动检测和量化病人与医护人员的活动。事实上,人们对在医院中使用 CVT 进行活动识别和改善病人护理越来越感兴趣。例如,计算机视觉已被用来在医院走廊自动识别医护人员的手部卫生活动和急诊科的复苏事件。CVT 还被用在手术室中,算法识别病人护理任务(如将病人移至手术台)、手术过程中的步骤和工具,甚至外科医生的手术水平。最后,也是与本文研究最相关的是,Ma 等人使用 CVT 来确定单个 ICU 病房中患者的数字移动水平。基于这项研究,本文使用基于深度传感器的 CVT 收集了来自 7 个成人 ICU 病房的数据,开发了机器学习算法来检测病人的床边活动时间和参与的医护人员数量。

结果

检测移动性活动的算法性能

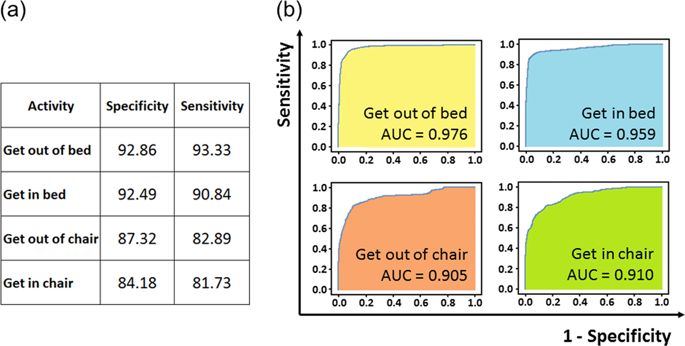

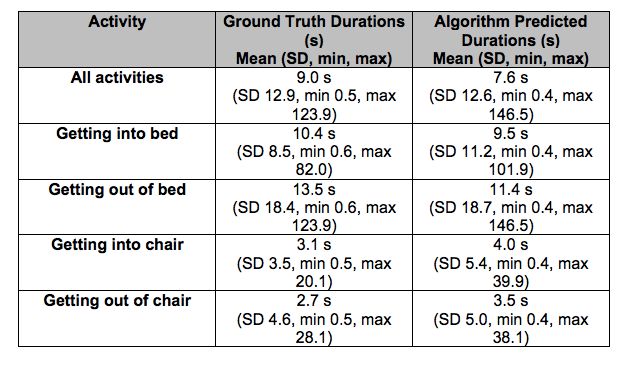

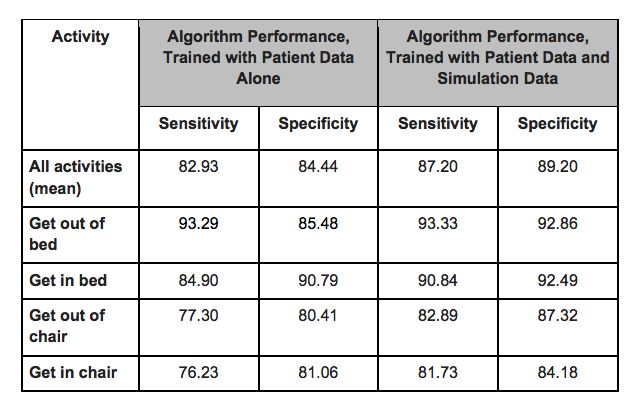

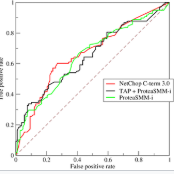

研究者对算法在视频数据单个帧上的预测结果(帧级别预测)进行了评估,发现检测移动性活动发生的算法在四种活动上达到了 87.2% 的平均敏感度和 89.2% 的平均特异性,平均曲线下面积(AUC)为 0.938。每种活动的 ROC 曲线如图所示。帧级别预测被合并,用于确定算法检测到的移动性活动的持续时长。算法预测的所有移动性活动的平均持续时长为 7.6s(标准差为 12.6s,最小值为 0.4s,最大值为 146.5s,每种活动的持续时长参见补充数据 1)。为方便对比,基于人工审核的标注数据(真值)得出的所有活动平均持续时长为 0.9s(标准差为 12.9s,最小值为 0.5s,最大值为 123.9s,关于算法预测持续时长和真值持续时长的对比请参见补充表 1)。活动分类正确且预测持续时长在真实值标准持续时长+ /− 15% 范围内的移动性活动占 58.1%;预测持续时长在真实值标准持续时长+ /− 25% 范围内的活动占 68.7%;预测持续时长在真实值标准持续时长+ /− 50% 范围内的活动占 82.0%。

图 1:检测移动事件发生的算法性能。(a):在每一帧上评估的每个类别的特异性和敏感度。(b)每个类别的 ROC 曲线。ROC 曲线表示敏感度(真正率)和 1-特异性(假正率)之间的权衡。

补充表 1:活动持续时长真值和预测值对比。

检测医护人员数量的算法性能

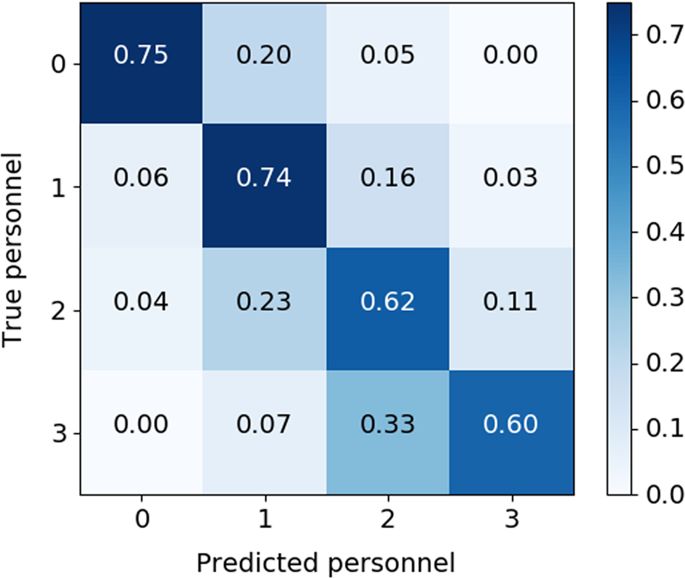

用于量化每个移动事件中医护人员数量的算法达到了 68.8% 的平均准确率。图 2 是真值 vs. 预测人数的混淆矩阵。该矩阵表明,当病人单独行动时,算法准确检测到 0 名医护人员的概率为 75%,当 1 名医护人员出现时,算法准确检测到 1 名医护人员的概率为 74%。对 2 或 3 名医护人员检测的准确率分别为 62% 和 60%。在 78% 的时间里,算法可以正确检测 2 个或更多的医护人员。

图 2:量化移动事件中医护人员人数的算法性能。该混淆矩阵展示了移动事件实例中医护人员的真正数量(0–3)和算法检测到的数量的对比。当病人自己移动时,算法检测到的医护人员数量为 0。当病人在一名医护人员的帮助下移动时,算法检测到的结果为 1,依此类推。

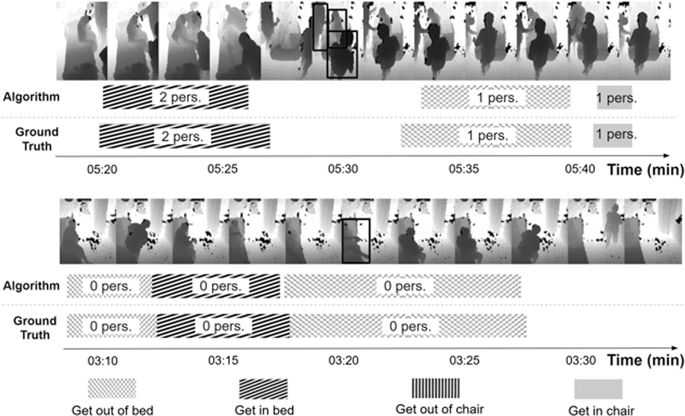

图 3 展示了算法输出的定性示例。图中显示了两个(压缩)时段的采样深度图像帧。此外,下图中的时间线还显示了检测到的活动类型、发生时间、持续时长,以及涉及的医护人员数量。为方便对比,下图还显示了真值数据。

图 3:移动事件发生和医护人员出现的时间线。上图展示了两个时间线,每个时间线中展示了该时段内的采样深度图像帧。人物检测的空间边界框是重叠的(为方便观看,仅在中间帧上显示)。每个移动事件中的时间范围和医护人员数量(pers)都显示在时间线上。为方便对比,时间线上还显示了人类标注的真值数据。

方法

该研究在盐湖城 Intermountain LDS Hospital 的成人 ICU 病房展开,开展时间为 2017 年 8 月-10 月。研究参与者为进入 ICU 病房的病人和医院职工,病房装有计算机视觉深度传感器。

该研究依靠深度传感器来收集数据。深度传感器基于人和物体与传感器的距离来捕捉其 3D 图像,从而既提供了视觉信息又能保护隐私。传感器安装在七个单独的病房内,安装位置正对病床,在研究开展的两个月内 24 小时不间断收集数据。

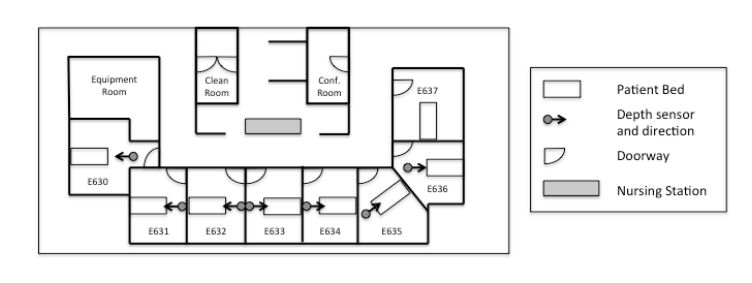

病房布局和传感器安装布局如下图所示:

关于数据标注,研究者请训练有素的研究助理对收集到的数据进行手动评估和标注,将这些活动分为四类移动事件:病人离开病床、病人移到病床、病人离开椅子、病人移到椅子。

训练和测试数据集

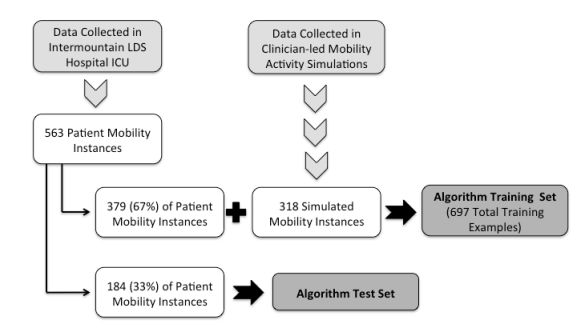

最终数据集中包含 563 个移动事件标注类别,其中 154 个属于病人离开病床、182 个属于病人移到病床、112 个属于病人离开椅子、115 个属于病人移到椅子上。最终数据集涵盖 98,801 个数据帧,时长 5.7 小时。研究者随机选取数据集中 67% 的移动活动实例和帧作为训练数据,另外 33% 作为测试数据。因此,有 379 种病人移动活动实例被用于训练,其余 184 种实例用于测试。测试数据集中病人离开病床的实例有 48 个,病人移到病床的实例有 64 个,病人离开椅子的实例有 32 个,病人移到椅子上的实例有 40 个。

训练数据增强

研究过程中还使用了数据增强技术。为了提升算法性能,研究者使用对目标移动事件的数据模拟来增强训练数据集。下图展示了如何将模拟数据融入训练数据集。需要注意的是,模拟数据仅用于改善模型训练,而不用于算法准确率的评估,使算法准确率评估仍基于病人数据。

下图展示了算法在训练数据有/无模拟数据时的性能数据。我们可以看到这种增强数据方法有效地提升了模型性能,且时间效率很高,它将模型在评估数据集上的平均敏感度和特异性分别从 82.93% 和 84.44% 提高到了 87.20% 和 89.20%。

移动事件类型及持续时长的检测模型

移动事件类型及持续时长的时间检测算法是一个多标签循环卷积神经网络模型。研究者在大规模 ImageNet 数据集上对 18 层的 ResNet 进行预训练,然后再在该研究的数据集上对模型进行精调,以便模型能从每一个数据帧中提取有信息的视觉特征。之后,研究者使用两层的双向LSTM 网络在这些特征的连续 64 帧序列中对时间结构进行推理。该研究集成了 6 个此类模型,来生成最终检测输出。

医护人员检测模型

该研究中用于量化每个移动事件中医护人员人数的算法是基于 YOLOv2 卷积神经网络构建的。研究者使用 YOLOv2 预测每个数据帧中人员的空间位置。在研究所用的数据集中,有 7% 的移动事件没有医护人员,51% 的移动事件中有 1 名医护人员,32% 的移动事件中有 2 名医护人员,10% 的移动事件中有 3 名医护人员。

算法的性能评估

该算法的准确率评估方法是:对比真值结果和算法的预测结果。使用 Python 3.6 执行敏感度、特异性和 ROC 计算。

论文链接:https://www.nature.com/articles/s41746-019-0087-z

本文为机器之心编译,转载请联系本公众号获得授权。

✄------------------------------------------------

加入机器之心(全职记者 / 实习生):hr@jiqizhixin.com

投稿或寻求报道:content@jiqizhixin.com

广告 & 商务合作:bd@jiqizhixin.com