CNN骨干网络新选择HS-ResNet

极市导读

本文的网络结构是手工设计得来,主要改进在对特征图多级划分卷积,拼接,提升了网络的精度,同时也降低了推理时间。感觉是res2net,ghostnet的结合,并且训练阶段没引入过多的trick,最后的实验结果很惊艳,或许是炼丹的一个好选择。 >>加入极市CV技术交流群,走在计算机视觉的最前沿

前言

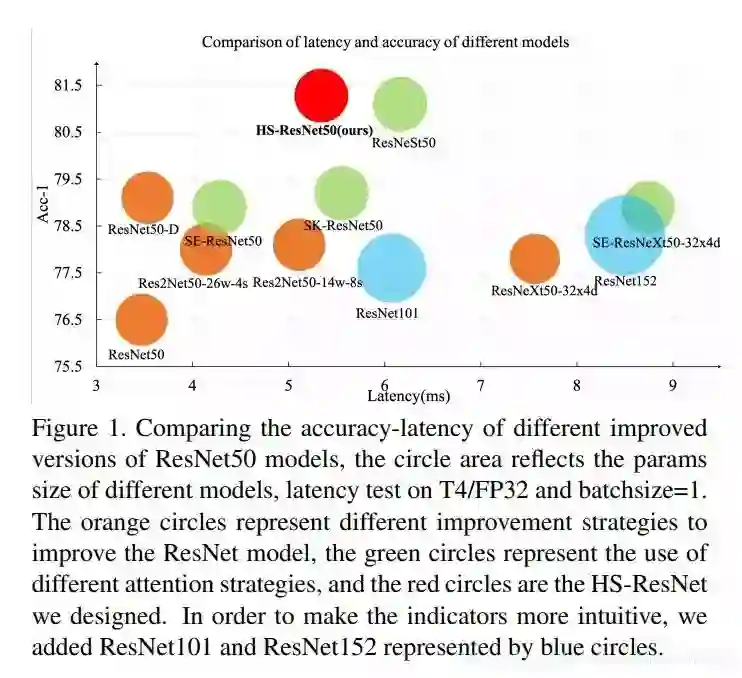

在该工作内,我们发现多层级的特征对视觉任务效果提升明显,因此设计了一个即插即用的多级分离模块(Hierarchical-Split Block)。HS-Block包含了多个层级特征图的分离和拼接,我们将其替换到Resnet中,提升效果明显,top-1准确率能达到81.28%,同时在其他任务如目标检测,分割表现也十分出色。

介绍

这篇工作里面我们考虑以下3个问题

-

如何避免在特征图产生 冗余信息 -

如何在 不增加计算复杂度前提下,让网络学习到 更强的特征表达 -

如何得到更好的精度同时, 保持较快的推理速度

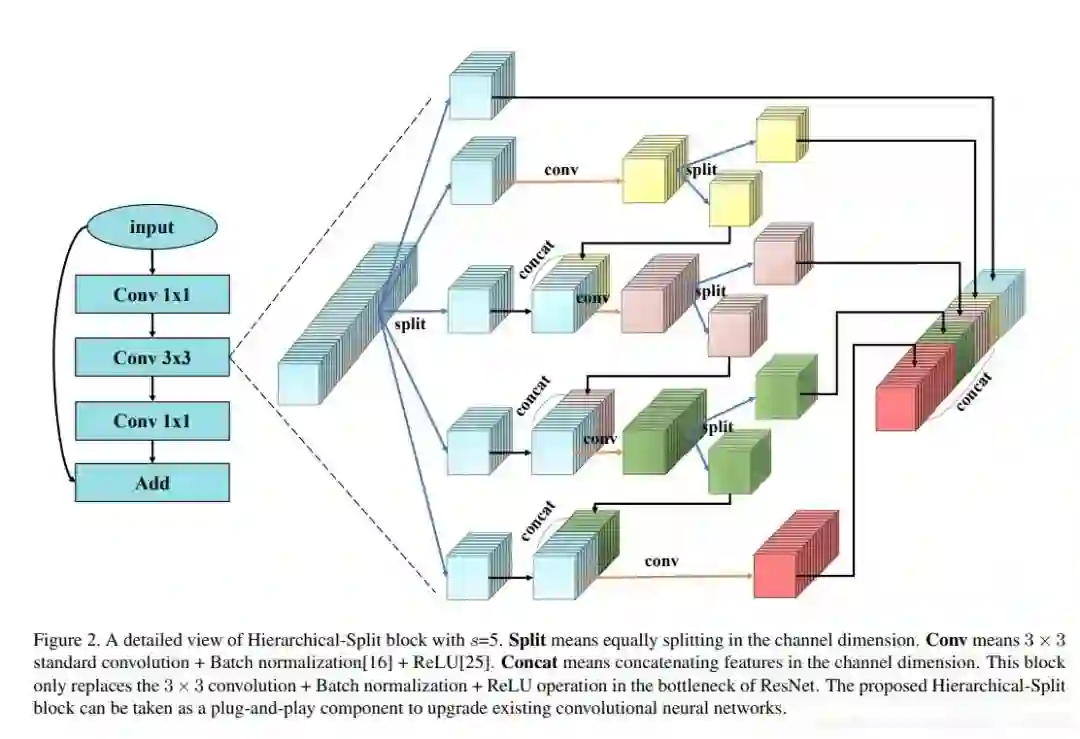

基于上述3个问题,我们设计了HS-Block来生成多尺度特征图。在原始的特征图,我们会分成 S 组,每一组有W个通道(也即W个特征图)。

只有第一组的能直接送入到最后的输出中从第二组开始操作就开始不一样了:

-

第二组的特征图经过3x3卷积后,得到了 图示的黄色方块 -

然后它会被 分离成两组子特征图 -

一组子特征图 拼接到最后的输出 -

另一组子特征图 拼接到第三组特征图,如此循环往复

可以看到这个操作还是比较复杂的,但基本都是按照上述那四条规则循环进行。最后拼接完的特征图我们会再用1x1卷积进行特征融合

灵感来源

在论文内,作者也说了灵感来自于res2net和Ghostnet(解析可参考 [华为GhostNet网络]![] 我们先来分别回顾这两个网络主要的模块Res2Net的模块结构如下:

Res2Net模块示意图

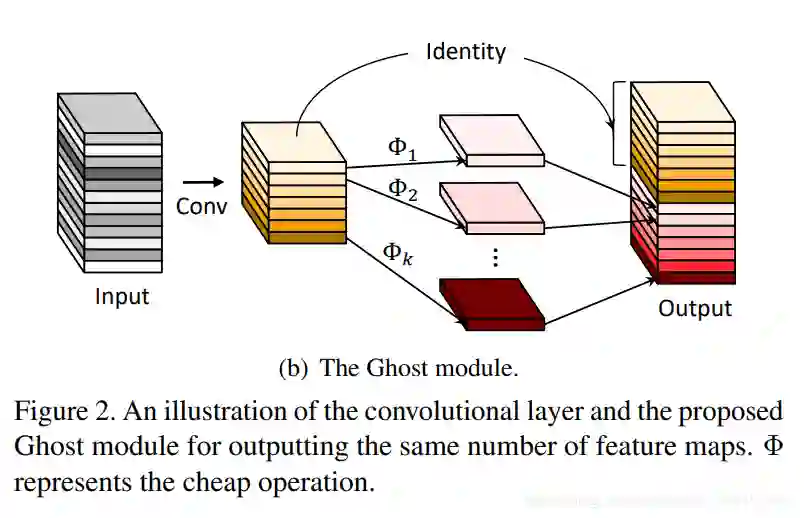

Res2Net的模块也是将一组特征图分离成4组,分层做卷积。特殊点在于第二组特征图经过3x3卷积后,是以 elementwise-add 的形式加到第三组特征图上。类似的,第三组特征图经过3x3卷积后,也以elementwise-add的形式加到第四组特征图上。下面我们看看GhostNet模块:

GhostNet的设计思想是为了减少特征图冗余,部分特征图可以在已有特征图上经过卷积操作得到。因此它先通过一个卷积模块得到黄色部分,再在黄色部分中进一步生成特征图(原论文是Depthwise Conv),最后两者拼接到一起。

设计思想

HS-Block的多尺度分离,卷积的做法。能容不同组的特征图享受到不同尺度的感受野。在前面的特征图,拼接进来的特征卷积次数较少,感受野较小,能关注细节信息。在后面的特征图,拼接进来的特征卷积次数较多,感受野较大,能关注全局信息这部分思想来源于res2net,通过不同感受野,增加特征的丰富性。那么引入了另外一个问题,res2net的做法在通道数量较大的时候,计算复杂度也随之增加。那么是不是所有特征图都是必须的呢?在GhostNet里面有观察到并不是

部分特征图是可以在已有特征图上生成,因此借助GhostNet的思想,我们在模块内将 S2 组卷积得到的特征图,部分拼接到 S3 组,实现了特征图的复用,后续组也是这样一个做法,成功用 GhostNet 思想降低了计算复杂度。

分析计算复杂度

常规的卷积核参数计算是

在resnet的BottleNeck结构里,输入前后通道数不变,而在我们这里,是分成S组,每组W个通道,换句话说,我们输入通道是而我们使用的卷积核长宽都是一致的,替换到上面公式就是

现在我们看下HS-Block这里的计算量 由于第一组特征图直接拼到后面,所以没有计算量后面的特征图,输入通道需要concat,前面一半的特征图 因此在原始的W上,还有额外加多一项,输入通道为:这里输入通道推导可能光看公式不太清楚,其实可以手推一下,基本的情况是

最后每一组卷积的参数为$$param_i = K*K*W*W*( \frac{2^{i-1}-1}{2^{i-1}}+1) \space(1注意到上面是每一组卷积的参数,总参数我们需要累加起来

其中1是常数项,累加s-1次,和为s-1,我们单独提出来

而累加项中很容易得知因此我们有推出不等式

我们代入前面公式有

与常规卷积参数比较

可以看到参数量确实是减少了

实验结果

可以看到最后的实验,得益于合理的设计思想,HS-ResNet的性能和速度都很快。

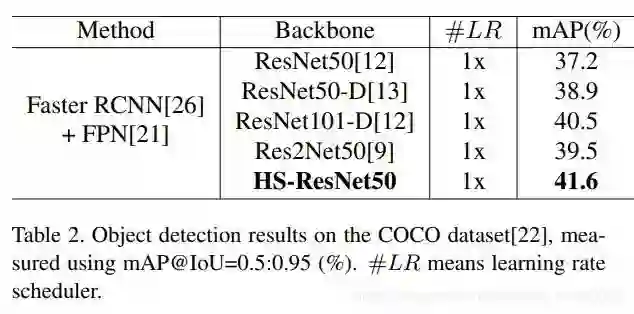

目标检测实验

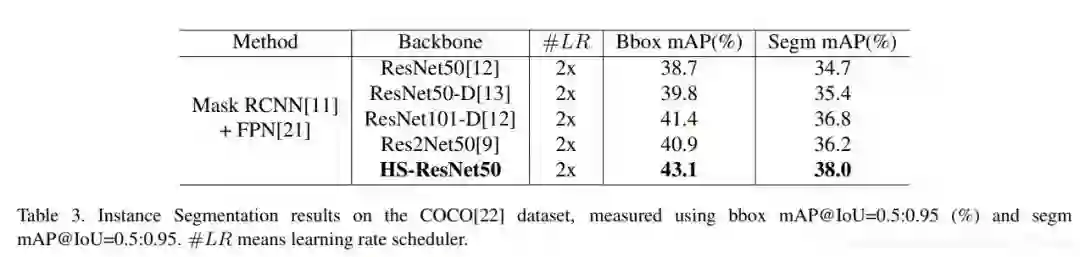

图像分割实验

在目标检测,分割等其他任务中表现也十分优秀

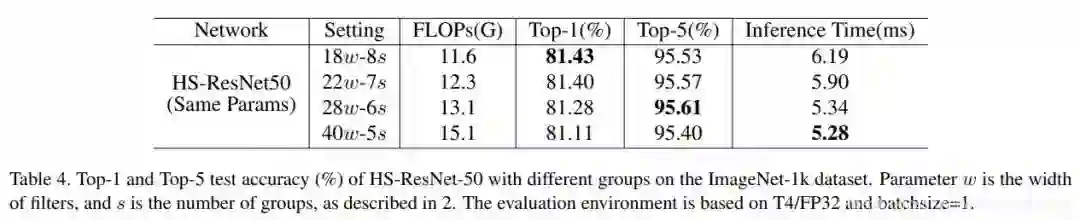

作者也在最后探讨了下分组数对于性能,推理速度的影响,可以看到这个模块也是十分灵活,性能和速度都是可以自行调整的

最后

目前Paddle官方还在做后续实验,相关代码模型还没放出来。作者的思想也不是很复杂,将res2net和ghostnet的思想融合进来,也保留了灵活性,拓展性,相信这个模型还会有更大的潜力。

推荐阅读