回放 | 华为诺亚方舟ICLR满分论文:基于强化学习的因果发现

文 | 朱胜宇

编 | 贾 伟

在昨天我们进行了第四期【ICLR 2020 系列论文解读公开课】,来自华为诺亚实验室的高级研究员朱胜宇博士,就他在ICLR 2020 上的满分论文《Causal Discovery with Reinforcement Learning》做了精彩分享。我们在本文中:

1、论文简介;

2、放入回放视频;

3、解读PTT展示。

如下:

论文简介:

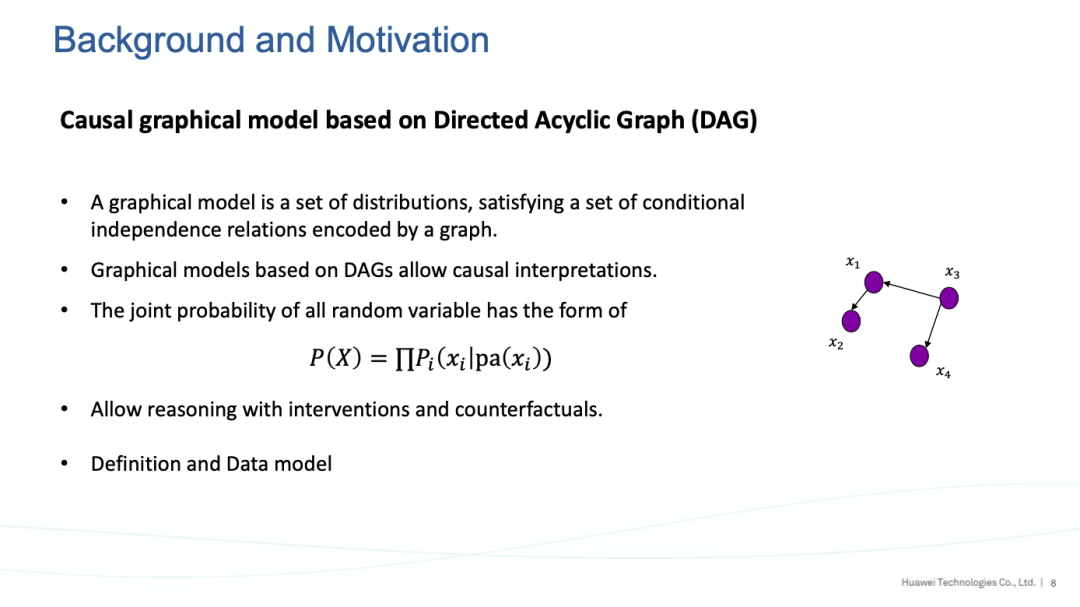

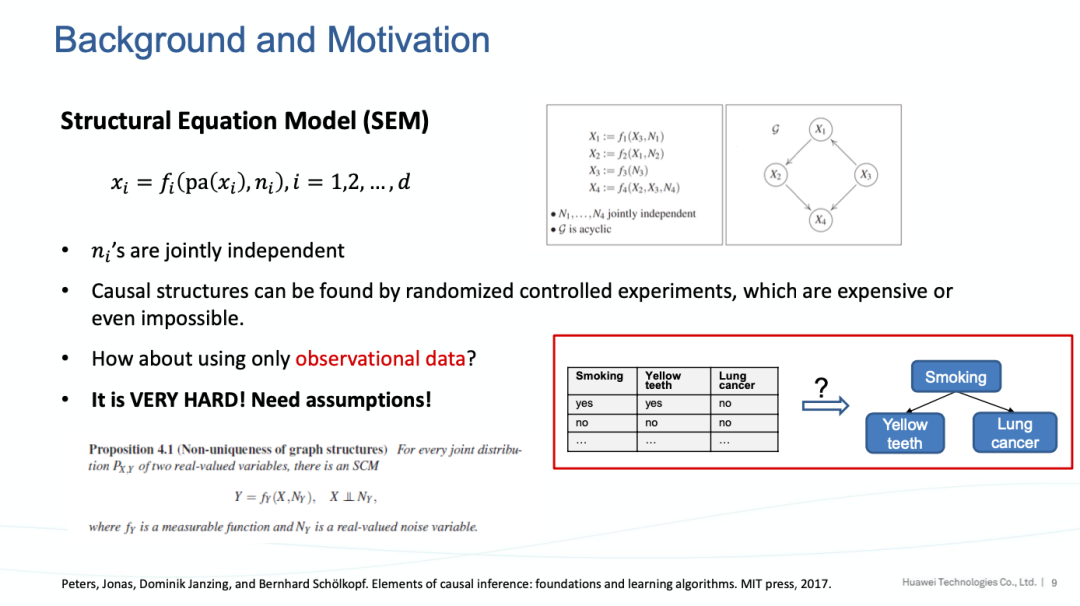

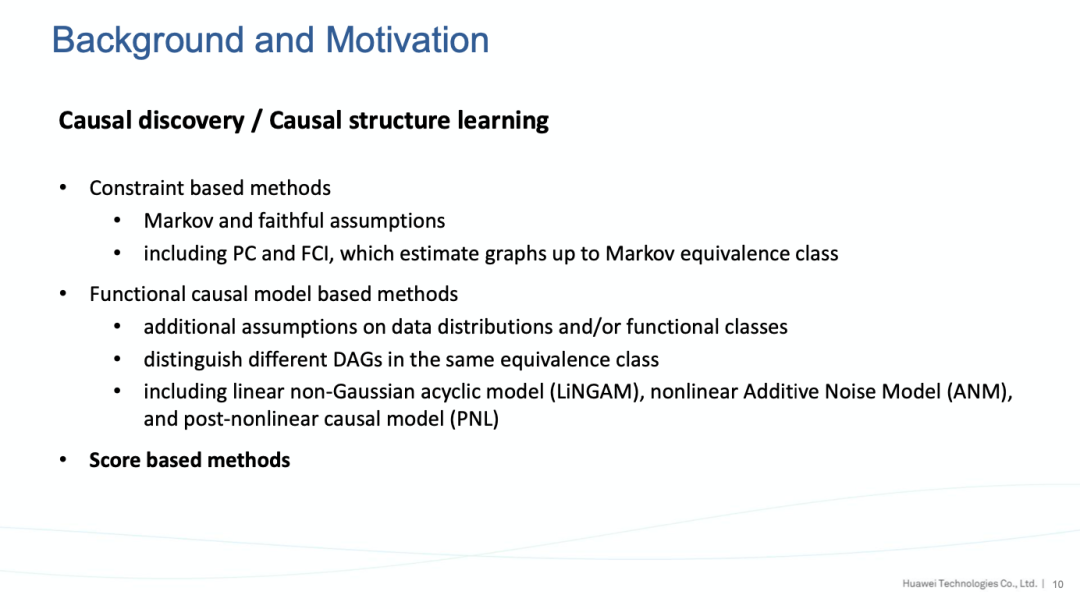

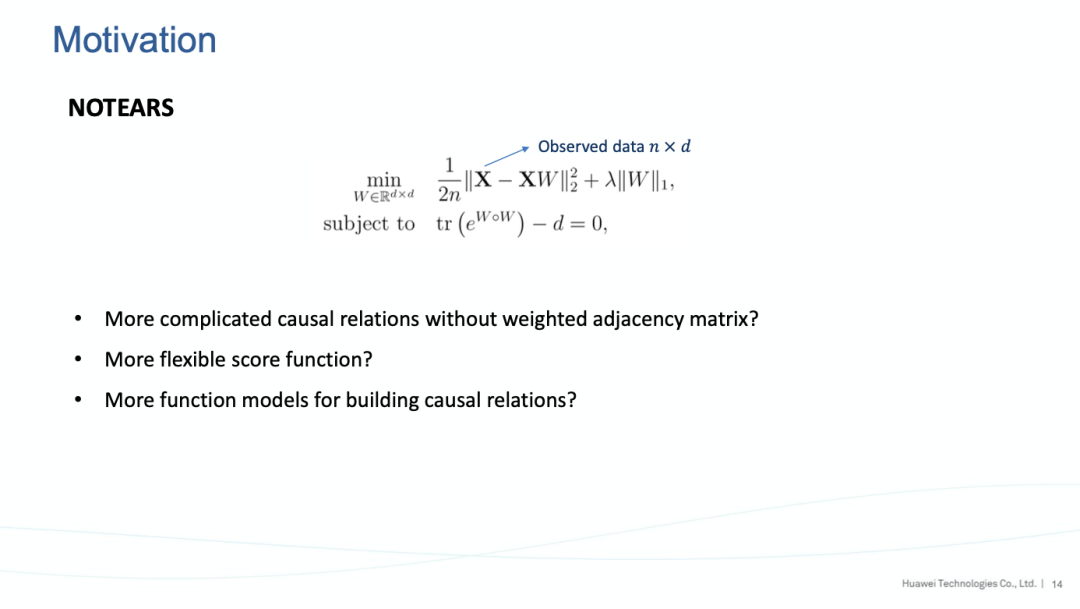

因果研究作为下一个潜在的热点,已经吸引了机器学习/深度学习领域的的广泛关注,例如Youshua Bengio和Fei-Fei Li近期都有相关的工作。因果研究中一个经典的问题是“因果发现”问题——从被动可观测的数据中发现潜在的因果图结构。

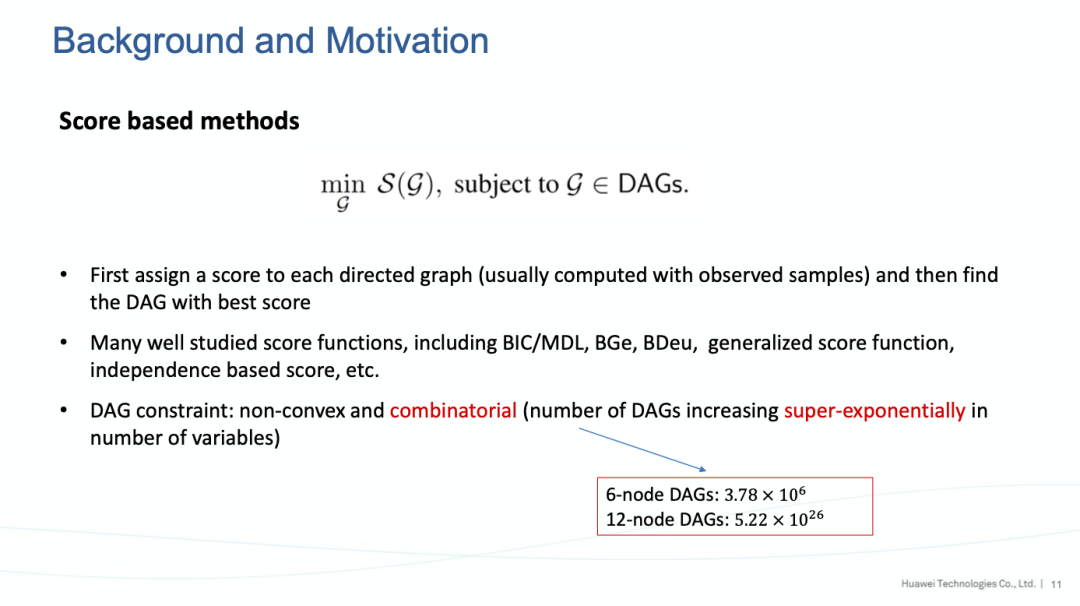

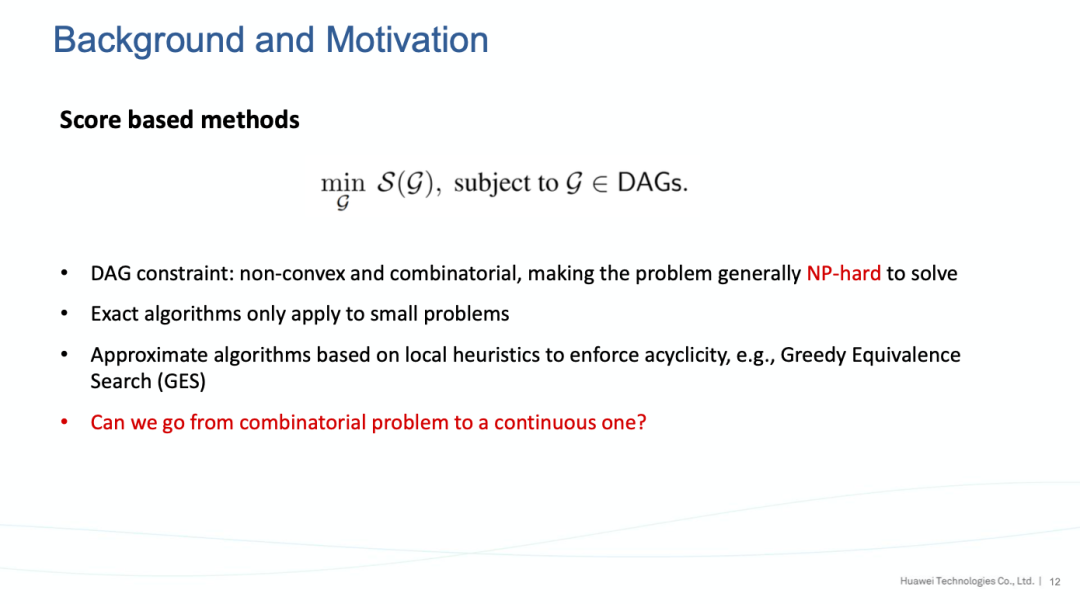

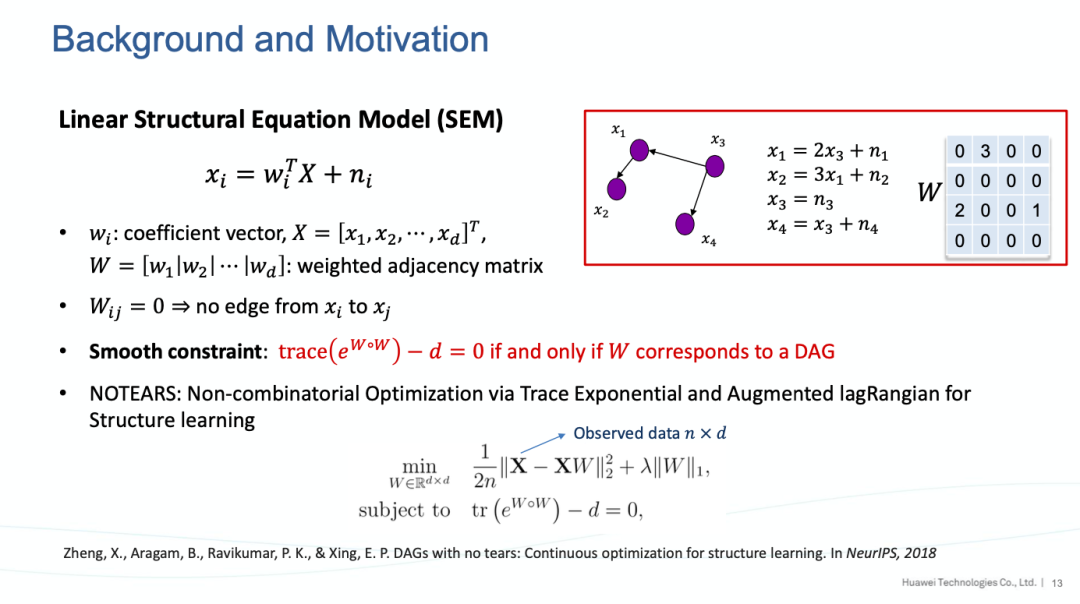

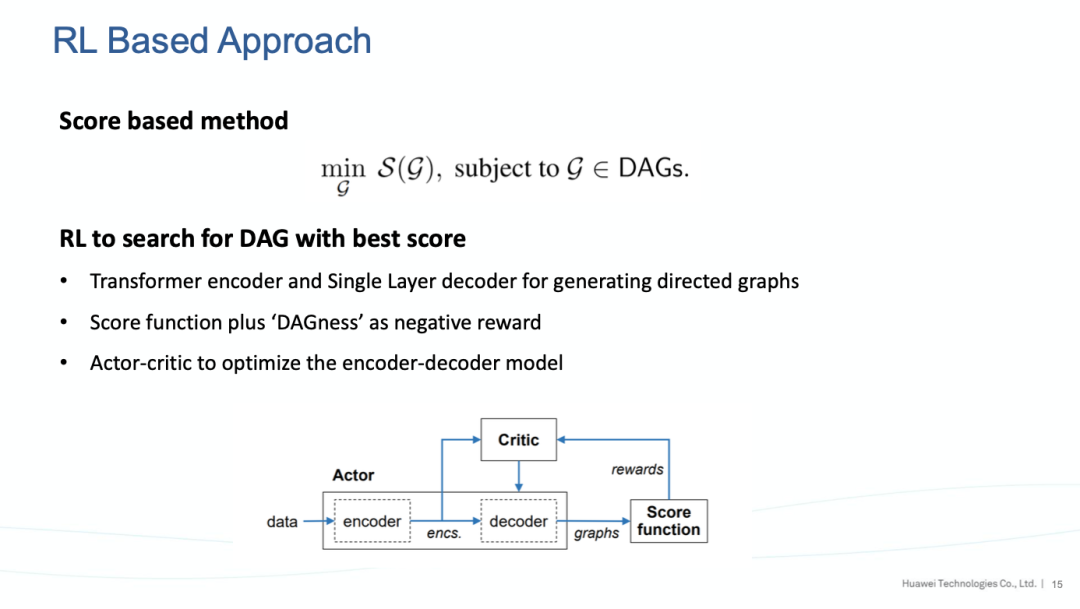

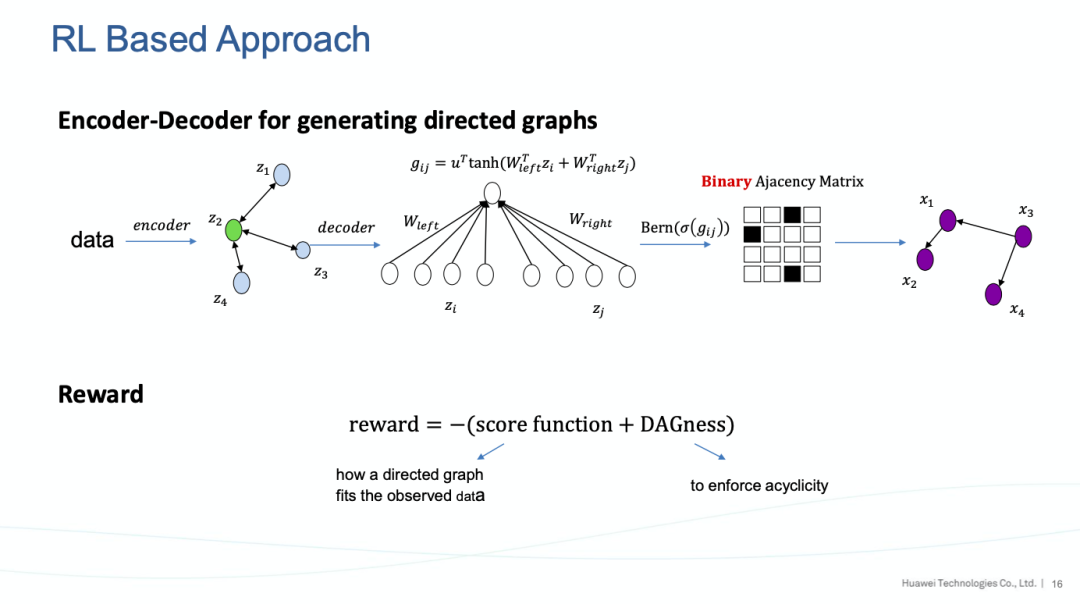

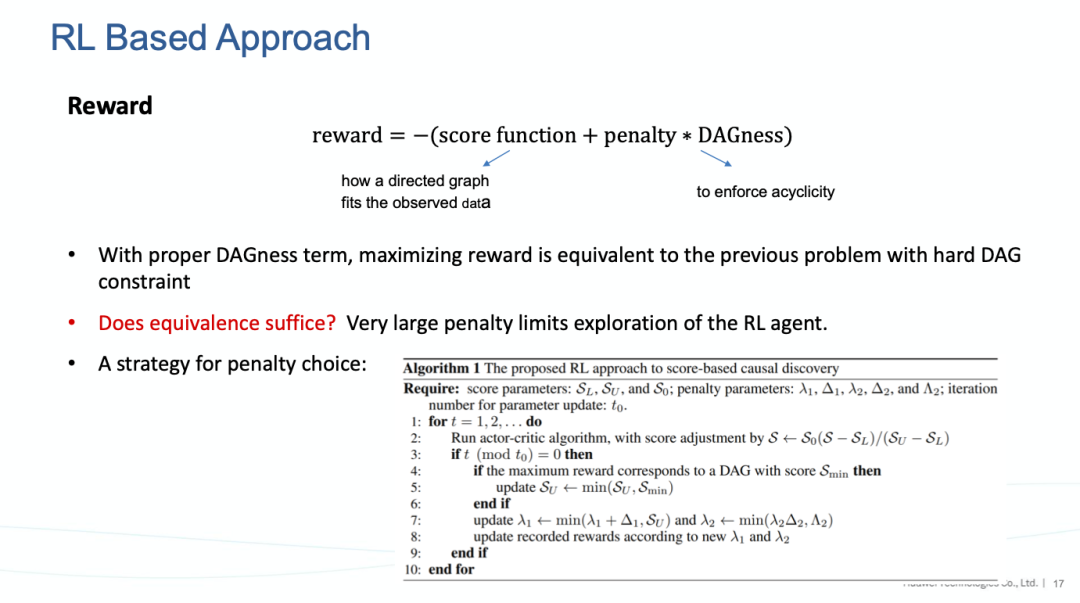

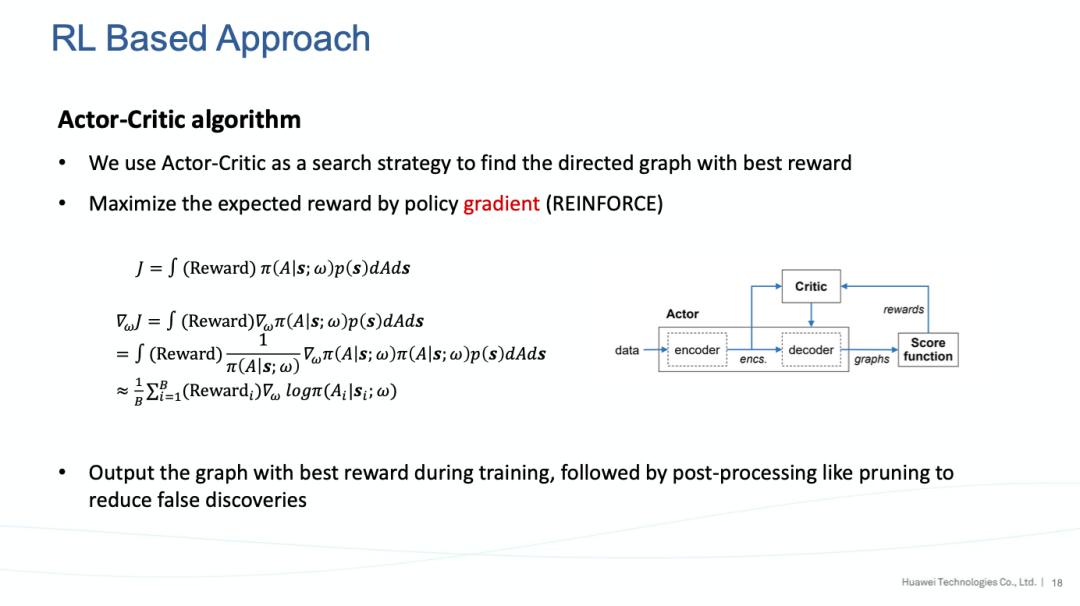

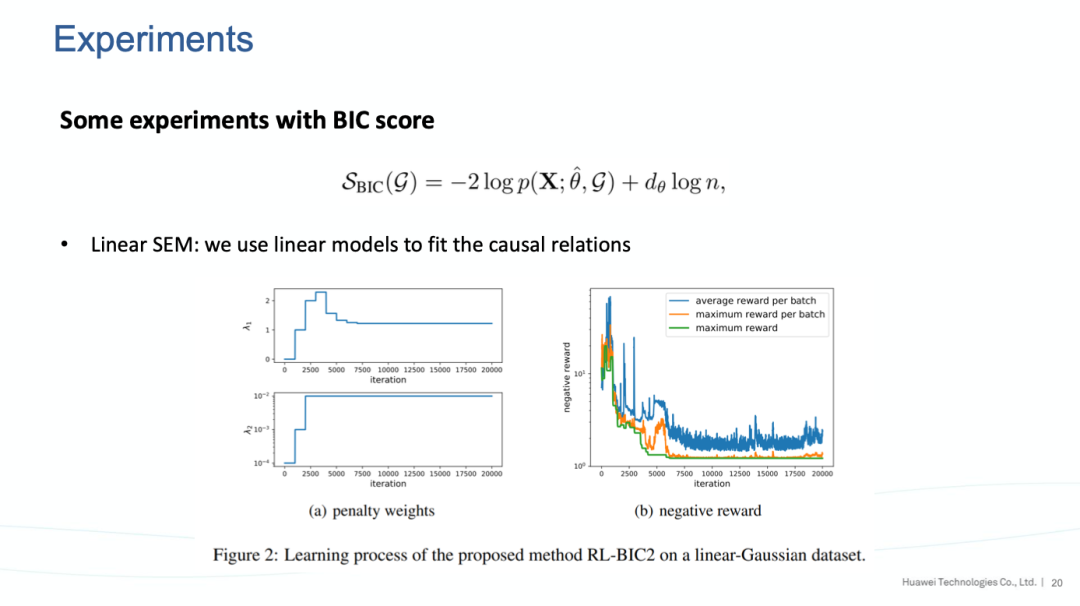

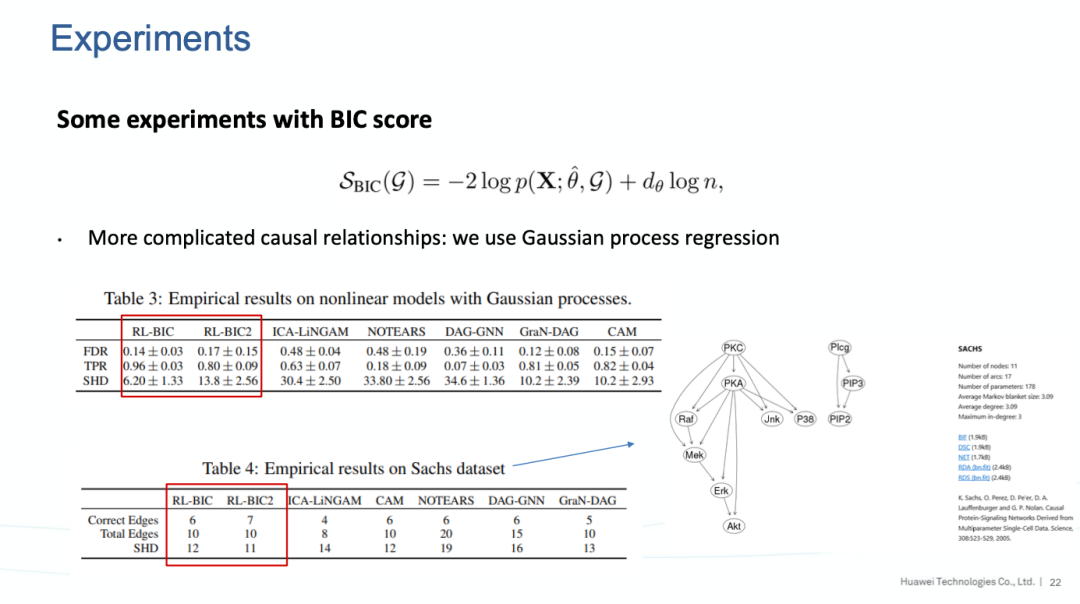

华为诺亚方舟实验室因果研究团队将强化学习应用到打分法的因果发现算法中,通过基于自注意力机制的encoder-decoder神经网络模型探索数据之间的关系,结合因果结构的条件,并使用策略梯度的强化学习算法对神经网络参数进行训练,最终得到因果图结构。

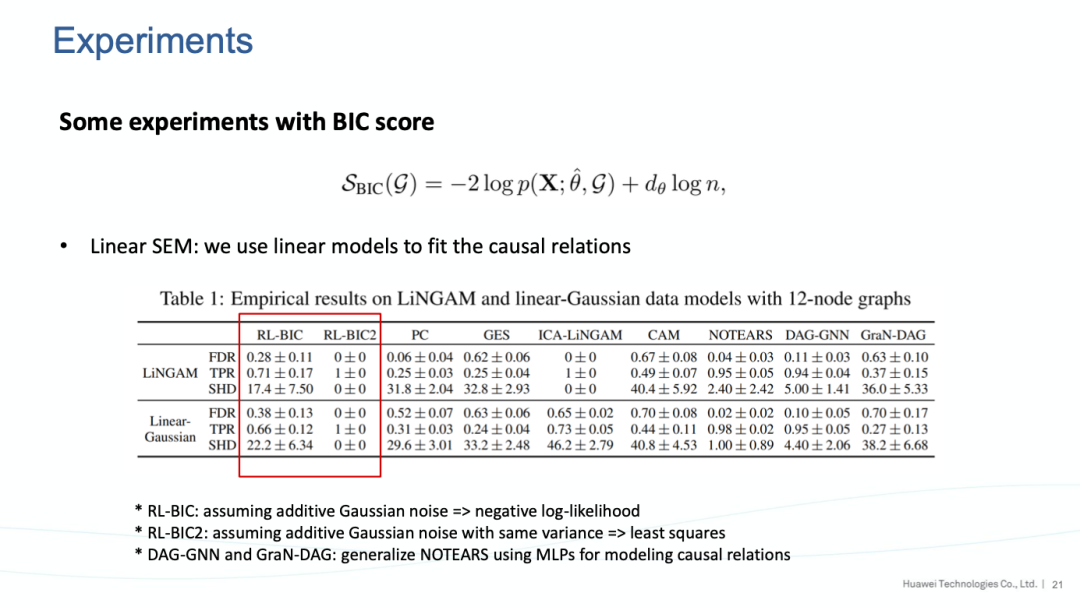

在学术界常用的一些数据模型中,该方法在中等规模的图上的表现优于其他方法,包括传统的因果发现算法和近期的基于梯度的算法。同时该方法非常灵活,可以和任意的打分函数结合使用。

PPT 展示:

完整PPT,可关注「AI科技评论」公众号,后台回复「朱胜宇@ICLR2020」下载。

火爆的图机器学习,ICLR 2020上有哪些研究趋势?

1、直播

03. Spotlight | 组合泛化能力太差?用深度学习融合组合求解器试试

04. Spotlight | 加速NAS,仅用0.1秒完成搜索

05. Spotlight | 华盛顿大学:图像分类中对可实现攻击的防御(视频解读)

4、Poster

01. Poster | 华为诺亚:巧妙思想,NAS与「对抗」结合,速率提高11倍

登录查看更多

相关内容

专知会员服务

131+阅读 · 2020年4月19日

Arxiv

4+阅读 · 2018年3月30日